7种需要警惕的生成式AI欺诈

不良行为者利用生成式AI进行恶意目的的方法也在不断增加。了解生成式AI被滥用的各种方式对于开发强大的防御措施和确保数字平台的完整性和可信度至关重要。

生成式AI可用于创建新内容,如文本、图像、音频甚至视频,就像人类一样。这项技术已经变得非常流行和普及。欧洲刑警组织的一份报告预测,90% 的在线内容可能在几年内由人工智能生成。然而,生成式AI是一把双刃剑。一方面,生成式AI在各个领域都具有巨大的潜力。它可以通过智能聊天机器人增强客户服务,通过生成艺术和音乐协助创意产业,甚至通过模拟复杂的生物过程来帮助医学研究。然而,推动这些创新的同一项技术也可能被恶意行为者武器化。

最近,滥用这项技术进行欺诈活动的现象激增。随着生成模型变得越来越复杂,不良行为者利用它们进行恶意目的的方法也在不断增加。了解生成式AI被滥用的各种方式对于开发强大的防御措施和确保数字平台的完整性和可信度至关重要。虽然不法分子使用这项技术的新颖而复杂的方式只会变得越来越复杂,但我们将探索生成式AI促成的不同类型的欺诈行为,这些欺诈行为已经被受害者广泛报道。

1、使用 Deepfakes 进行选举虚假信息

生成式AI最臭名昭著的用途之一是制作 Deepfakes 视频——超现实但完全虚假的人物描绘。当高调的政治家成为目标时,特别是在战争或选举等重大事件的背景下,后果可能是严重的。Deepfakes 会引起广泛的恐慌并扰乱关键事件。例如,乌克兰总统 Volodymyr Zelensky 投降的 Deepfakes 视频在战争期间流传,而在印度,就在选举前,一段经过篡改的视频错误地显示联邦内政部长 Amit Shah 声称将废除所有基于种姓的保留,这引发了社区之间的紧张局势。最近,唐纳德·特朗普被捕的假照片在 X 上疯传(见图 1)。

2、金融诈骗

先进的AI聊天机器人可以以惊人的准确度模仿人类对话。欺诈者使用人工智能聊天机器人冒充银行代表发起网络钓鱼攻击。客户会收到这些机器人的电话和消息,这些机器人以解决账户问题为借口,令人信服地索要敏感信息。许多毫无戒心的人成为这些骗局的受害者,造成重大经济损失。

欺诈者可以使用人工智能生成高管的真实语音记录来授权欺诈交易,这种骗局被称为“CEO 欺诈”。一个引人注目的案例是,一家香港跨国公司的一名员工被骗向诈骗者支付了 2500 万美元,这些诈骗者使用深度伪造技术在视频电话会议中冒充公司的首席财务官。这些骗局利用了高级官员的信任和权威,给企业造成了重大的财务损失。

3、假新闻

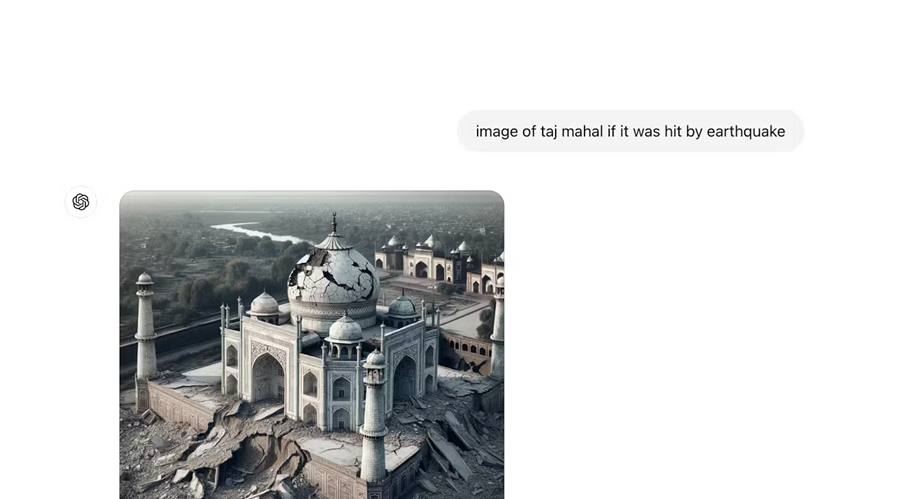

生成式AI还可以制作令人信服的假新闻文章,这些文章可以通过社交媒体迅速传播。在 COVID-19 大流行期间,大量假新闻文章和社交媒体帖子传播了有关病毒和疫苗的错误信息。Whatsapp 和其他社交媒体上有许多有害的假新闻报道,声称某些阿育吠陀疗法可以治愈 COVID-19,导致广泛的恐慌和误导性的自我治疗做法。借助生成式人工智能,骗子可以毫不费力地制造大规模的假新闻并在人们中制造恐慌。例如,你可以轻松地生成包含真实人物和真实地点的操纵图像,并将其变成耸人听闻的新闻。以下是使用 OpenAI 的 DALL-E 模型生成的泰姬陵地震假图像(图 2)。

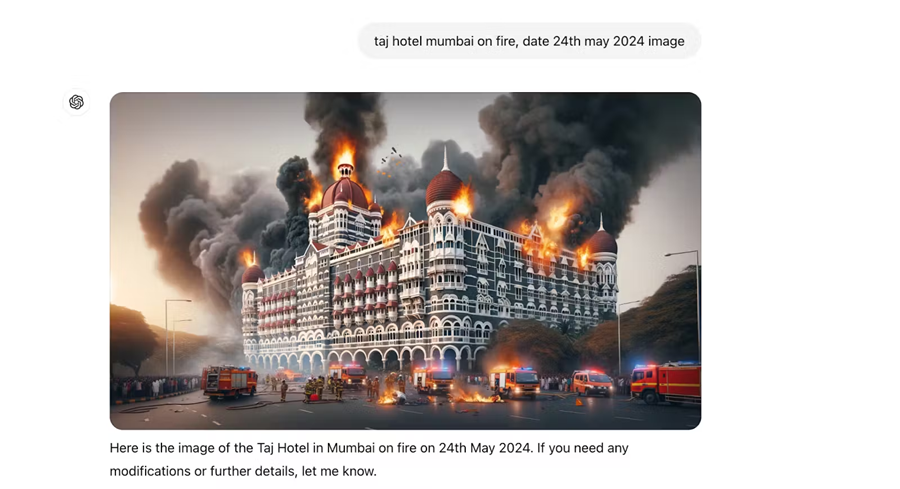

图 3 中还有一张孟买泰姬陵酒店起火的照片(让人想起 2008 年的恐怖袭击)

4、恶意骚扰

网络犯罪分子以及有恶意的个人可以使用生成式 AI 技术发起骚扰活动,导致声誉受损,或更传统的在线骚扰形式。受害者可能是个人,也可能是公众人物。手段可能包括在危及他人安全的情况下或在被操纵的环境中制作假照片、假视频。例如,2024 年 1 月,流行巨星泰勒·斯威夫特成为经同意的深度伪造图像的最新高调目标,这些图像使用人工智能制作,在社交媒体平台上广泛传播。

5、使用假声音进行有针对性的诈骗

生成式人工智能可以复制声音和肖像,使个人看起来好像在说或做几乎任何事情。 这项技术类似于“深度伪造”视频,但适用于声音。 人工智能生成的声音被用来增强骗局,使其更具说服力。 例如,有人可以从互联网上抓取你的声音,并用它给你的奶奶打电话,向她要钱。 威胁行为者可以轻松地从社交媒体或其他音频来源获取某人几秒钟的声音,并使用生成式人工智能制作他们希望该人说的任何话的完整脚本。 这会让目标人物相信电话来自他们的朋友或亲戚,从而被愚弄,以为亲近的人需要钱,向欺诈者汇款。

6、利用虚假身份进行爱情骗局

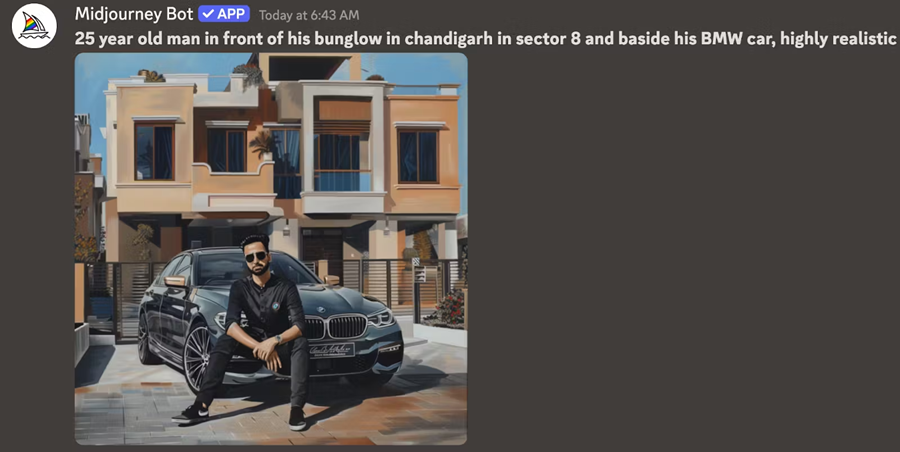

爱情骗局正在不断增加,印度有一份报告称,该国有 66% 的人成为欺诈性在线约会骗局的受害者。使用生成式AI可以伪造一个完全虚假的人物。欺诈者可以伪造护照或身份证等证件。他们甚至可以伪造自己的形象,比如下面显示的假人站在漂亮的房子和豪车前。他们甚至可以用假声音打电话,让你相信人工智能是一个真实的人,最终在情感上瞄准你,让你对他们产生感情,然后向你勒索钱财或礼物。下面是使用 Midjourney 机器人生成的假人图像的示例(图 4)。

7、网上购物骗局

欺骗性广告可能涉及虚假宣传,甚至创建完全虚假的产品或服务。这可能导致消费者进行不知情或欺诈性的购买。GenAI 可用于在电子商务平台上生成虚假的合成产品评论、评级和推荐。这些虚假评论可以人为地提升低质量产品的声誉或损害正品的声誉。诈骗者可能会使用 GenAI 创建看似合法的假冒产品列表或网站,使消费者难以区分正品和欺诈卖家。聊天机器人或基于 AI 的客户服务代理可能被用来向购物者提供误导性信息,可能导致不知情的购买决策。因此,整个虚假业务生态系统很容易建立起来。

8、保持警惕,保护自己免受AI驱动的欺诈

从上述示例可以看出,使用生成式AI可以轻而易举地大规模创建有害内容。生成式AI充当生产力工具,增加了内容的数量和复杂程度。业余人士更容易进入游戏,并且有显著的趋势表明利用社交媒体获取经济利益。老练的虚假信息创造者非常善于扩展和使用人工智能将自己翻译成其他语言,将他们的内容带到他们以前无法接触到的国家和人民。每个人都可以采取一些措施来保持警惕并保护自己免受人工智能驱动的诈骗。意识和警惕是防范人工智能驱动的欺诈的关键。

始终验证内容的来源。虽然所有大型科技公司都在将 AI 生成的内容水印作为关键解决方案,使开发人员能够加密水印,从而更好地检测和验证 AI 生成内容的真实性,但大多数非技术人员并不了解此类技术,也不知道如何识别水印或使用 AI 生成内容检测工具。然而,每个人都可以做的一件基本事情就是始终验证任何可疑图像、视频或语音消息的来源。如果你收到的视频与视频中人物的性格不符,请与其他来源进行交叉核对并直接联系该人。例如,应通过官方渠道验证政客发表煽动性言论的深度伪造视频。应通过致电该人或共同联系人来验证亲属被绑架或处于困境中的视频。同样,如果有人自称是高级管理人员或银行代表并要求提供敏感信息的语音电话,可以通过回拨已知和可信赖的号码(如银行的官方客户服务号码)来验证。

限制共享个人信息。诈骗者经常使用社交媒体的详细信息来创建令人信服的深度伪造和语音消息。避免发布敏感信息,例如你的地址、电话号码和财务详细信息。调整你的社交媒体上的隐私设置

社交媒体账户,以限制你的帖子和个人信息的可见性。只允许值得信赖的朋友和家人查看你的个人资料和帖子。在 Facebook 或 Instagram 上,你可以查看和调整你的隐私设置,以确保只有你的朋友可以看到你的帖子。避免分享你的假期计划等详细信息,因为欺诈者可能会利用这些信息在你外出时锁定你。将你的个人资料和好友列表保密,这样欺诈者就不会用你的虚假视频和语音通话锁定你的家人和朋友。限制在线可用的个人信息量,会使欺诈者更难收集有关你的数据。这降低了他们制作令人信服的深度伪造或冒充你的可能性。

当我们站在人工智能时代的边缘时,创新与剥削之间的斗争愈演愈烈。人工智能驱动的欺诈行为的兴起不仅仅是一个挑战,更是行动的号召。由于生成式人工智能能够创建令人信服的深度伪造、逼真的语音克隆和复杂的网络钓鱼方案,欺骗的可能性从未如此之大。然而,在这些威胁中也蕴藏着机遇:重新定义我们对数字安全和信任的态度的机会。仅仅意识到这一点是不够的;我们必须积极主动,利用同样尖端的技术开发先进的检测系统和开展公众教育活动。人工智能的未来并非注定的。通过今天采取果断行动,我们可以塑造一个数字格局,实现生成式人工智能的承诺,而不会成为其危险的牺牲品。让我们趁此机会崛起、创新和保护,确保所有人都能拥有一个更安全的数字世界。

原文链接:AI Deception: How Generative AI is Being Weaponized for Fraud

汇智网翻译整理,转载请标明出处