DeepSeek-R1本地运行成本

DeepSeek 将这场生成竞赛提升到了另一个水平,人们甚至准备在本地运行 671B 参数。但在本地运行如此庞大的模型可不是开玩笑;你需要在硬件方面取得一些重大进步,才能尝试推理。

DeepSeek 将这场生成竞赛提升到了另一个水平,人们甚至准备在本地运行 671B 参数。但在本地运行如此庞大的模型可不是开玩笑;你需要在硬件方面取得一些重大进步,才能尝试推理。

这篇博客粗略地分析了在 PC 上运行 DeepSeek-R1 需要花费多少钱

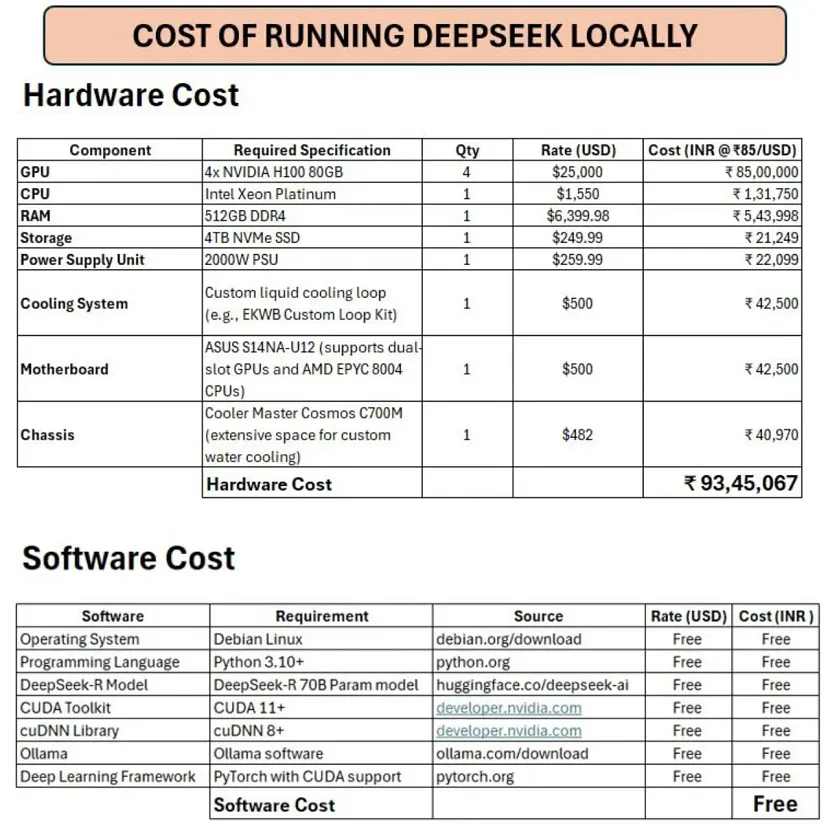

1、硬件成本

大部分费用在于硬件。我们将讨论 GPU、CPU、RAM、SSD 存储、冷却系统等

GPU

- 4 个 NVIDIA H100 80GB GPU(每个 25,000 美元)

- 总成本:₹85,00,000(100,000 美元)

- 为什么?这些 GPU 是针对 AI 工作负载优化的尖端加速器,可为 DeepSeek-R1 等大型模型提供更快的训练和推理。

NVIDIA H100:NVIDIA H100 是基于 Hopper 架构构建的高级 GPU。它具有第四代 Tensor Cores 和 Transformer Engine,与之前的 A100 GP 相比,AI 训练速度提高了 9 倍,推理速度提高了 30 倍

CPU

- Intel Xeon Platinum(1,550 美元)

- 总成本:₹1,31,750

- 为什么?高端 CPU 可确保在资源密集型操作期间实现流畅的多任务处理和系统稳定性。

DeepSeek-R1 推理需要 Intel Xeon Platinum,因为它具有先进的 AI 加速功能,例如 Intel AMX 和 AVX-512,可显著提高深度学习任务的性能。

与前几代产品相比,它还提供高达 42% 的 AI 推理性能,使其成为苛刻工作负载的理想选择。此外,其优化的内存和互连可确保高效处理大型数据集和复杂模型。

RAM

- 512GB DDR4(6,399.98 美元)

- 总成本:₹5,43,998

- 为什么?大内存对于处理大量数据集和模型参数而不会降低速度至关重要。

存储

- 4TB NVMe SSD(249.99 美元)

- 总成本:₹21,249

- 为什么?快速存储可确保在训练期间快速访问数据。

SSD(固态硬盘)是一种使用闪存存储数据的存储设备,与传统硬盘(HDD)相比,它具有更快的读/写速度、耐用性和能效。

4TB NVMe SSD 具体指使用 NVMe(非易失性内存 Express)协议的高容量(4 TB)硬盘,它利用 PCIe 接口实现比旧版 SATA SSD 快得多的数据传输速率。NVMe SSD 非常适合游戏、视频编辑或服务器等要求严格的任务,这些任务对速度和大容量存储至关重要。

电源单元 (PSU)

- 2000W PSU(259.99 美元)

- 总成本:₹22,099

- 为什么?需要高功率才能可靠地为多个 GPU 供电。

冷却系统

- 定制液体冷却回路(500 美元)

- 总成本:₹42,500

- 为什么?GPU 会产生大量热量 - 液体冷却可防止过热。

主板

- ASUS S14NA-U12(500 美元)

- 总成本:₹42,500

- 为什么?支持双插槽 GPU 和高端 CPU。

机箱

- Cooler Master Cosmos C700M(482 美元)

- 总成本:₹40,970

- 为什么?宽敞的机箱可容纳定制冷却和多个 GPU。

总计(硬件):₹93,45,067 ($106776)

2、软件成本

运行 DeepSeek-R1 的软件是免费的,但你需要:

- 操作系统:Debian Linux(免费)

- 编程语言:Python 3.10+(免费)

- DeepSeek-R 模型:70B 参数模型(免费)

- CUDA 工具包和 cuDNN:NVIDIA 的深度学习库(免费)

- 深度学习框架:支持 CUDA 的 PyTorch(免费)

总计(软件):₹0

3、关键要点

- 硬件占成本主导地位:GPU、RAM 和冷却系统占总费用的约 99%。

- 所需的技术专业知识:设置此系统需要熟悉高性能计算。

- 替代方案:云服务(例如 AWS、Google Cloud)对于短期项目来说可能更便宜,但会产生经常性成本。

值得吗?对于资金雄厚且有特定需求(例如隐私、离线工作)的研究人员、企业或业余爱好者来说,本地设置提供了无与伦比的控制和速度。对于其他人来说,云平台或较小的模型可能更实用。

那么,你打算在本地运行 DeepSeek-R1 吗?再想想

原文链接:How much does it cost to run DeepSeek-R1 locally?

汇智网翻译整理,转载请标明出处