CoTracker3点跟踪模型综合指南

CoTracker3 是一种尖端的人工智能模型,专为跟踪视频中多个帧中的点而设计。它适用于 3D 重建、视频编辑甚至动作捕捉等应用。

Meta 的 CoTracker3 最近以全新的点跟踪方法进入了人工智能领域,这是计算机视觉的一项核心任务。无论是跟踪视频帧中的点、分析运动镜头,还是处理遮挡和快速移动,CoTracker3 都能让工作更轻松、更快速、更准确。该模型基于 TAPIR 和 BootsTAPIR 等早期版本,但使用伪标签来提高性能,脱颖而出。

那么,是什么让 CoTracker3 值得你关注?让我们来看看它的核心功能以及它如何超越其前辈。

1、CoTracker3 简介

CoTracker3 是一种尖端的人工智能模型,专为跟踪视频中多个帧中的点而设计。它适用于 3D 重建、视频编辑甚至动作捕捉等应用。

如果你曾经处理过视频,就会知道跟踪点是多么困难,尤其是当它们快速移动或消失在物体后面时。 CoTracker3 旨在通过更高效、更准确的解决方案解决该问题。

“CoTracker3 通过利用伪标签简化点跟踪,减少了对手动标注数据的需求。”

2、CoTracker3 的主要功能

CoTracker3 具有一些突出的功能,使其不同于其他点跟踪模型。让我们分解一下主要元素:

- 伪标签 - 游戏规则改变者

伪标签允许 CoTracker3 使用未标记的视频数据并生成合成标签。这节省了大量时间,因为您不需要手动标记大型数据集。此外,该模型通过随着时间的推移完善这些伪标签来改进自身,从而实现更准确的跟踪。

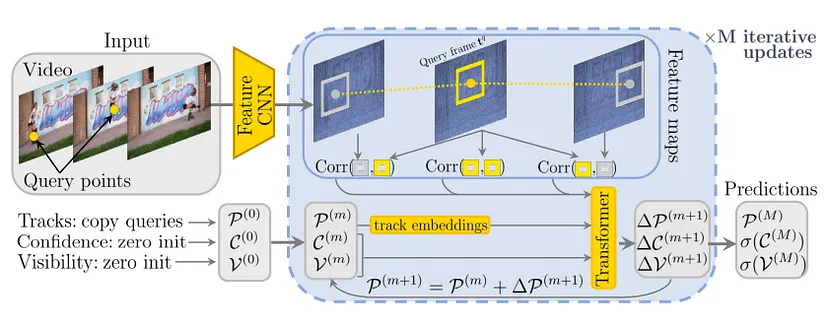

- 精简高效的架构

CoTracker3 采用更简单的架构设计,但可提供高精度。它并行处理多个帧,这意味着实时或近实时应用程序可以更快地获得结果。其轻量级设计使其即使在资源有限的项目中也易于使用。

- 处理遮挡和复杂运动

点跟踪中最棘手的挑战之一是当一个物体消失在另一个物体后面(遮挡)或移动速度太快而模型无法跟踪时。CoTracker3 可以预测点将重新出现的位置,使其在体育镜头或拥挤环境等复杂场景中高度可靠。

3、CoTracker3 有什么新功能?

CoTracker3 通过添加新功能并使跟踪过程更顺畅,改进了 TAPIR 等旧模型。一些最新功能包括:

- 改进的多对象跟踪:现在更容易在同一场景中跟踪多个点。无论你是在跟踪场地上的几名运动员还是在繁忙的视频中跟踪多个物体,CoTracker3 都能无缝处理。

- 对低质量素材的适应性:并非所有视频都是以高清拍摄的,CoTracker3 考虑到了这一点。即使在低分辨率或抖动的视频上,它也能表现良好,使其成为适用于各个行业的多功能工具。

“CoTracker3 旨在在高质量和低质量视频环境中表现出色,使其成为当今人工智能中适应性最强的模型之一。”

4、为什么 CoTracker3 脱颖而出?

与其前代产品不同,CoTracker3 消除了点跟踪的复杂性,而不会牺牲性能。以下是它脱颖而出的一些原因:

- 处理速度更快:该模型针对速度进行了优化,处理帧的速度比以前的版本更快。

对遮挡更具鲁棒性:CoTracker3 可以预测隐藏点将重新出现的位置,从而提高困难场景中的跟踪准确性。 - 减少对人工标注数据的依赖:得益于伪标注,模型可以自我训练,从而减少手动数据标注所需的时间和成本。

CoTracker3 是点跟踪的一项突破,提供了比以往更高效、更准确、更用户友好的方法。无论你是初学者还是已经涉足 AI 领域一段时间的人,CoTracker3 都可以简化复杂的任务,而不会影响结果。最好的部分是什么?最近的发布使这个工具更加易于使用!

如果你在阅读上面的内容后对 CoTracker3 感到兴奋(你完全应该如此),这篇博客将指导你完成开始使用该模型的实际步骤。从设置环境到运行演示和执行推理,我都为你准备好了。所以,拿起咖啡,让我们开始使用 CoTracker3 进行安装、演示和推理之旅吧!

5、安装 CoTracker3

首先,让我们设置你的环境并安装 CoTracker3。开发人员已经将设置变得相对简单。按照这些简单的步骤启动并运行模型。

首先,你需要从 GitHub 克隆官方 CoTracker3 存储库:

git clone https://github.com/cotracker3/cotracker3.git导航到目录:

cd cotracker3CoTracker3 需要特定的依赖项,处理它们的最简单方法是使用提供的 environment.yml 文件创建 Conda 环境。运行以下命令:

conda env create -f environment.yml创建环境后,将其激活:

conda activate cotracker3就这样,你的环境就准备好了!

6、运行演示

现在已经安装了 CoTracker3,让我们运行演示来查看它的实际效果。此步骤将让你了解 CoTracker3 如何跨视频帧跟踪点。

你需要一个示例视频来测试跟踪功能。如果已准备好视频,请将其放在目录中(例如, data/videos/)。你也可以使用存储库中提供的预下载视频之一。

CoTracker3 附带一个方便的演示脚本,可跟踪视频帧中的点。以下是运行演示的命令:

python demo.py --video_path data/videos/sample_video.mp4 --output_path results/这将处理视频并将跟踪结果输出到 results/ 目录中。现在你应该看到 CoTracker3 如何跟踪不同帧中的特定点,即使有遮挡和快速移动。很酷,对吧?

7、使用 CoTracker3 进行推理

使用 CoTracker3 运行推理轻而易举。无论你是想跟踪新视频中的点还是分析数据集,推理过程都有据可查且易于执行。

以下是使用预训练模型对新视频进行推理的方法:

python inference.py --video_path data/videos/new_video.mp4 --model_path models/pretrained_cotracker3.pth --output_path results/此命令使用预训练的 CoTracker3 模型 ( pretrained_cotracker3.pth) 处理输入视频,并将结果保存在 results/ 目录中。推理输出将包含视频帧中的跟踪点,你可以使用任何视频播放器或视频分析工具将其可视化。

CoTracker3 提供预训练模型,帮助你立即开始使用,而无需从头开始训练模型。您可以从官方 CoTracker3 GitHub 或模型中心下载最新的预训练模型:

wget https://cotracker3.github.io/pretrained_models/pretrained_cotracker3.pth确保将模型放在一个在推理期间可以轻松访问的目录中(例如 models/ 文件夹)。

“使用预训练模型,你可以开箱即用地测试 CoTracker3,而无需从头开始训练!”

CoTracker3 还允许你对执行推理的方式进行一些自定义。你可以指定其他参数,例如置信度阈值或要跟踪的点数。以下是一个简单的示例:

python inference.py --video_path data/videos/new_video.mp4 --model_path models/pretrained_cotracker3.pth --conf_thresh 0.5 --num_points 100 --output_path results/在此示例中, --conf_thresh 设置置信度阈值, --num_points 指定视频中要跟踪的点数。CoTracker3 在推理方面提供的灵活性使其成为各种用例的强大工具,无论你是跟踪少数几个点还是一百个点。

8、快速故障排除提示

虽然 CoTracker3 非常稳定,但你在设置时可能会遇到一些问题。以下是一些常见问题和修复方法:

- 问题:安装过程中缺少依赖项。修复:检查是否使用正确的

environment.yml文件创建了 Conda 环境。 - 问题:视频处理速度很慢。修复:确保使用 GPU 进行更快的处理。你可以在环境设置中指定 GPU 使用情况。

- 问题:未跟踪任何点。修复:确保你的视频输入有效并且模型已正确加载。

我们已经介绍了什么是 CoTracker3 以及如何开始使用它,包括安装、运行演示和执行推理。但是,如果你希望使用自己的数据训练 CoTracker3 并对其进行自定义以满足您的特定需求,那么下面的内容非常适合你。

无论你是在跟踪体育视频、交通镜头还是任何自定义视频数据集中的点,微调 CoTracker3 都会让你更好地控制模型的性能。准备好了吗?让我们开始训练和微调吧!

9、准备自定义数据集

微调 CoTracker3 的第一步是准备好你的数据集。该模型需要视频输入,但也需要标注(你要跟踪的点的坐标)。那么让我们逐步介绍如何准备数据集。

为了训练 CoTracker3,你需要以模型可以理解的方式构建数据集。通常,数据集应包括:

- 视频:将原始视频放在文件夹 (

data/videos/) 中。 - 标注:CoTracker3 需要点标注(点位于每个帧中的位置)。这些标注应采用

.json或.txt格式并放置在data/annotations/中。

示例文件夹结构:

data/

│

├── videos/

│ ├── custom_video1.mp4

│ ├── custom_video2.mp4

│

└── annotations/

├── custom_video1.json

├── custom_video2.json“确保你的标注准确且格式正确,因为它们在微调过程中起着关键作用。”

10、设置训练配置

数据集准备就绪后,就该配置训练设置了。 CoTracker3 附带一个训练配置文件,你可以自定义它以匹配你的数据集和目标。让我们来分解一下。

找到 config/train_config.yaml 文件。此文件控制训练过程,包括超参数、模型架构和数据集路径。以下是你需要修改的内容:

数据集路径:指定自定义数据集的路径。

dataset:

video_path: "data/videos/"

annotation_path: "data/annotations/"

超参数:调整学习率、批次大小和时期数以适合你的数据集。

training:

epochs: 100

batch_size: 4

learning_rate: 0.001你可以根据自己的特定需求调整这些超参数。例如,如果数据集较小,则可能需要减小批次大小。

11、在你的数据集上训练 CoTracker3

现在你的数据集已准备就绪,并且你的配置文件已设置好,是时候开始训练了。这就是奇迹发生的地方!

要训练 CoTracker3,你可以运行提供的 train.py 脚本。以下是启动训练过程的基本命令:

python train.py --config config/train_config.yaml这将使用你的自定义数据集和配置文件中指定的设置启动训练过程。随着训练的进行,你将看到输出日志显示模型的损失、准确性和其他指标随着时间的推移而改善。

如果你正在处理大型数据集,则在 GPU 上进行训练将大大加快速度。确保已安装 CUDA,然后在多个 GPU 上运行训练:

CUDA_VISIBLE_DEVICES=0,1,2,3 python train.py --config config/train_config.yaml此命令将利用所有可用的 GPU,显著加快训练过程。

步骤 4:评估和微调模型

模型训练完成后,您需要评估其性能。CoTracker3 提供了几种方法来执行此操作,允许您在需要时进一步微调模型。

12、评估模型性能

你可以使用 eval.py 脚本评估训练后的模型。这将让你深入了解 CoTracker3 跟踪视频中点的效果:

python eval.py --model_path models/custom_cotracker3.pth --video_path data/videos/test_video.mp4评估脚本将输出各种指标,包括准确率、精确率和召回率。根据这些结果,您可以调整训练参数并重新训练模型以获得更好的性能。

如果结果不如你所期望的那样,可以返回并调整超参数,例如学习率、批量大小或时期数。然后,只需重新启动训练过程即可。

13、导出训练模型

一旦你对经过微调的 CoTracker3 模型感到满意,就可以将其导出进行推理了。你可以将训练后的模型权重保存为 .pth 格式,并使用它们对新数据进行推理:

python export_model.py --model_path models/custom_cotracker3.pth --output_path models/final_model.pth此导出的模型现在可用于任何推理任务,以及跟踪来自各种来源的视频中的点。

14、有效微调的技巧

以下是微调 CoTracker3 的一些最佳实践:

- 从预训练模型开始:从预训练模型进行微调通常会比

- 从头开始训练。这样可以节省时间并提高准确性。

- 密切监控训练:密切关注训练日志,尽早发现任何问题。如果损失没有减少或波动太大,你可能需要调整学习率或批量大小。

- 经常验证:在训练期间定期运行验证测试,以确保模型不会过度拟合训练数据。

原文链接:CoTracker3: The Latest AI Model for Superior Point Tracking

汇智网翻译整理,转载请标明出处