DeepSeek R1纯净版本地运行指南

本文探讨了DeepSeek-R1纯净版模型的独特之处及其与原始DeepSeek R1的关系,并介绍了如何使用Ollama在本地运行它。

开源语言模型的兴起使强大的AI工具更加普及,让开发者、研究人员和爱好者能够试验尖端技术,而无需依赖基于云的API。在这些创新中,deepseek-r1-abliterated 作为DeepSeek第一代推理模型的一个突破性的纯净变体脱颖而出。本文探讨了该模型的独特之处及其与原始DeepSeek R1的关系,并介绍了如何使用Ollama在本地运行它。

1、什么是deepseek-r1-abliterated?

Deepseek-r1-abliterated 是DeepSeek R1模型的一个干净的版本,这是一种为高级推理任务设计的最先进语言模型。原始的DeepSeek R1因其性能可与OpenAI的o1等专有模型相媲美而受到关注,但它包括限制有害或敏感输出的安全机制。通过“abliteration”过程,“abliterated”版本去除了这些安全措施,生成的内容没有预定义的限制。

这种方法允许用户探索创意、争议性或利基应用,同时保留原始模型的核心推理能力。然而,这种自由伴随着伦理责任,因为该模型可能会产生不适当或不安全的内容,如果没有适当的监督。

在本地部署deepseek-r1-abliterated提供了几个优势:

- 隐私:数据永远不会离开你的机器,这对于敏感应用至关重要。

- 节省成本:避免与基于云的模型相关的每次API费用。

- 定制化:通过系统提示和参数定制模型的行为。

- 离线使用:无需互联网连接即可运行。

像Ollama这样的工具简化了本地部署,让用户能够轻松管理并运行大型语言模型(LLMs)。

2、原始DeepSeek R1:简要概述

DeepSeek R1 是一种创新工具,因其强大的未经审查的搜索和查询功能而受到关注。专为开发者和数据爱好者设计,DeepSeek R1让你可以绕过传统限制,访问未过滤的原始数据。这种自由对于需要全面洞察力的项目特别有益。

凭借其强大的架构,DeepSeek R1提供了不受审查算法约束的快速搜索功能。这一独特功能让用户能够深入研究数据集,探索广泛的结果,并执行对研究和开发至关重要的高级查询。

Deepseek R1的优点包括:

- 推理能力:在AIME和MATH等基准测试中优于许多模型。

- 成本效益:开放权重减少了对昂贵云服务的依赖。

- 灵活性:兼容本地部署和自定义。

然而,其内置的安全过滤器限制了其在无限制实验中的实用性——这一缺口由abliterated版本填补。

2、Abliteration提纯过程

Abliteration 指的是从语言模型中移除拒绝机制的技术过程。与通常需要重新训练的传统微调不同,abliteration通过分析有害和无害指令对来识别并中和神经网络中的“拒绝方向”,从而修改模型内部激活模式以抑制其拒绝某些提示的趋势。这不需要重新训练,而是保持基础模型的权重基本不变。

Abliteration的关键方面:

- 无需重新训练:基础模型的权重基本保持不变。

- 保留推理能力:核心功能不会因安全措施的移除而受到影响。

- 广泛的兼容性:适用于大多数基于Transformer的模型,如Hugging Face平台上的模型。

结果是一个保留了原始智能但没有护栏的模型,使其成为研究AI行为、对抗性测试或非常规创意项目的理想选择。

在这个生态系统中,Ollama 发挥着重要作用。作为集成合作伙伴,Ollama提供了补充DeepSeek R1的额外支持和功能。通过与Ollama连接,你可以简化开发流程,利用增强的性能分析,并享受与其他工具和系统的更流畅互操作性。

3、deepseek-r1纯净版本地运行方法

Ollama是一款轻量级工具,旨在简化个人电脑上LLMs的部署。以下是开始步骤:

3.1 安装Ollama

- Linux/macOS:在终端中运行

curl -fsSL https://ollama.com/install.sh | sh。 - Windows:从Ollama官方网站下载安装程序。

3.2 拉取模型

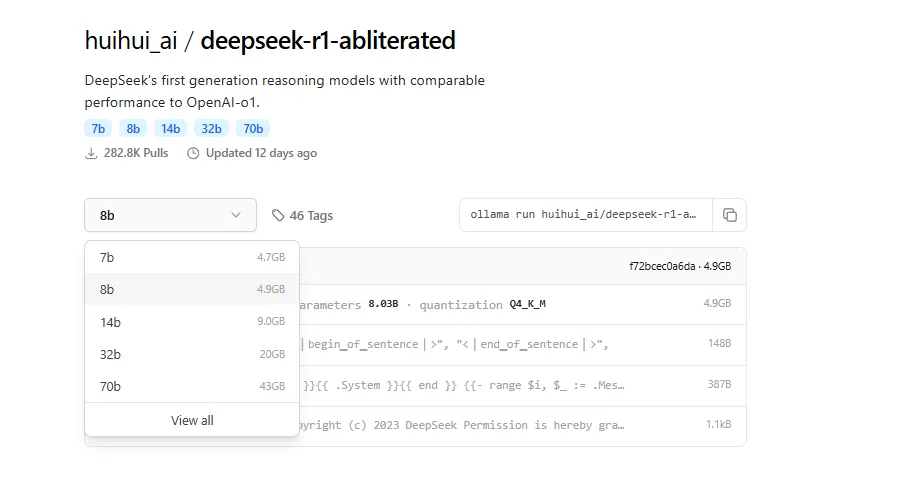

Deepseek-r1-abliterated有多种大小(7B、14B、70B参数)。使用以下命令下载你偏好的版本:

ollama pull huihui_ai/deepseek-r1-abliterated:[size]

将 [size] 替换为 7b、14b 或 70b。例如:ollama pull huihui_ai/deepseek-r1-abliterated:70b

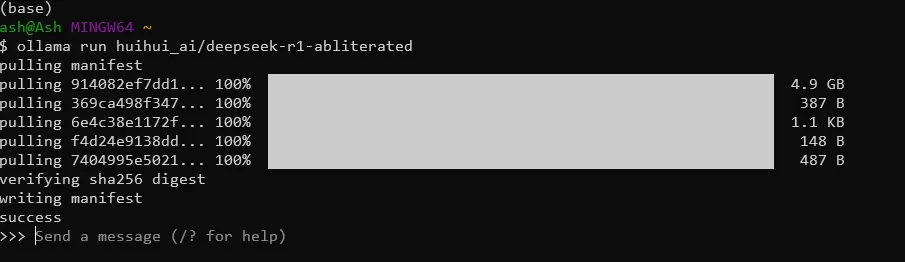

3.3 运行模型

启动一个交互式会话:

ollama run huihui_ai/deepseek-r1-abliterated:[size]

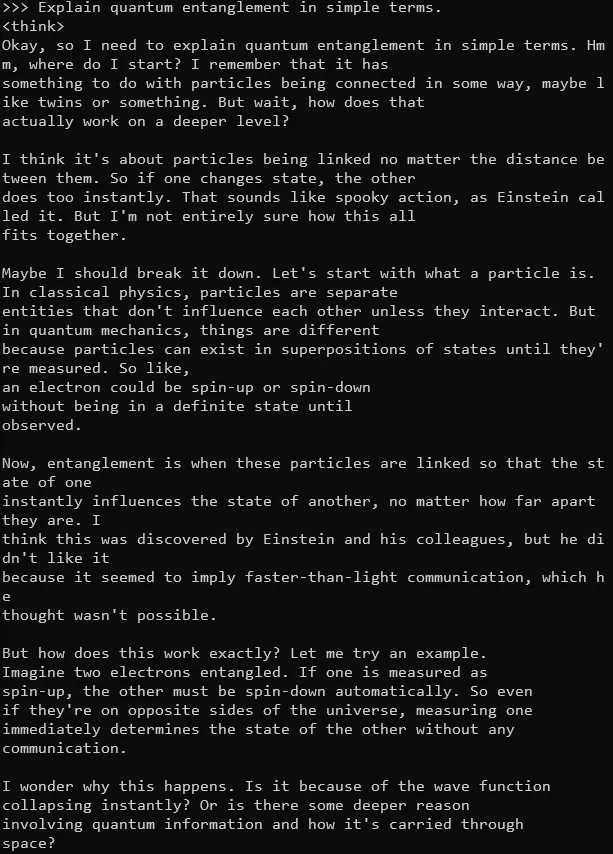

你现在可以直接在终端中输入提示。例如:

>>> 用简单的术语解释量子纠缠。

3.4 与应用程序集成

Ollama提供了一个REST API供编程访问。发送请求到 http://localhost:11434 以将模型集成到脚本、应用程序或自定义界面中。

4、硬件考虑因素

运行大型模型需要显著的资源:

- 内存:至少16GB用于较小的版本(7B),32GB+用于70B。

- 显存:推荐使用专用GPU(例如NVIDIA RTX 4090)以加快推理速度。

- 存储:模型范围从7B的4GB到70B的40GB。

为了获得最佳性能,如果可用,请使用量化版本(例如Q4_K_M),这可以在几乎不损失准确性的情况下减少内存使用。

5、结束语

Deepseek-r1-abliterated代表了开源AI的重要里程碑,为那些愿意应对其伦理复杂性的用户提供无与伦比的灵活性。通过利用Ollama等工具,用户可以在本地利用最先进的推理模型的力量,解锁创新和探索的可能性。无论你是研究人员、开发者还是爱好者,这个模型都为你提供了一个推动AI边界发展的沙盒——负责任地并在自己的条件下进行。

原文链接:Running Uncensored DeepSeek R1 on Local Machine

汇智网翻译整理,转载请标明出处