DeepSeek-R1本地运行指南

在本指南中,我将向你展示如何在本地安装 DeepSeek-R1,利用其编码能力,并可能每月节省数百美元。

厌倦了为高级 AI 模型支付高昂的订阅费用?认识 DeepSeek-R1,这是一款免费、开源且隐私优先的推理 AI,可与 OpenAI 每月 200 美元的 o1 模型相媲美。在本指南中,我将向你展示如何在本地安装 DeepSeek-R1,利用其编码能力,并可能每月节省数百美元。

1、DeepSeek-R1简介

DeepSeek-R1 不仅仅是另一个 AI 模型,它是推理 AI 模型的一场革命,它提供的性能可与 OpenAI 每月 200 美元的 o1 模型相媲美,同时它还是免费、开源、本地部署时私有的,并且针对数学、编码和逻辑问题解决等任务进行了优化。以下是它具有突破性的原因:

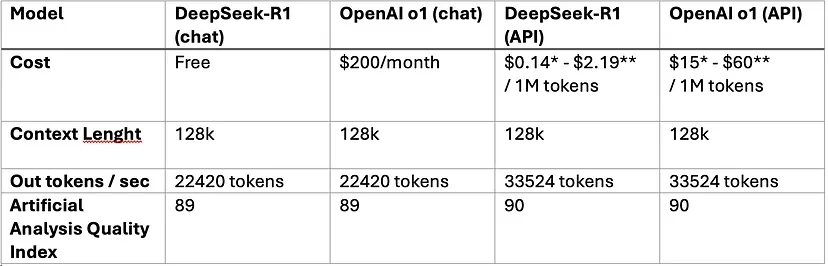

*输入令牌;**输出令牌

强化学习 (RL) 优于监督微调:

- 与 OpenAI 对标记数据集的依赖不同,DeepSeek-R1 使用纯 RL 来开发推理技能。它通过反复试验进行学习,无需分步指导即可生成问题的解决方案。

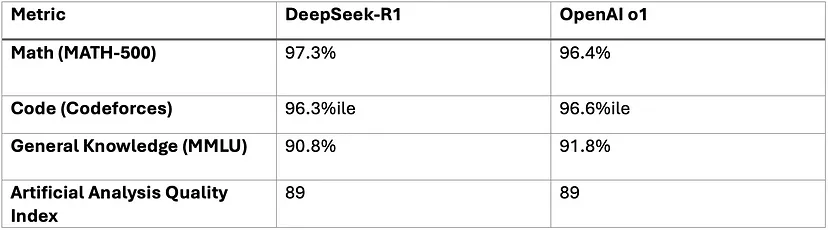

- 这种方法使其在 AIME 2024(数学基准)上获得了 79.8% 的 pass@1 分数,略优于 OpenAI-o1。RL 过程还支持自我验证和长链推理——这是完成复杂任务的关键。

成本效率:

- API 成本:DeepSeek 的 API 比 OpenAI-o1 便宜 96.4%(每百万输入令牌 0.55 美元 vs. 15 美元)。

- 本地部署:在消费硬件上运行精简版本(15 亿-700 亿参数),完全避免云费用。

开源灵活性:

- 无限制地对 DeepSeek-R1 进行微调或将其集成到您的项目中。它的 6 个精简模型(基于 Llama 和 Qwen 架构)可满足各种需求,从轻量级应用程序(15 亿)到高性能任务(6710 亿)。

DeepSeek-R1 在推理密集型任务方面表现出色,而 OpenAI-o1 在常识方面则占有优势。对于专注于数学、编码或成本效率的开发人员来说,DeepSeek 是更好的选择。

2、DeepSeek-R1本地安装指南

这是隐私优先方法,使用 Ollama 作为本地运行 DeepSeek-R1 的主干。以下是如何设置 Ollama、DeepSeek-R1(在不同的提炼模型中)和 Open Web UI 进行可视化。

首先使用终端(macOS/Linux)安装 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

ollama -v #check Ollama version然后通过 Ollama 下载 DeepSeek-R1。选择适合你机器的提炼模型。 deepseek-r1:671b 具有完整的 R1 功能。

# Default 7B model (4.7GB - ideal for consumer GPUs)

ollama run deepseek-r1

# Larger 70B model (requires 24GB+ VRAM)

ollama run deepseek-r1:70b

# Actual DeepSeek-R1 (requires 336GB+ VRAM for 4-bit quantization)

ollama run deepseek-r1:671b设置 Open Web UI(私有接口)。确保你的机器上安装了 docker,然后通过在终端上运行来安装 Open Web UI:

docker run -d -p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main访问 http://localhost:3000 并选择 deepseek-r1:latest。所有数据都保留在你的机器上 - 没有云跟踪或数据泄露。

3、DeepSeek-R1本地测试

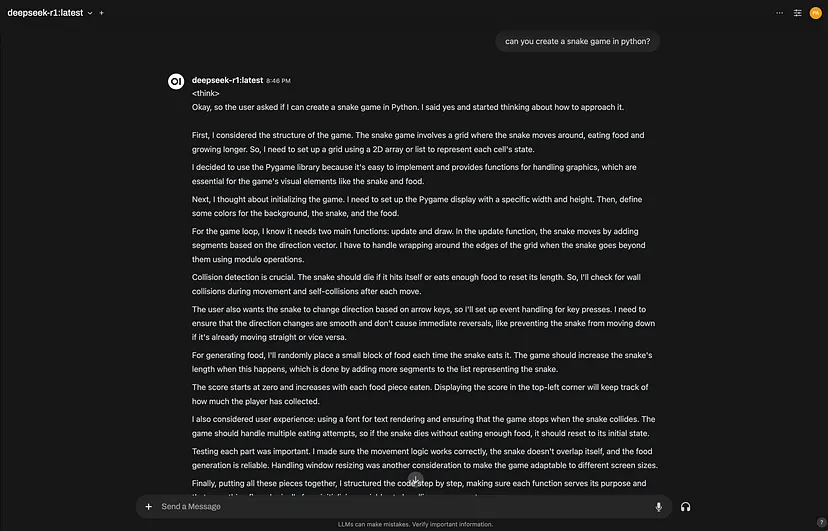

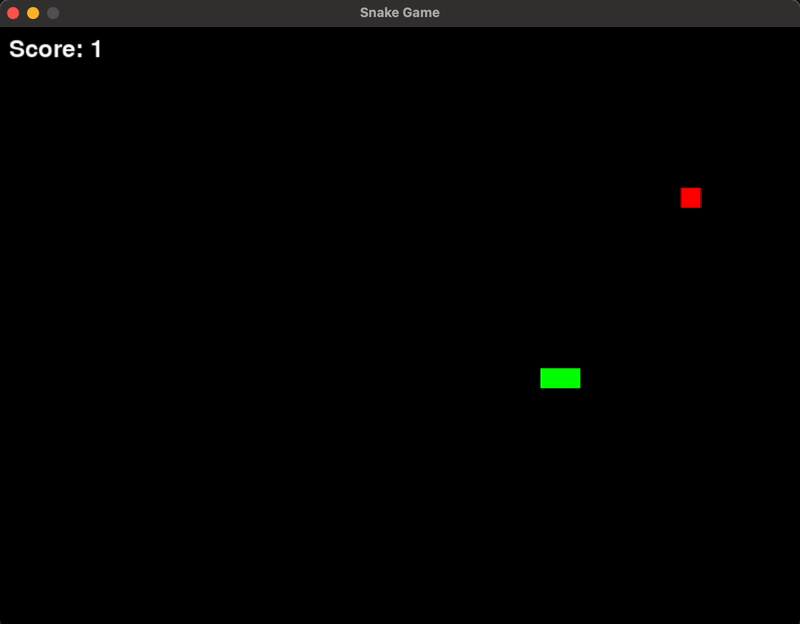

让我们尝试让模型创建一个贪吃蛇游戏。如下图所示,模型执行了所有思路以获得最佳响应。确实,它所花费的时间不是很好,但至少我们得到了模型更高效的响应。

它做得很不错,但花了将近 3 分钟!

4、将 DeepSeek-R1 集成到你的项目中

有两种集成方法。第一种是使用 DeepSeek-R1 本地部署(如上一节所示),第二种是使用 DeepSeek 服务器的云 API(可用于生产)。

4.1 本地部署(隐私优先)

使用你的 Ollama 实例作为 OpenAI 兼容端点:

import openai

# Connect to your local Ollama instance

client = openai.Client(

base_url="http://localhost:11434/v1",

api_key="ollama" # Authentication-free private access

)

response = client.chat.completions.create(

model="deepseek-r1:XXb", # change the "XX" by the distilled model you choose

messages=[{"role": "user", "content": "Explain blockchain security"}],

temperature=0.7 # Controls creativity vs precision

)4.2 使用官方 DeepSeek-R1 云 API

对于可扩展的应用程序,请使用 DeepSeek 的官方 API,你可以在此处通过创建帐户并生成一个密钥来获取 DeepSeek API 密钥:

import openai

from dotenv import load_dotenv

import os

load_dotenv()

client = openai.OpenAI(

base_url="https://api.deepseek.com/v1",

api_key=os.getenv("DEEPSEEK_API_KEY")

)

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "Write web scraping code with error handling"}],

max_tokens=1000 # Limit costs for long responses

)5、结束语

DeepSeek-R1 为昂贵的 AI 解决方案(如 OpenAI-o1)提供了强大的、隐私优先的替代方案。如果你正在开发复杂的应用程序,这个免费的开源模型可以为你节省资金并保护你的数据。

原文链接:How to Install and Use DeepSeek-R1: A Free and Privacy-First Alternative to OpenAI (Save $200/Month)

汇智网翻译整理,转载请标明出处