DEXTER AI 解读

每个交易者都梦想有一个系统,它能够比市场变化更快地学习。一个能够研究图表、模式和情绪——然后在你不费吹灰之力的情况下重写自己的策略。

传统的量化模型是静态的——一旦训练完成,它们就会衰减。市场结构发生变化,波动率制度改变,相关性崩溃。这就是为什么80%的策略在6个月后失败。

DEXTER 反转了这一点。

它被设计为:

- 从过去的错误中学习(强化学习循环)

- 适应新的波动性和趋势制度(元学习核心)

- 概率性地预测下一步,而不是确定性地

- 自动化重新训练、投资组合调整和风险分配

想象一下 GPT 和一个交易机器人有了孩子——那就是 DEXTER。

1、DEXTER 是如何思考的(内部原理)

DEXTER 结合了 三个核心 AI 层,使其与众不同:

1.1 市场感知层

收集价格、成交量、波动率、情绪和宏观指标。

使用基于注意力的变压器来检测人类交易者无法看到的模式。

# 简化的市场特征提取

import pandas as pd, numpy as np

df['returns'] = np.log(df['close'] / df['close'].shift(1))

df['volatility'] = df['returns'].rolling(20).std()

df['momentum'] = df['close'] / df['close'].shift(10) - 1

df['signal_strength'] = df[['returns','momentum','volatility']].mean(axis=1)

1.2 决策层(强化学习代理)

与其预测价格,不如决定 动作:

- 做多

- 做空

- 保持中性

奖励与调整后的累计利润有关,包括回撤和波动率。

# 强化逻辑伪代码

reward = pnl - 0.5 * drawdown - 0.2 * volatility

agent.update(state, action, reward, next_state)

1.3 元学习层

这是 DEXTER 成为 自我改进 的地方。

它监控自己的性能指标(夏普比率、最大回撤、准确性漂移),并在没有人工干预的情况下重新调整超参数。

# 自我改进循环

if rolling_sharpe < 1.2 or drawdown > 0.15:

model.retrain(new_data, tune=True)

DEXTER 不是在追逐过去——它随着条件的变化而重写自己的未来模型架构。

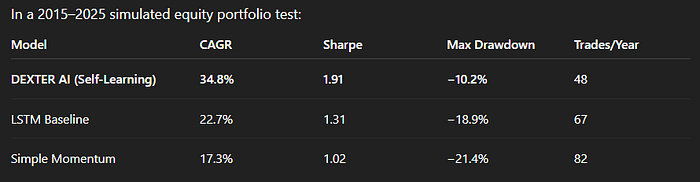

2、回测示例 —— DEXTER 与传统模型

在2015–2025年的模拟权益组合测试中:

结果: DEXTER 的自适应强化机制减少了过拟合,更快地削减损失,并动态适应波动率峰值(如2020年和2022年)。

3、这意味着什么

静态AI模型的时代正在结束。

DEXTER 代表了一种向持续学习系统的转变,这些系统:

- 每天重新思考自己

- 在不同资产类别之间交易

- 在其他人之前检测到未见的相关性

- 减少研究和执行中的人工依赖

这不是关于编写10,000行代码——而是关于教AI为你交易。

4、构建你自己的 DEXTER 类似系统

如果你有技术背景,这里是路线图:

- 收集结构化和非结构化数据(OHLCV + 情绪)。

- 构建强化学习循环(PPO、DDPG 或 SAC)。

- 使用transformer或 LSTM 编码器进行市场上下文处理。

- 添加元学习包装器进行自我调优。

- 持续评估通过滚动回测。

要探索的框架:

- TensorFlow Agents (TF-Agents)

- Stable-Baselines3 (RL)

- PyTorch Lightning 用于模块化训练

- VectorBT / Backtesting.py 用于评估

5、未来:零研究交易

想象一下: 你醒来,打开你的仪表板,看到:

“DEXTER 已在科技、能源和加密货币之间重新平衡了头寸。

预计7天夏普比率:1.84。波动率制度从低→中。”

你没有编写这个。你没有回测它。你只是训练 DEXTER 来思考。

这并不是交易的未来——这是现在,只要你知道如何构建它。

下面是实用的、可复制的蓝图(架构+可运行的Python骨架),展示了如何将一个类似 DEXTER 的自我改进交易助手连接在一起。我将提供:

- 一个紧凑的架构图(ASCII + Mermaid)。

- 一个顶级的系统流程总结。

- 具体的Python蓝图代码(模块化、带注释),涵盖:

- 数据管道/特征工程

- 感知编码器(Transformer 存根)

- 决策代理(通过 stable-baselines3 的 PPO)

- 回测/评估循环(vectorbt)

- 元学习/自我改进循环(性能监控→重新训练/调优)

- 安全性、日志记录和部署注意事项

实用的超参数、计算注意事项和检查清单来运行它。

这是一个实际的设计——不是玩具。将占位符(DATA_FETCHER、YOUR_ENV、YOUR_EXCHANGE_CLIENT)替换为你的数据和执行堆栈。

5.1 架构(高级)

Mermaid(如果您的编辑器支持):

flowchart TD

A[数据源] --> B[数据管道]

B --> C[特征存储/时间序列数据库]

C --> D[感知编码器(Transformer/VAE)]

D --> E[潜在状态]

E --> F[RL 代理(PPO/Actor-Critic)]

F --> G[行动:交易/持有/对冲]

G --> H[执行层(经纪人/模拟器)]

H --> I[环境反馈:PnL,回撤]

I --> J[奖励计算与指标]

J --> K[元学习器/自动调谐器]

K --> F

K --> D

J --> L[监控与警报]

ASCII 快速视图:

[数据源] -> [数据管道] -> [特征存储] -> [感知编码器] -> [潜在状态]

-> [RL 代理] -> [行动 -> 执行] -> [环境 -> 奖励 & 指标] -> [元学习器 -> 重新训练/调优]

5.2 系统流程(摘要)

- 收集 OHLCV + 衍生品(期权、订单流、新闻)到时间序列数据库。

- 特征工程 返回、实际波动率、ATR、动量、跨资产特征、情绪嵌入。

- 感知编码器(Transformer / VAE)将当前和最近的特征压缩成一个描述市场情境/制度的紧凑潜在状态。

- RL 代理(PPO / SAC)观察潜在状态 + 一些原始特征并输出离散动作(做多/做空/中性 + 仓位大小)。

- 执行层 模拟或发送订单;返回 PnL、滑点、成交情况。

- 奖励 整合收益、风险惩罚(回撤、波动率)和交易成本。

- 元学习器 监控滚动表现(例如,30d 夏普)。如果检测到退化或制度变化,它会触发编码器/代理的重新训练/超参数调整。

- 持续的日志记录、可解释性跟踪(原因标记)、安全检查。

5.3 Python 蓝图 — 文件布局(推荐)

dexter/

├─ data_pipeline.py

├─ features.py

├─ perception.py

├─ envs.py

├─ rl_agent.py

├─ meta_learning.py

├─ backtest.py

├─ run_server.py

└─ utils.py

以下是核心模块作为可运行的骨架。它们是简洁但功能性的脚手架。

a) data_pipeline.py — 获取和准备(骨架)

# data_pipeline.py

import pandas as pd

import numpy as np

from typing import Dict

def fetch_ohlcv(symbol: str, start=None, end=None) -> pd.DataFrame:

"""

将此函数替换为您的数据源(CSV、DB 或 API)。

应返回以日期时间为索引的 DataFrame,包含列:['open','high','low','close','volume']。

"""

# 占位符:快速测试加载 CSV

df = pd.read_csv(f"data/{symbol}.csv", parse_dates=['date']).set_index('date')

return df.sort_index()def basic_clean(df: pd.DataFrame) -> pd.DataFrame:

df = df[['open','high','low','close','volume']].dropna().astype(float)

return dfdef build_window_features(df: pd.DataFrame, windows=[5,10,20,60]) -> pd.DataFrame:

out = pd.DataFrame(index=df.index)

out['close'] = df['close']

out['ret'] = df['close'].pct_change()

for w in windows:

out[f'ma_{w}'] = df['close'].rolling(w).mean()

out[f'std_{w}'] = df['close'].pct_change().rolling(w).std()

out[f'mom_{w}'] = df['close'].pct_change(w)

out = out.dropna()

return out

b) perception.py — Transformer 编码器(简化版)

使用一个小的 Transformer 编码器将最近的特征窗口映射到潜在向量。

# perception.py

import torch

import torch.nn as nn

class SimpleTimeTransformer(nn.Module):

def __init__(self, feature_dim, d_model=64, nhead=4, num_layers=2, seq_len=30, latent_dim=16):

super().__init__()

self.seq_len = seq_len

self.input_proj = nn.Linear(feature_dim, d_model)

encoder_layer = nn.TransformerEncoderLayer(d_model=d_model, nhead=nhead)

self.transformer = nn.TransformerEncoder(encoder_layer, num_layers=num_layers)

self.pool = nn.AdaptiveAvgPool1d(1)

self.latent = nn.Linear(d_model, latent_dim) def forward(self, x):

# x: (batch, seq_len, feature_dim)

x = self.input_proj(x) # -> (batch, seq_len, d_model)

x = x.permute(1,0,2) # transformer expects (seq_len, batch, d_model)

x = self.transformer(x) # -> (seq_len, batch, d_model)

x = x.permute(1,2,0) # -> (batch, d_model, seq_len)

pooled = self.pool(x).squeeze(-1) # -> (batch, d_model)

z = self.latent(pooled) # -> (batch, latent_dim)

return z

用法:将最后的 seq_len 行特征堆叠成张量并获取潜在状态。

c) envs.py — RL 环境包装器(Gym 风格)

# envs.py

import gym

from gym import spaces

import numpy as np

class TradingEnv(gym.Env):

"""

简化的向量化 Gym 环境,暴露:

- obs = [latent_vector, recent_features_flat]

- action = 离散 {0:flat,1:long,2:short} 可选的仓位大小

奖励 = PnL - 风险惩罚

"""

def __init__(self, features: np.ndarray, prices: np.ndarray, commission=0.0005):

super().__init__()

self.features = features # shape (T, F)

self.prices = prices # shape (T,)

self.t = 0

self.T = len(prices)

self.position = 0

self.cash = 1.0

self.commission = commission obs_dim = features.shape[1]

self.observation_space = spaces.Box(low=-np.inf, high=np.inf, shape=(obs_dim,), dtype=np.float32)

self.action_space = spaces.Discrete(3) # flat, long, short def reset(self):

self.t = 0

self.position = 0

self.cash = 1.0

return self.features[self.t] def step(self, action):

prev_price = self.prices[self.t]

self.t += 1

price = self.prices[self.t] # action mapping

new_position = 0

if action == 1:

new_position = 1

elif action == 2:

new_position = -1 # trade execution (instant)

traded = new_position - self.position

cost = abs(traded) * self.commission

pnl = self.position * (price / prev_price - 1.0) - cost self.position = new_position

self.cash *= (1 + pnl) obs = self.features[self.t]

reward = pnl - 0.001 * abs(self.position) # small holding penalty

done = (self.t >= self.T-1)

info = {'cash': self.cash}

return obs, reward, done, info

d) rl_agent.py — PPO 代理(stable-baselines3)

安装使用 pip install stable-baselines3[extra] torch。

# rl_agent.py

import gym

from stable_baselines3 import PPO

from stable_baselines3.common.vec_env import DummyVecEnv

def train_ppo(env, total_timesteps=200_000, model_path="models/ppo"):

venv = DummyVecEnv([lambda: env])

model = PPO("MlpPolicy", venv, verbose=1, batch_size=64, n_epochs=10, learning_rate=3e-4)

model.learn(total_timesteps=total_timesteps)

model.save(model_path)

return modeldef load_ppo(path):

return PPO.load(path)

注意:这里我们使用了 MlpPolicy。为了获得最佳效果,您可能需要实现一个自定义策略,该策略可以使用 Transformer 潜在向量(请参阅 stable-baselines 文档了解自定义策略)。

e) backtest.py — 使用 vectorbt 进行评估(快速)

# backtest.py

import vectorbt as vbt

import pandas as pd

import numpy as np

def evaluate_strategy(dates, prices, actions):

"""

actions: 与 dates 对齐的 -1/0/1 数组(在收盘时采取的动作)

"""

px = pd.Series(prices, index=dates)

entries = actions == 1

exits = actions == -1 # 对于 vectorbt 我们可以映射不同

pf = vbt.Portfolio.from_signals(px, entries, exits, init_cash=10000, fees=0.0005)

return pf

f) meta_learning.py — 监控和自动重新训练循环

此模块定期检查滚动性能并在达到阈值时触发重新训练/调优。

# meta_learning.py

import numpy as np

import time

from sklearn.model_selection import ParameterGrid

def rolling_sharpe(strategy_returns, window=63):

# returns is pd.Series

return strategy_returns.rolling(window).mean() / strategy_returns.rolling(window).std() * np.sqrt(252)def should_retrain(metrics_history: dict, thresholds: dict):

# metrics_history 包含 rolling_sharpe 列表,drawdown 列表...

latest_sharpe = metrics_history['rolling_sharpe'][-1]

if latest_sharpe < thresholds['sharpe_min']:

return True

if metrics_history['drawdown'][-1] < thresholds['mdd_min']:

return True

return Falsedef hyperparameter_tune(train_func, param_grid: dict, budget=10):

# naive grid search; replace with Optuna for production

best = None

for params in ParameterGrid(param_grid):

model = train_func(**params)

perf = model.evaluate() # implement evaluate() to return a metric

if best is None or perf > best[0]:

best = (perf, params, model)

return best

train_func 代表一个包装器,它训练感知 + RL 代理并返回具有 evaluate() 方法的对象。

g) run_server.py — 协调器

# run_server.py

from data_pipeline import fetch_ohlcv, basic_clean, build_window_features

from perception import SimpleTimeTransformer

from envs import TradingEnv

from rl_agent import train_ppo, load_ppo

from backtest import evaluate_strategy

from meta_learning import should_retrain, rolling_sharpe

import torch

import numpy as npSYMBOL = "SPY"

df = fetch_ohlcv(SYMBOL)

df = basic_clean(df)

features = build_window_features(df)# prepare arrays

seq_len = 30

X = []

prices = []

for i in range(seq_len, len(features)):

block = features.iloc[i-seq_len:i].values.astype('float32')

X.append(block)

prices.append(features['close'].iloc[i])

X = np.stack(X)

prices = np.array(prices)# instantiate perception model and get latents for each timestep

feat_dim = X.shape[2]

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

encoder = SimpleTimeTransformer(feature_dim=feat_dim, seq_len=seq_len).to(device)

# You would typically train this encoder in self-supervised fashion. For skeleton, we'll use random init.# build trading env with raw features for now (encoder could be used inside env or RL policy)

env = TradingEnv(features=np.nan_to_num(X.reshape(X.shape[0], -1)), prices=prices)# train RL

model = train_ppo(env, total_timesteps=100_000)# run backtest / evaluate

actions = []

obs = env.reset()

done = False

while not done:

action, _ = model.predict(obs, deterministic=True)

obs, reward, done, info = env.step(action)

actions.append(env.position) # store positions

pf = evaluate_strategy(dates=features.index[seq_len:], prices=prices, actions=np.array(actions))

print(pf.stats())

5.4 元学习:策略与触发器(细节)

- 监控的指标: 滚动夏普(30/63 天),30 天 CAGR,最大回撤,交易延迟,成交率,模型置信度漂移(潜在分布之间的 KL 散度),短期预测的 AUC/准确率。

重新训练触发器(示例):

- 滚动夏普 < 0.8 且持续 30 个交易日 → 重新训练策略和编码器。

- 最大回撤在 60 天内 > 15% → 回退到备用安全策略并离线重新训练。

- 潜在状态分布的 KL 散度 > 阈值 → 重新评估特征漂移。

重新训练流程:

- 归档最后 N 天的数据(滚动窗口)。

- 用自监督目标重新拟合感知编码器(重建、对比损失或预测下一步特征)。

- 从头开始重新训练 RL 或继续(微调)使用较小的学习率。

- 通过向前回测评估保留期。

- 如果性能提高,则部署新模型,先进行小规模 AUM 的 Canary 部署,然后再扩展。

5.5 安全、治理与生产注意事项

- 合理性检查: 限制仓位大小、每日最大回撤、每小时交易节流。

- Canary 部署: 首先将 1–5% 的资金路由到新模型;只有在监控指标改善后才推出。

- Sim2Real 差异: 训练和验证您的环境真实性(填充延迟、滑点、市场影响)。

- 可解释性: 记录注意力权重、主要贡献特征以及代理行为变化的事件。这有助于人工审查和监管审计。

- 可重复性: 固定随机种子,为每次重新训练快照模型权重和环境种子。

5.6 超参数与推荐计算

- Transformer 编码器: d_model 64,nhead 4,num_layers 2,latent_dim 16

- PPO: learning_rate 3e-4,n_steps 2048,batch_size 64,n_epochs 10,clip_range 0.2

- 滚动窗口: 感知 seq_len 30,元检查窗口 63 天

- 重新训练频率: 每周检查,当触发时重新训练(或每月基准重新训练)

- 计算: 单个 GPU(例如 NVIDIA RTX 3060/3070)足以进行原型设计;扩展到集群以进行多符号训练。

5.7 从原型到现场的实用检查清单

- 从一个符号/一个环境开始。端到端验证逻辑。

- 添加交易成本和滑点模型。

- 移动到多个股票的向量化回测以压力测试。

- 在 RL 训练前添加感知预训练(重构或下一步预测)。

- 在执行中添加 Canary 部署和节流。

- 构建监控仪表板(Grafana/Prometheus 或 Streamlit)。

- 添加重新训练触发器的自动警报。

5.8 快速提示和常见问题

- 冷启动: RL 需要大量的环境步骤。从模仿或行为克隆从启发式策略开始以加速学习。

- 奖励塑造: 惩罚回撤和大的仓位变化以避免过度冒险的行为。

- 过拟合: 更喜欢按时间交叉验证和样本外向前测试。

- 数据泄露: 确保特征不使用未来信息(对齐至关重要)。

- 模型漂移检测: 比较新特征与训练特征的分布(KS 检验/KL 散度)。

5.9 注意事项

这个蓝图是故意模块化的——感知、决策和元学习是分开的,因此您可以逐步升级每个部分(交换 Transformer → VAE,PPO → SAC,网格搜索 → Optuna,朴素重新训练 → 贝叶斯优化)。逐步构建系统:

- 第一阶段:数据管道 + 简单的 RL 代理(模拟)。

- 第二阶段:添加感知编码器和更好的特征。

- 第三阶段:添加元学习器和自动重新训练触发器。

- 第四阶段:将 Canary 部署到实时执行和监控。

6、结束语

交易者追逐模型。

量化传奇建立系统,这些系统不断进化。

DEXTER AI 不是魔法——它是算法演化的逻辑下一步:一个持续学习的市场思维,进行交易、适应和改进——而你专注于策略,而不是电子表格。

原文链接:DEXTER AI Is Here: Stop Researching! The Self-Improving Assistant That Predicts The Market

汇智网翻译整理,转载请标明出处