Gemini 2.0 Flash vs. DeepSeek R1

当我第一次看到 Google Gemini 的价格时,我打算将它与精简版、性能较弱的 R1 型号进行对比。我完全不相信即如此便宜的模型会如此强大。

三周前,当 DeepSeek 发布他们的廉价推理模型 R1 时,我认为这是人工智能革命的巅峰。我从未如此印象深刻。

然而,OpenAI 和 Google 都以前所未有的速度做出了回应。

OpenAI 以 o3-mini 做出了回应,这是一个非常强大且价格低廉的大型推理模型。与 o1 和 R1 一样,o3-mini 需要花费时间“思考”才能生成最终响应,这个过程显著提高了最终输出的准确性,但代价是延迟更高。

然而,Google 的回应方式完全不同。他们只是制作了一个更好的模型,消灭了 OpenAI 和 DeepSeek 最强大的推理模型。

我印象深刻。

1、DeepSeek R1 的隐藏问题

当 DeepSeek R1 首次发布时,我太高兴了,以至于没有注意到它的缺陷。

但是,随着我的玫瑰色眼镜失去光泽,我开始注意到其中的很多问题。

其中之一是,对于现代大型语言模型而言,该模型的上下文窗口非常低。

在 GPT-3 时代,128,000 个 token 可能已经很不错了,但对于实际的现实用例来说,这根本不够。

事实上,我不得不执行转换来减少我的提示上下文窗口并执行一些最复杂的提示,例如财务分析提示。这绝对降低了性能。

相比之下,谷歌的 Gemini Flash 2.0 模型比 R1 便宜得多,上下文窗口为 100 万个输入 token!

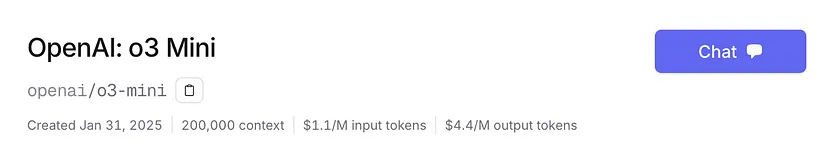

同样,o3-mini 比 DeepSeek R1 略贵,上下文窗口为 200,000 个输入 token。

然而,考虑到我的应用程序是在低上下文窗口时代创建的,这是一件小事。我已经实现了提示链来拆分我的大部分大型复杂提示。

DeepSeek R1 的主要、不可原谅的问题是它实在太慢了。

使用两个价格合理的提供商中的任何一个都完全无法使用。提示组合需要几分钟才能完成,这是不可接受的。

相比之下,Google Gemini 只需几秒钟,而且它的价格出奇地非常准确。

虽然我已经确定 O3-mini 比 DeepSeek R1 更好,但我想知道……Gemini Flash,一个便宜得多的型号,相比之下如何?

2、SQL 查询生成:Flash 2.0 vs. R1 vs. o3-mini

为了比较这些模型,我将运行一系列半随机财务分析问题。我的目标是看看 Flash 2.0 在复杂推理任务中与 DeepSeek R1 和 GPT o3-mini 相比如何。

具体来说,我们将测试它们生成 SQL 查询的能力。这个测试很重要,因为它相当复杂,需要模型仔细遵循系统提示的约束,最终的准确性对最终用户非常重要。

我们要测试的查询类型必须处理财务分析。这是因为我的交易平台 NexusTrade 有一个自然语言界面,允许投资者使用人工智能查询股票。

因此,弄清楚哪种模型更好是至关重要的。为了测试这一点,我们将根据以下因素测试这三个模型:

- 准确度

- 成本

- 相对速度和其他考虑因素

让我们从准确度测试开始。

2.1 准确度测试 1:相关性查询

在第一个测试中,我将向这三个模型询问以下问题:

What is the correlation of returns for the past year between reddit stock and SPY?翻译:reddit 股票和 SPY 过去一年的回报相关性是多少?

以下是响应。

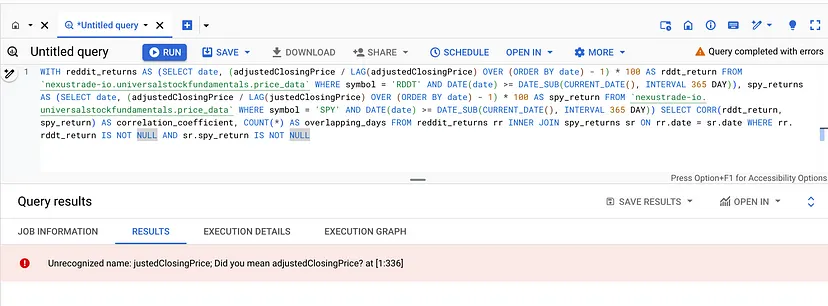

- Gemini Flash 2.0 的响应

令我惊讶的是,Google Gemini 仅在几秒钟内就做出了响应。

从模型执行查询时,我得到了以下结果:

这是 100% 准确的。Gemini 的得分为 1/1。

- DeepSeek R1 的响应

与 Google Gemini 相比,DeepSeek R1 的速度非常慢。它花了 30 多秒才生成响应,这主要是因为它的“推理”组件。

然后,在等待了这么长时间之后,它在生成响应时犯了一个愚蠢的错误。

它将“adjustedClosingPrice”拼写错误为“justedClosingPrice”。当我们手动修复这个拼写错误时,我们得到的响应与 Google Gemini 相同,尽管它包含的信息比我们要求的还要多。

这是准确的,但我们必须手动重试逻辑。因此,我给它的分数是 0.7/1。

- OpenAI o3-mini 的响应

最后,让我们测试一下 o3-mini 的响应。O3-mini 比 R1 快得多,但由于其“推理”组件,速度仍然有点慢。几秒钟后,我们得到了这个响应。

O3-mini 不知道 Reddit 的股票代码!它猜测是 REDDIT,这是不正确的,这给了我们一个零相关性。当我们手动修复它时,我们得到了正确的响应。

与我们给 R1 评分的方式类似,O3-mini 被扣分,因为我们必须修复查询。最终得分:0.7/1。

因此,在这次测试中,Google Gemini 的表现实际上比这两个模型都好一点!但是,这只是一次测试。让我们看看模型在生成不同类型的 SQL 查询时的表现。

2.2 准确度测试 2:收入增长查询

在这次测试中,我们将提出以下问题:

What biotech stocks have increased their revenue every quarter for the past 4 quarters?翻译:过去 4 个季度中,哪些生物科技股的收入每个季度都在增加?

以下是回复:

- Gemini Flash 2.0 的回复

Google Flash 再次在几秒钟内做出了响应。从对查询的手动检查来看,它看起来是正确的。但是,为了再检查一下,我要求 GPT-o3-mini-high 对最终答案进行评分。它证实了我的怀疑。

该模型有些挑剔,但总体而言,它表现完美。谷歌又得了 1/1 分!

- DeepSeek R1 的响应

相比之下,DeepSeek R1 实际上表现不佳。查询看起来根本不正确,当我尝试执行它时,它失败了。

更不用说,模型花了很长时间才做出响应……再次。

总的来说,这一轮表现糟糕。0/1。

- OpenAI o3-mini 响应

就像在上次测试中一样,o3-mini 花了适度的时间来返回其响应,但它比 R1 快得多。这是最终的回应。

查询略有不同,并检索了不同的股票列表。但是,它看起来仍然大致准确。我用同样的方式给它评分。

同样,该模型有挑剔之处,而 o3-mini 模型的响应在技术上仍然是准确的。 OpenAI 本轮得分满分!

3、成本分析:哪种模型更便宜?

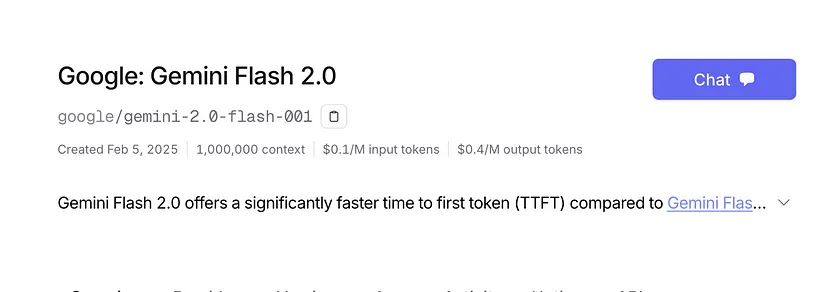

然而,准确度并不是唯一重要的事情。对于 LLM 应用程序来说,同样重要的是它们的成本。让我们来看看它们。

到目前为止,最便宜的模型是 Gemini Flash 2.0。每百万输入令牌的成本为 0.10 美元,每百万输出令牌的成本为 0.40 美元。

相比之下,R1 贵得多——大约贵了 7 倍。每百万输入令牌的成本为 0.75 美元,每百万输出令牌的成本为 2.4 美元。

最后,OpenAI o3-mini 模型是所有模型中最昂贵的。每百万个输入令牌的成本为 1.1 美元,每百万个输出令牌的成本为 4.4 美元,比 Gemini Flash 贵 11 倍,比 R1 贵 1.5 倍。

这太疯狂了!

4、其他考虑因素

正如我在整篇文章中提到的那样,Google Gemini 模型也比这两个模型中的任何一个都快得多。 Gemini 是一种传统的大型语言模型——它在提出答案之前不会花时间“思考”问题。 虽然这种思考通常会导致准确率的显着提高,但 Gemini 模型似乎不需要这样做就能取得良好的效果。

最后,Gemini 模型的上下文窗口比这两个模型都要高得多。 总结这些结果:

- Google Gemini 2.0 Flash:速度快如闪电,第一次尝试时两个 SQL 查询都 100% 正确

- DeepSeek R1:速度慢得令人难以忍受,两个 SQL 查询都错了。第一个有一个小错误,而第二个完全错误

- OpenAI o3-mini:速度较慢,但不是特别慢。由于不知道 Reddit 股票行情,它的第一个查询略有错误,而第二个查询 100% 正确。

从这些测试中,我们看到 Google Gemini Flash 2.0 是迄今为止最强大、最经济实惠的模型,优于更昂贵的推理模型。这是谷歌的彻底歼灭。

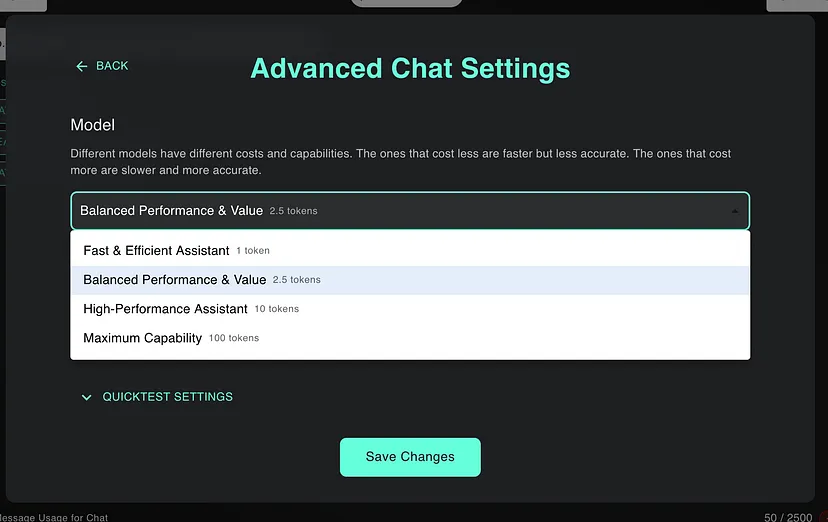

以至于我立即重构了我的交易平台 NexusTrade,完全删除了 DeepSeek R1,并将 Gemini 集成到 AI 聊天中。

现在,每个人都可以体验高度准确、廉价、易于执行的分析的力量。

感谢谷歌!

5、结束语

当我第一次看到 Google Gemini 的价格时,我打算将它与精简版、性能较弱的 R1 型号进行对比。我完全不相信即如此便宜的模型会如此强大。

我错了。它不仅非常强大,而且非常便宜。在我的(有限、受限的)测试中,它在各个方面都比最好的模型要好。

基于此分析,Google Gemini 模型:

- 比 OpenAI 的 o3-mini 便宜 10 倍,比 DeepSeek 的 R1 便宜 7 倍

- 快几个数量级

- 具有更高的上下文窗口

- 非常强大,在复杂 SQL 任务的子集中可以说比 O3-mini 更强大

该模型是我们正在转向更便宜、更强大的大型语言模型的不可否认的证据。它决定性地超越了竞争对手,证明了昂贵、资源密集型模型的时代已经结束。这一突破标志着行业的变革性转变,为在实际应用中更易于访问、高性能的 AI 解决方案铺平了道路。

原文链接:Google just ANNIHILATED DeepSeek and OpenAI with their new Flash 2.0 model

汇智网翻译整理,转载请标明出处