ComfyUI使用大模型生成提示

本文将把 ComfyUI 工作流连接到 Ollama,以便用大模型生成CLIP Text Encode节点的提示。

在我的上一篇文章中,我描述了如何使用 Ollama 在本地运行 Mistral(大型语言模型)。为了配合这篇文章,我创建了一个提示并手动使用 AI 生成图像。今天,我将把 ComfyUI 工作流连接到 Ollama,以便无缝地完成此操作,这要感谢 ComfyUI-IF_AI_tools。

1、安装

阅读文档。不要盲目遵循代码(就像我一样)。

假设你已安装 Ollama:拉取基于 LLaMA-7B 且大小约为 4.1GB 的 brxce/stable-diffusion-prompt-generator 模型,然后启动 Ollama 作为服务器来观察发生的事情:

ollama pull brxce/stable-diffusion-prompt-generator

ollama serve假设你已安装 ComfyUI Portable:按照 ComfyUI-IF_AI_tools 页面上的说明进行操作,我将其总结如下。最后一行中的批处理文件安装了先决条件,其中有很多我宁愿跳过,因为我只使用 Ollama(我不需要或不想要 OpenAI、Anthropic 等库)。无论如何:

cd ComfyUI\custom_nodes

git clone https://github.com/if-ai/ComfyUI-IF_AI_tools.git

cd ComfyUI-IF_AI_tools

embedded_install.bat现在我们可以使用在 Ollama 中本地运行的 LLM 来帮助直接从 ComfyUI 用户界面生成提示。但是,如果你愿意,IF_AI_tools 也可以在云端使用 LLM 服务。

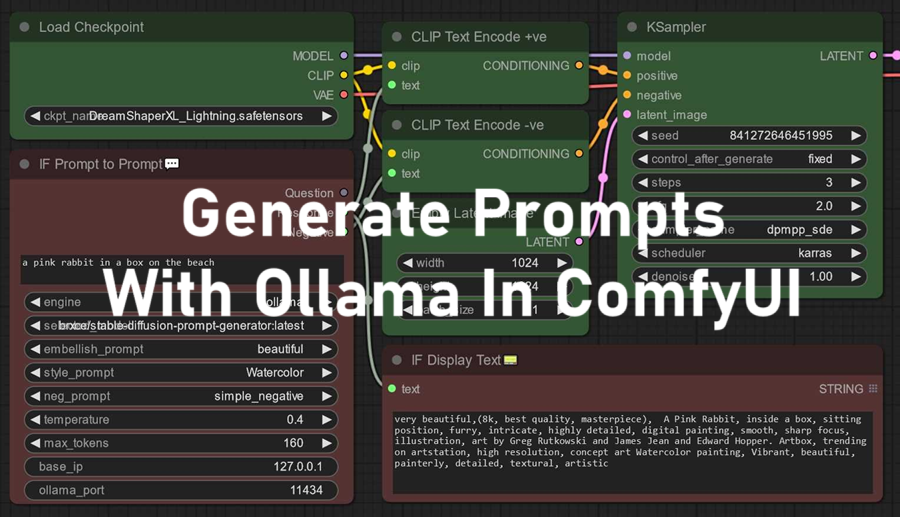

2、工作流程

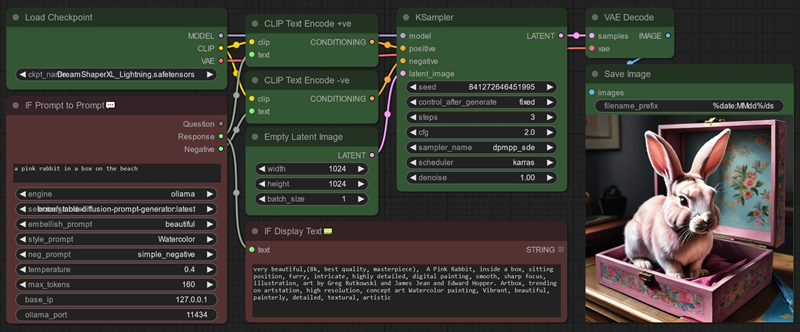

只是一个标准的 SDXL 类型工作流程(绿色节点),除了我们使用两个新的 IF_AI_tools 节点(红色)来“增强”原始输入提示:

- 使用 IF Prompt 到 Prompt

IF_PromptMkr节点将一个非常简单的提示传递给 Ollama 中的模型。 - 使用 IF Display Text

IF_DisplayText和(如果需要)IF_SaveText节点查看和保存修饰的输出提示。

有时我会得到一个真正不连贯且毫无意义的文字杂烩,与输入提示几乎没有关系。如果这种“创造力”水平合适,那么......太棒了!但通常,文字杂烩对生成的图像的影响远远大于实际所需的主题!

我调低了温度,以便生成的提示更接近输入 - 在上面的例子中,在默认值 0.7 下,“在盒子里”指令被直接跳过。即便如此,“在海滩上”又怎么样了?所以:温度越高,输出就越不稳定、越随机。

是的,我的 RAM 不足以将模型缓存在内存中,导致一切都非常缓慢。祝你好运。

原文链接:LLM Prompt Generation with Ollama in ComfyUI

汇智网翻译整理,转载请标明出处