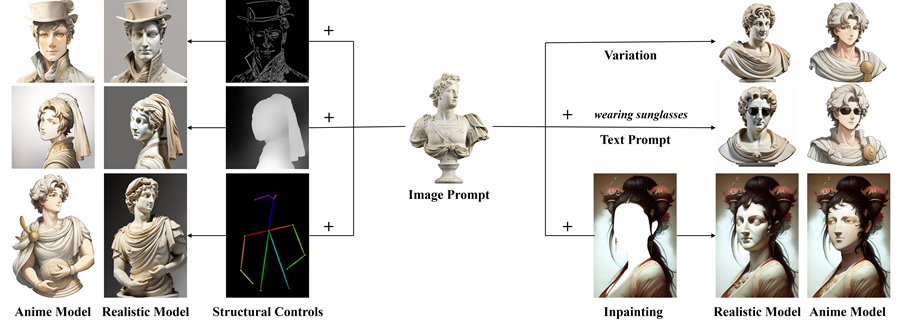

IP-Adapter图像提示模型

图像提示与文本提示一起作为稳定扩散模型的附加输入。文本和图像提示都作为条对 AI 图像生成产生影响。

利用稳定扩散 AI 中的图像提示(IP:Image Prompts)功能可以显著影响生成图像的结果。本指南揭示了在稳定扩散中有效利用图像提示的过程。

图像提示是影响输出图像构图、样式和配色方案的重要组件。

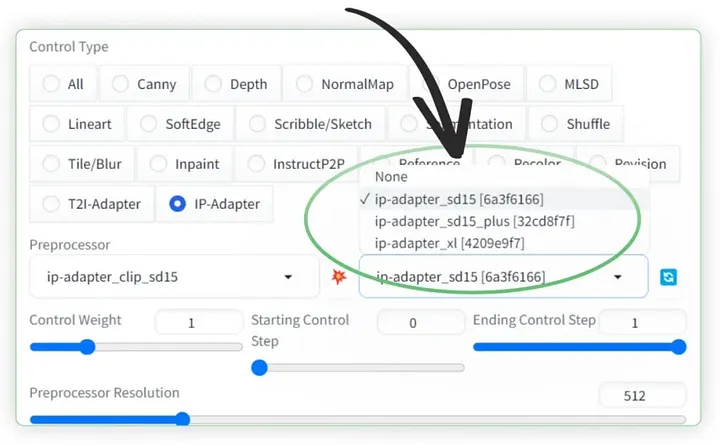

对于本教程,ControlNet 的使用至关重要。我们将使用以下 ControlNet 模型,这些模型已预安装在 ThinkDiffusion 上:

- ip-adapter_sd15.pth(适用于 1.5 模型)

- ip-adapter_sd15_plus(适用于 1.5 模型)

- ip-adapter_xl(适用于 SDXL 模型)

1、图像提示由什么组成?

图像提示与文本提示一起作为稳定扩散模型的附加输入。文本和图像提示都作为条件(conditioning)对 AI 图像生成产生影响。

图像提示适配器(IP-Adapter)类似于 ControlNet,它不会改变稳定扩散模型,但会对其进行调节。它与任何稳定扩散模型兼容,并且在 AUTOMATIC1111 中通过 ControlNet 扩展实现。

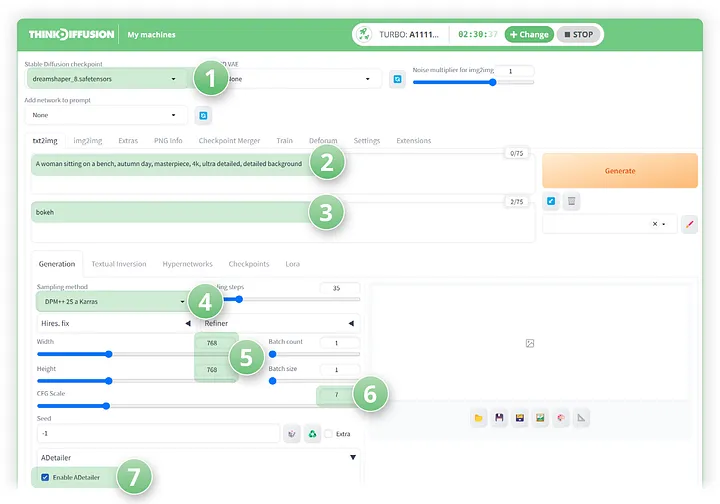

2、文本到图像过程

访问 AUTOMATIC1111 的 txt2img 页面上的图像提示功能。

让我们首先生成一个没有图像提示的图像,然后添加一个图像提示来观察其效果。

在 txt2img 选项卡中,设置以下参数:

- 模型:Dreamshaper_8

- 正提示:一位坐在长椅上的女人,秋日,杰作,4k,超详细,详细背景

- 负提示:散景

- 采样方法:DPM++ 2S a Karras

- 尺寸:768 x 768

- CFG 比例:7

- 单击启用 aDetailer 以改善面部

单击生成,我们得到的结果如下:

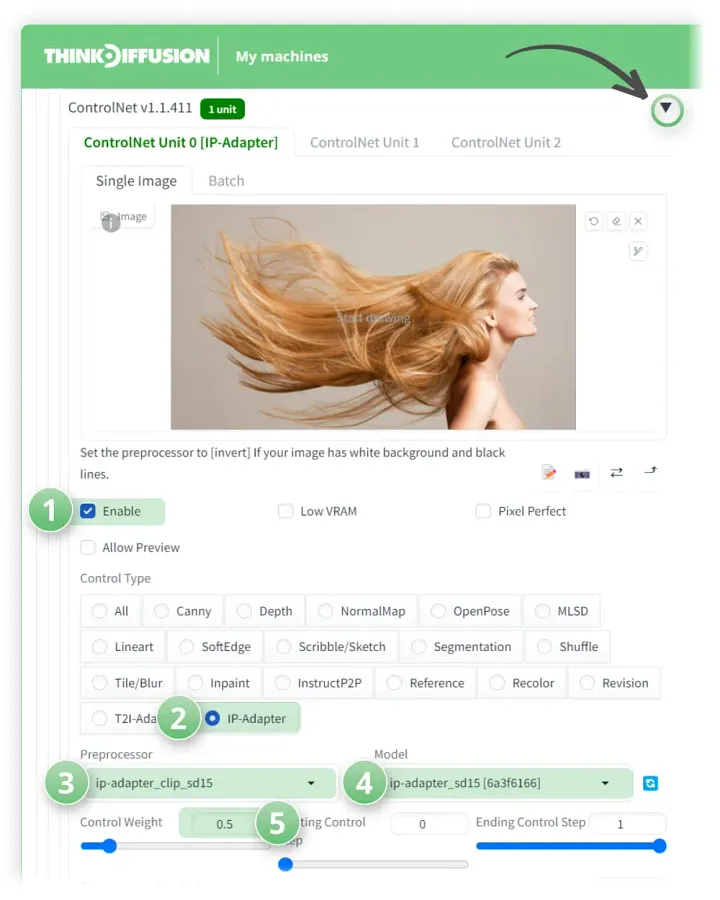

3、添加图像提示(使用 IP Adapter)

现在我们可以使用另一张图片来风格化我们的原始提示。

让我们保持上面的所有参数不变。但现在我们要将此图像添加到 ControlNet:

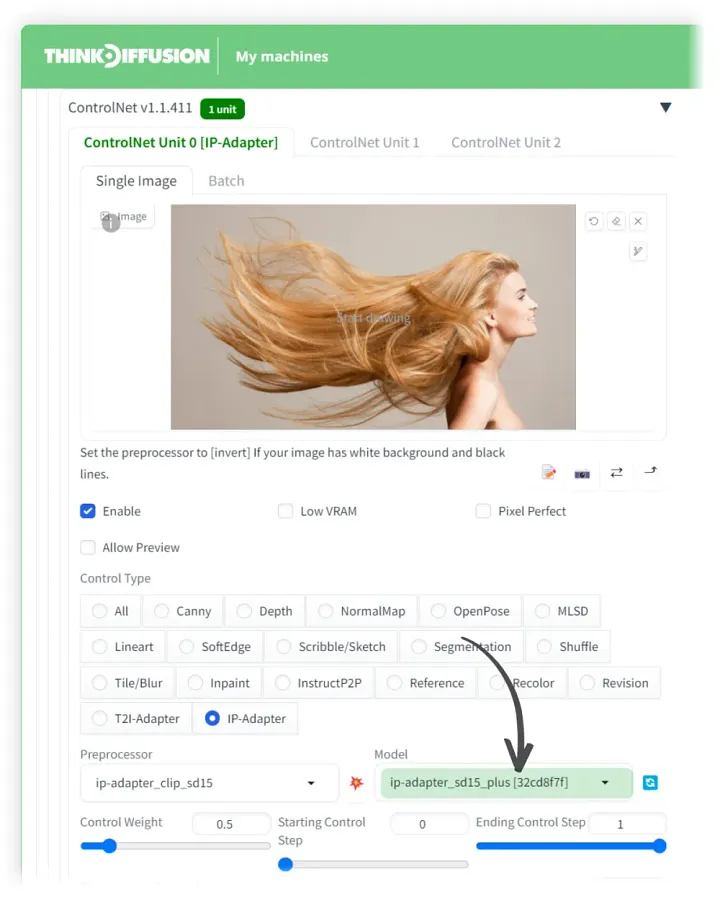

让我们打开 ControlNet 来设置我们的 ip 适配器设置。向下滚动到 controlNet 选项卡并单击下拉箭头。

- 单击✅启用

- 将控制类型设置为 IP 适配器

- 将预处理器设置为 ip-adapter_clip_sd15

- 将 ControlNet 模型设置为 ip-adapter_sd15

- 将控制权重设置为 0.5

点击生成,我们现在可以看到飘逸的头发已被拉入我们的图像中!

4、尝试 IP-Adapter Plus

我们现在将对 ip-adapter_sd15_plus 重复相同的操作,它本质上是相同的,但模型功能强大得多,因此请尝试使用控制权重来获得你想要的结果。

在 ControlNet 选项卡中,将下拉框中的模型更新为:ip-adapter_sd15_plus

点击生成,我们可以看到一些疯狂的头发!

5、将图像提示与 SDXL 模型结合使用

对于更高分辨率的生成,我们将使用 SDXL 模型和与 SDXL 模型兼容的 IP 模型: IP-adapter_xl。

什么是 SDXL 模型?

在 txt2img 选项卡中,设置以下参数:

- 模型:ThinkDiffusionXL

- 正提示:一张熊形床,杰作,4k,超精细

- 负提示:散景

- 采样方法:DPM++ 2S a Karras

- 尺寸:1024 x 1024

- CFG 比例:7

点击生成,你会看到它将熊放在床上,这不是我们想要的!

为了纠正这个问题,让我们保持所有设置不变,但添加 ControlNet 模型 IP-adapter_xl。

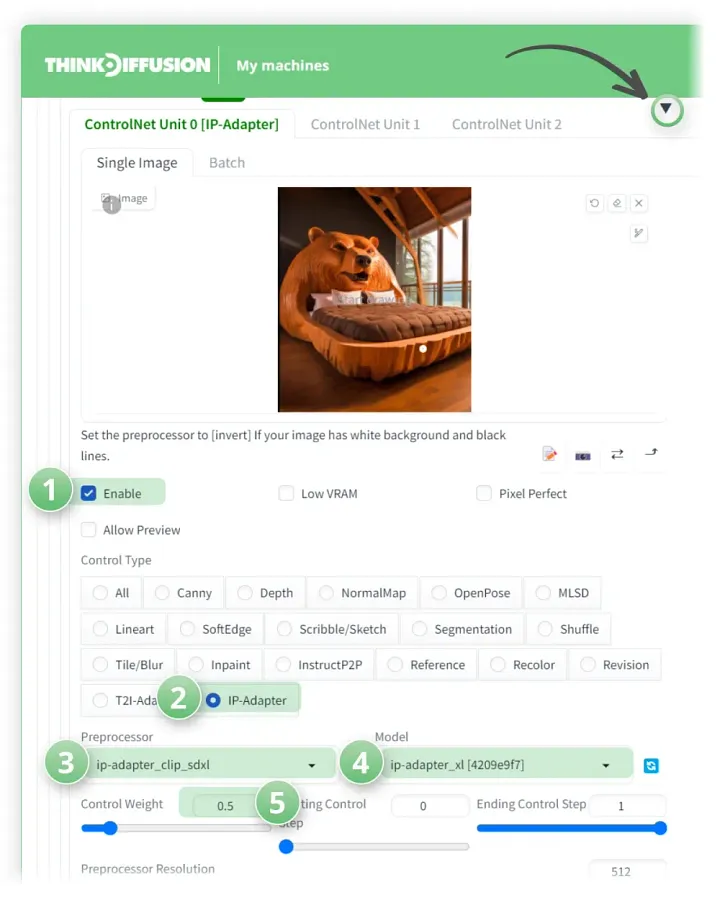

就像上面的步骤一样,下拉 ControlNet 选项卡:

- 单击 ✅ 启用

- 将控制类型设置为:IP 适配器

- 将预处理器设置为:ip-adapter_clip_sdxl

- 将 ControlNet 模型设置为:ip-adapter_xl

- 将控制权重设置为 0.5

点击生成,现在我们可以看到我们得到了我们想要的东西 😄

包括上述内容在内的任何工作流程都可以在 SD 的本地版本上运行,但如果您在安装或硬件速度慢方面遇到问题,你可以在浏览器中使用 ThinkDiffusion 在更强大的 GPU 上尝试这些工作流程中的任何一个。

原文链接:Mastering Image Prompts in Stable Diffusion AI with IP-Adapter

汇智网翻译整理,转载请标明出处