LangChain MCP 适配器

LangChain框架已成为将语言模型链集成到现实世界应用中的强大解决方案。其突出特性之一是MCP适配器,它提供了一种标准化的方式来向我们的链执行中注入自定义逻辑。

LangChain框架已成为将语言模型链集成到现实世界应用中的强大解决方案。其突出特性之一是MCP(模块化链管道)适配器,它提供了一种标准化的方式来向我们的链执行中注入自定义逻辑。

在这篇文章中,我们将探讨什么是LangChain MCP适配器,讨论它们的好处,并通过实际的Python示例演示如何在我们的应用程序中使用它们。

1、简介

随着AI驱动的应用程序的发展,开发人员在将多个处理步骤——例如数据预处理、模型推理和后处理——整合到一个连贯的管道时,常常会遇到挑战。

传统上,这涉及编写自定义的“粘合代码”,随着时间的推移,这种代码可能会变得脆弱且难以维护。

LangChain MCP适配器简化了这一任务。这意味着我们可以:

- 规范化输入

- 格式化输出

- 注入日志记录、错误处理或任何自定义功能

通过解耦这些关注点,MCP适配器帮助构建既灵活又易于维护的系统。

2、LangChain MCP适配器是什么?

LangChain MCP适配器被设计为一组模块化的组件,可以“插入”到LangChain链中。

它们的工作原理是:

- 预适配器: 在将输入传递给核心链之前执行逻辑。

- 核心链: 执行主要的语言模型操作(例如,总结或翻译)。

- 后适配器: 对链的输出执行额外的逻辑。

这种适配器模式促进了跨不同链和项目的通用功能的重用。

GitHub仓库langchain-ai/langchain-mcp-adapters提供了一系列内置适配器,例如日志记录和规范化适配器,我们可以直接使用或根据需要扩展它们。

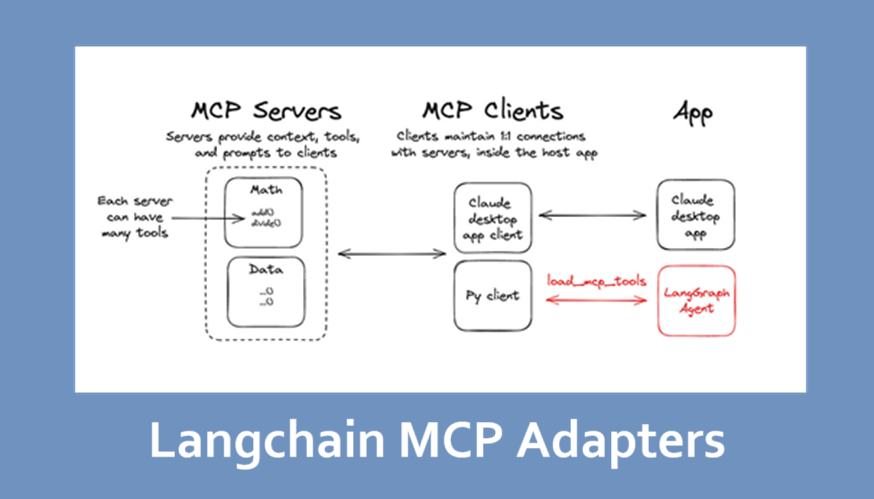

3、架构概述

使用MCP适配器时的典型架构如下:

- 核心链: LangChain组件(例如,LLMChain)执行主要任务。

- 预处理模块: 一个或多个适配器准备输入(例如,文本规范化、清理)。

- 后处理模块: 一个或多个适配器对链的输出进行细化(例如,格式化、日志记录)。

这种模块化设计使我们能够:

- 轻松替换或更新单个组件。

- 通过链式适配器构建复杂的多步管道。

- 确保每个处理步骤保持隔离且可测试。

4、在应用开发中的好处

- 模块化和可维护性

每个适配器负责单一任务。 这种关注点的分离使我们的应用程序更易于维护和扩展。 更新预处理例行程序或调整输出格式可以在不修改核心链逻辑的情况下独立完成。

- 灵活性和可重用性

适配器可以在多个项目中重用。 无论我们需要输入规范化、日志记录还是错误处理,都可以独立开发和测试这些适配器,然后将其插入不同的管道中。

- 快速原型设计

通过利用LangChain MCP适配器提供的标准化适配器接口,我们可以快速组装管道。 这加速了原型设计,并允许快速迭代而不必重写核心功能。

- 可扩展性

由于每个适配器都是模块化的, 我们可以独立分布或扩展处理管道的部分。 这对于处理大量数据或需要实时处理的应用程序特别有益。

5、存储库亮点

- AdapterBase类: 构建新适配器的基础类。

- 内置适配器: 示例包括

NormalizationAdapter(用于输入清理)和LoggingAdapter(用于监控和调试)。 - 使用示例和测试: 详细的文档和测试以帮助我们入门并验证功能。

- 贡献指南: 清晰的说明如何根据自定义需求扩展适配器。

要安装该包:

pip install langchain-mcp-adapters

6、Python实现:一个工作示例

让我们通过一个实际示例来走一遍。

在这个示例中,我们将构建一个自定义的MCP适配器,它包装了一个执行文本摘要的LLMChain。 我们将结合内置的规范化和日志记录适配器。

6.1 设置环境

安装所需包:

pip install langchain openai langchain-mcp-adapters

如果您计划使用OpenAI模型,请确保您拥有有效的OpenAI API密钥。

6.2 创建自定义MCP适配器管道

下面是一个示例,演示如何将预处理和后处理适配器与LLMChain集成。

from langchain.chains import LLMChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

# 从GitHub存储库导入MCP适配器框架和内置适配器

from langchain_mcp_adapters import MCPAdapter, NormalizationAdapter, LoggingAdapter

# 定义摘要的提示

template = "Summarize the following text: {text}"

prompt = PromptTemplate(template=template, input_variables=["text"])

# 初始化语言模型链

llm = OpenAI(temperature=0.5) # 根据需要调整温度

chain = LLMChain(llm=llm, prompt=prompt)

# 实例化内置适配器

normalization_adapter = NormalizationAdapter()

logging_adapter = LoggingAdapter()

# 使用MCP适配器包装核心链,应用预处理和后处理适配器

adapter = MCPAdapter(

chain=chain,

pre_adapters=[normalization_adapter],

post_adapters=[logging_adapter]

)

# 示例输入文本

input_text = """

LangChain MCP适配器提供了模块化的方法来集成AI服务。

它们通过隔离处理任务提高了应用开发的灵活性和可维护性。

"""

# 运行适配器管道

result = adapter.run(input_text)

print("处理结果:", result)

解释:

- 规范化适配器(预适配器): 清理和规范化输入文本(例如,修剪空白、小写化)。

- LLMChain(核心链): 处理规范化的文本以生成摘要。

- 日志记录适配器(后适配器): 记录输出,并可以扩展以执行其他后处理任务,例如格式化或错误检查。

此示例演示了如何使用MCP适配器在核心语言模型操作前后注入自定义逻辑——所有这些都不需要修改底层链。

7、在更大应用程序中集成MCP适配器

在真实世界的应用程序中,我们可能会将多个MCP适配器组合成一个综合的处理管道。 考虑以下策略:

- 管道编排: 使用控制器管理不同适配器之间的流程。

- 错误处理和监控: 扩展适配器以包含强大的日志记录、监控和故障转移策略。

- 微服务部署: 将各个适配器作为微服务部署,以便独立扩展处理。

通过利用MCP适配器,我们可以构建灵活、可维护且可扩展的AI管道,无缝融入现代应用程序架构。

8、最佳实践和未来方向

最佳实践:

- 专注于单一责任: 设计每个适配器以执行一项任务(例如,输入规范化或日志记录),以确保模块化。

- 编写单元测试: 在隔离状态下测试适配器,以便及早发现问题。

- 详细记录: 清楚描述每个适配器的目的、输入和输出。

- 监控性能: 实施日志记录和性能监控,以便快速诊断瓶颈或错误。

未来方向:

- 动态适配器链: 开发可以根据运行时条件自动选择和链接适配器的系统。

- 高级预处理/后处理: 结合更复杂语言模型功能以改进适配器功能。

- 社区协作: 向开源存储库贡献新的适配器,以扩展生态系统并分享最佳实践。

9、结束语

LangChain MCP适配器代表了构建AI驱动管道的强大范式转变。

通过封装预处理和后处理任务,MCP适配器使我们能够构建既灵活又易于维护的AI管道,从而更好地适应现代应用程序的需求。将逻辑封装成模块化、可重用的组件,这些适配器使构建、维护和扩展复杂的语言模型应用程序变得更加容易。

无论您是在开发一个简单的摘要工具,还是一个多步骤处理管道,集成MCP适配器都可以显著提升我们的开发工作流。

有关更详细的文档和最新更新,请查看LangChain MCP适配器GitHub仓库。

原文链接:Enhancing AI Pipelines with LangChain MCP Adapters

h汇智网翻译整理,转载请标明出处