用Dolphin MCP实现LLM路由

我正在构建一个内容分析工具,需要处理大量文本。OpenAI的模型功能强大但用于高容量处理时非常昂贵;而通过本地Ollama运行所有内容导致复杂推理任务的瓶颈。

作为一名花费无数夜晚调试API连接的开发者,我一直对AI模型领域的碎片化感到沮丧。这一周我用OpenAI做项目,下一周需要Ollama的本地推理以降低成本,然后我又尝试集成专门工具来完成特定任务。这是一个混乱的API、认证方法和响应格式的混合体——直到我发现模型上下文协议(MCP)和Dolphin MCP。

1、问题:集成头痛

让我描述一下我在MCP之前的生活:我正在构建一个内容分析工具,需要处理大量文本。OpenAI的模型功能强大但用于高容量处理时非常昂贵;而通过本地Ollama运行所有内容导致复杂推理任务的瓶颈。

我的代码库是一团乱麻的条件逻辑:

if task_requires_complex_reasoning:

# 调用OpenAI并创建参数

response = openai_client.chat.completions.create(...)

elif task_is_simple_classification:

# 调用Ollama并完全不同的参数

response = requests.post("http://localhost:11434/api/generate", ...)

else:

# 调用另一个服务并使用其独特的格式

# 更多条件代码...

每次我想添加新模型或工具时,意味着更多的if-else分支、更多的身份验证处理和更多的响应解析。我花在集成代码上的时间比实际功能开发还多!

2、我与MCP的“啊哈!”时刻

我在研究标准化AI交互方式时偶然发现了模型上下文协议。这个概念立即引起了共鸣:一种统一的协议,让不同的AI模型能够共享上下文、交换数据并使用标准化的方法调用工具。

这就像突然发现所有设备都可以使用相同的充电器一样。解脱感是显而易见的。

但真正的改变者出现在我发现Dolphin MCP时——一个开源的Python库,它以最小的麻烦实现了这个协议。在我发现它的第一个小时内,我就用一个干净一致的接口替换了几十行自定义集成代码。

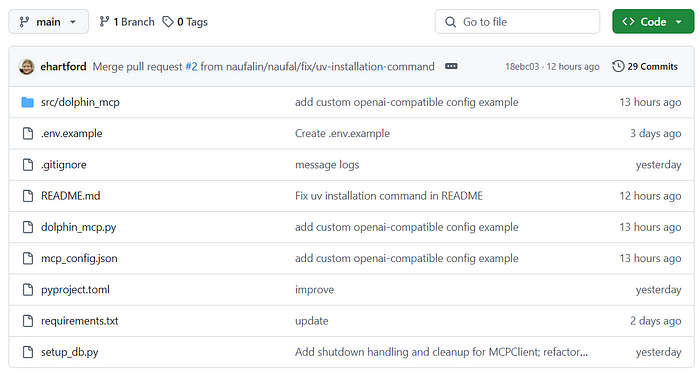

3、设置我的多模型AI工作台

在我的Windows开发机上运行Dolphin MCP出乎意料地简单。这是我的设置步骤:

a) 首先,我确保我的Python环境准备就绪:

python --version # 确认我有3.8+

b) 我直接从PyPI安装了包:

pip install dolphin-mcp

c) 创建了我的.env文件,并输入了我的API密钥:

OPENAI_API_KEY=my_actual_key_here

OPENAI_MODEL=gpt-4o

d) 设置了一个基本的mcp_config.json来定义我的服务器连接:

{

"mcpServers": {

"ollama-local": {

"command": "ollama serve",

"args": []

}

}

}

最耗时的部分其实是找到不同服务的API密钥——Dolphin MCP本身的设置非常简单。

4、第一次测试:多模型查询

一切设置好后,我用CLI工具运行了第一个测试:

dolphin-mcp-cli "Analyze the sentiment of this customer feedback: 'Your product has completely transformed our workflow!'"

魔法在后台发生:Dolphin MCP将我的查询路由到适当的模型,处理身份验证,处理响应,并返回一个干净的结果。不再担心调用哪个模型或如何格式化请求!

对于更复杂的场景,我切换到了Python库:

import asyncio

from dolphin_mcp import run_interaction

async def analyze_multiple_feedbacks(feedbacks):

results = []

for feedback in feedbacks:

result = await run_interaction(

user_query=f"Analyze sentiment: {feedback}",

model_name="gpt-4o" if len(feedback) > 100 else "ollama", # 根据复杂度选择合适的模型

quiet_mode=True

)

results.append(result)

return results

# 这个简单的函数节省了我50多行模型特定代码

5、实际应用:我的内容分析管道

有了Dolphin MCP作为我的工具,我重建了我的内容分析管道,以高效利用多个模型:

- 初始处理 使用本地运行的Ollama(快速且免费)

- 复杂推理任务 路由到OpenAI(当需要时)

- 专业化分析 使用通过MCP连接的定制工具

代码干净、可维护,最重要的是可扩展性强。当新的模型或工具出现时,我可以将其添加到我的MCP生态系统中,而无需修改核心应用程序逻辑。

我最喜欢的部分?代码复杂性的大幅减少。以前几百行模型特定逻辑变成了一个流线型的工作流程,专注于实际任务而不是集成细节。

6、开发人员体验改进

除了技术优势,Dolphin MCP还以多种方式改变了我的开发工作流程:

- 更快的原型设计:我可以轻松地通过简单的参数更改切换模型,使实验不同方法变得容易。

- 更干净的代码库:不再有模型特定分支充斥我的逻辑。

- 更好的错误处理:标准化的错误响应使调试变得更加简单。

- 成本优化:只有在必要时才使用昂贵的模型,将常规任务回退到本地模型。

- 未来保护:随着新模型的出现,我可以将它们添加到我的工具箱中,而无需重写应用程序代码。

CLI工具也成为了我的首选,用于快速测试和实验。我不再需要为不同的模型设置单独的环境,而是可以通过单个命令测试跨多个提供商的想法。

7、经验、教训和建议

如果你考虑在自己的项目中实现Dolphin MCP,这里有一些来自我的经验的建议:

- 从CLI工具开始,熟悉工作流程后再深入Python库。

- 使用环境变量 来存储所有API密钥和配置设置——这使得在开发和生产环境中切换变得更加容易。

- 为不同类型的任务创建模型特定配置文件。我有“快速分析”(Ollama)、“深度推理”(OpenAI)和“专业化任务”(定制工具)的配置文件。

- 实现优雅的回退策略 在你的代码中。即使有MCP,模型有时也会失败,因此拥有回退策略很重要。

- 为项目贡献! Dolphin MCP是开源的,社区从更多开发人员分享他们的用例和改进中受益。

8、结束语

作为开发人员,我们常常被特定模型或供应商的炒作所吸引,但实际上的力量来自于能够无缝结合不同的工具。Dolphin MCP从根本上改变了我对AI集成的看法,将我的注意力从“我应该使用哪个模型?”转移到“我试图完成什么?”

如果你正在构建利用AI能力的应用程序,我强烈推荐你尝试Dolphin MCP。它将我的开发工作流程从不同API的碎片化状态转变为一种既更强大又更容易维护的统一方法。

AI开发的未来不是关于选择正确的模型——而是关于协调多个模型和工具,创造比其各部分总和更大的解决方案。像Dolphin MCP这样的工具正在使这种未来今天对开发人员来说触手可及。

快乐编码,愿你的API集成永远简化!

原文链接:Breaking Down Barriers: My Journey Connecting AI Models Using Dolphin MCP

汇智网翻译整理,转载请标明出处