ONNX初学者指南

想要简化跨平台部署 AI 的过程?了解 ONNX 如何一步步改变你的游戏规则!

跨平台推理或缓慢、未优化的模型让你苦苦挣扎?让我们快速轻松地深入了解 ONNX — 它的工作原理、亮点所在以及如何像专业人士一样排除模型故障!

1、ONNX ?

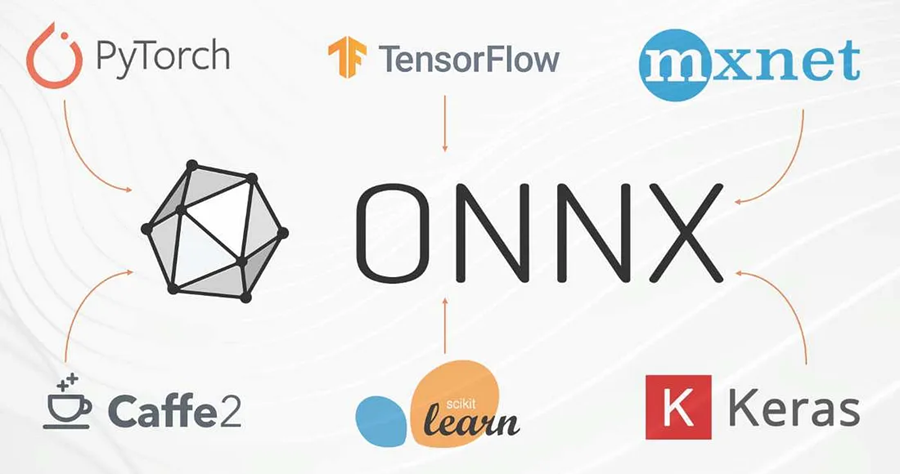

ONNX(开放神经网络交换)就像是 AI 模型的通用转换器 — 一种允许你跨平台保存和共享机器学习或深度学习模型的格式,就像 h5 或 pth 文件一样。它是开源的并且与框架无关,这意味着你可以在 PyTorch 或 TensorFlow 中训练模型并将其部署到任何地方,从 ONNX Runtime 到自定义边缘设备,而无需担心兼容性问题。

1.1 为什么要使用 ONNX ?

在构建机器学习或深度学习模型时,训练通常会遵循特定的框架 — 但生产需要灵活性。这就是 ONNX 介入的地方,它充当了一座通用桥梁。它使模型可移植性更容易,加快部署速度,并确保跨环境的可扩展性,无论是云还是边缘设备。

1.2 ONNX 的一些常见场景

- 使用不同框架的团队之间共享模型。

- 降低管理多个框架和库的复杂性。

- 在资源有限的边缘设备上运行轻量级模型。

1.3 ONNX 的主要特点

ONNX 带来了很多好处:

- 互操作性:在 PyTorch 和 TensorFlow 等框架之间无缝传输模型。

- 跨平台:轻松在 CPU、GPU 或专用硬件上运行模型。

- 推理优化:使用图形修剪和量化等技术提高性能。

- 框架支持:适用于流行的 ML 框架,如 PyTorch、TensorFlow 和 scikit-learn。

- 标准化:一种简化模型交换和部署的通用文件格式。

- 开源:完全免费,拥有支持社区和定期更新。

- 更小的模型尺寸:减小模型尺寸,以便在边缘设备上更快、更高效地部署。

2、将模型导出到 ONNX

设置环境:

pip install onnx onnxruntime

从 PyTorch 导出:

import torch

# Define or load your model

model = MyModel() # Your trained model

model.eval() # Set the model to evaluation mode

# Define a dummy input with the same shape as real input,to let the model know about the input size as a input.

dummy_input = torch.randn(1, 3, 224, 224)

# Export the model to ONNX

torch.onnx.export(

model,

dummy_input,

"model.onnx",

export_params=True,

opset_version=11, # Specify the ONNX opset version

input_names=['input'],

output_names=['output']

)从 Tensorflow 导出,使用 tf2onnx 转换器:

python -m tf2onnx.convert --saved-model ./saved_model --output model.onnx从 Scikit-learn 导出:

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

# Train a model

model = LogisticRegression().fit(X_train, y_train)

# Define input type

initial_type = [('float_input', FloatTensorType([None, X_train.shape[1]]))]

# Convert and save as ONNX

onnx_model = convert_sklearn(model, initial_types=initial_type)

with open("model.onnx", "wb") as f:

f.write(onnx_model.SerializeToString())3、部署 ONNX 模型

将模型转换为 ONNX 后,下一步是使用 ONNX Runtime — 这是一种多功能工具,支持多种编程语言(如 Python、C++ 和 Java),并在各种硬件平台上顺利运行。它是你高效且可扩展的模型部署的门户!

import onnxruntime as ort

import numpy as np

# Load the ONNX model

session = ort.InferenceSession("model.onnx")

# Prepare input

input_name = session.get_inputs()[0].name

output_name = session.get_outputs()[0].name

input_data = np.random.randn(1, 3, 224, 224).astype(np.float32)

# Run inference

result = session.run([output_name], {input_name: input_data})

print("Inference result:", result)4、优化 ONNX 模型

想要让你的 ONNX 模型更快更轻量吗?以下是一些优化技巧:

- 量化:使用 ONNX Runtime 的量化 API 降低模型的精度(例如,从 FP32 到 INT8),节省资源而不损失准确性。

- 模型修剪:修剪不必要的层或参数以简化模型。

- 图优化:使用内核融合、冗余节点删除和常量折叠等技术提高性能。优化更智能,而不是更难!

5、挑战和最佳实践

ONNX 是一个强大的工具,但与任何技术一样,它也面临着挑战。

挑战:

- Opset 版本不匹配:确保模型和运行时版本一致。

- 框架特定问题:某些操作可能无法在框架之间顺利转换。

- 调试错误:Netron 等工具可以帮助您可视化和排除模型故障。

最佳实践:

- 转换后,务必彻底测试你的 ONNX 模型。

- 保持框架和 ONNX 导出器为最新。

- 优化模型以匹配你的部署硬件,以获得最佳性能。

掌握这些,ONNX会非常有效!

6、结束语

对于任何希望简化 AI 工作流程(从模型开发到部署)的人来说,ONNX 都是一个改变游戏规则的产品。通过弥合框架和平台之间的差距,它使 AI 模型更具可移植性、可扩展性和效率。无论您是与使用不同工具的团队合作、针对边缘设备进行优化,还是旨在实现更快的推理,ONNX 都能满足你的需求。

虽然存在诸如 opset 不匹配或特定于框架的怪癖等挑战,但遵循最佳实践并利用 ONNX Runtime 等工具可以让你的旅程顺利而有益。凭借其开源性质和不断壮大的社区,ONNX 不断发展以满足现代 AI 开发的需求。

准备好将你的 AI 模型提升到一个新的水平了吗?立即开始探索 ONNX,让它改变你构建和部署智能解决方案的方式!

原文链接:ONNX for Beginners: What, Why, and How to Use It in Your AI Workflow

汇智网翻译整理,转载请标明出处