Phi-4 GGUF快速指南

本指南将引导你完成在自己的机器上设置和使用 Phi-4 GGUF 的过程,使你能够利用其功能执行各种自然语言处理任务。

Microsoft 的 Phi-4 是一种高级语言模型,最近以 GGUF 格式提供,允许本地部署和使用。本指南将引导你完成在自己的机器上设置和使用 Phi-4 GGUF 的过程,使你能够利用其功能执行各种自然语言处理任务。

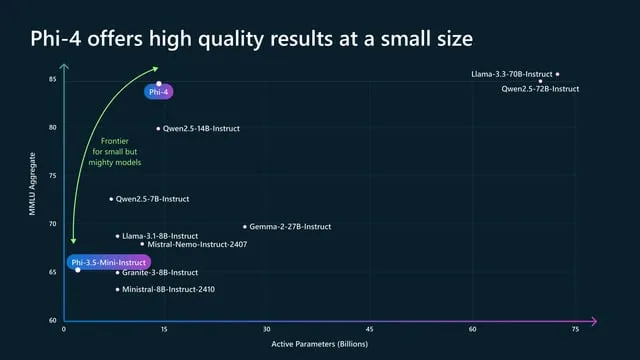

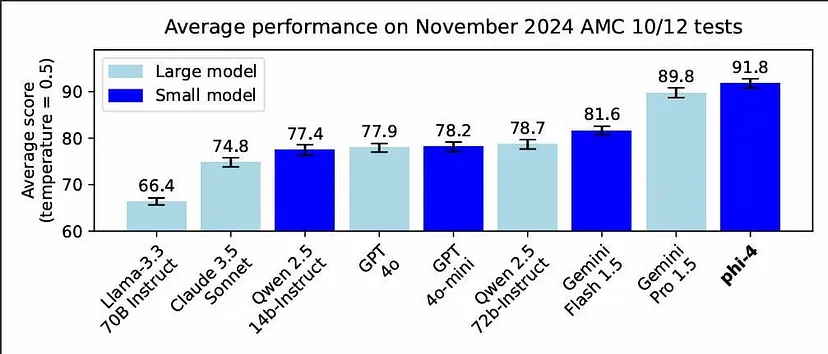

1、Phi-4:小而强大

Phi-4 是 Microsoft Phi 系列语言模型的最新版本。它代表了 AI 技术的重大进步,旨在以更高的效率和准确性处理广泛的语言任务。GGUF(GPT 生成的统一格式)是一种文件格式,针对在消费级硬件上高效加载和推理大型语言模型进行了优化。

Phi-4 的主要功能:

- 高级自然语言理解

- 改进上下文保留

- 增强各种 NLP 任务的性能

GGUF 格式的优势:

- 减少内存占用

- 加载时间更快

- 针对消费硬件进行了优化

2、下载 Phi-4 GGUF

要开始使用 Phi-4 GGUF,你首先需要下载模型文件。截至目前,非官方版本可通过社区成员的 Hugging Face 存储库获得。

下载步骤:

- 访问 Hugging Face 存储库

- 选择适合你需求的量化选项(Q8_0、Q6_K 或 f16)

- 下载所选模型文件

注意:微软的官方版本预计在不久的将来发布,可能会提供更多功能或优化。

3、设置环境

在运行 Phi-4 GGUF 之前,你需要使用必要的工具和依赖项设置环境。所需软件:

- Python 3.7 或更高版本

- Git(用于克隆存储库)

- 兼容的推理引擎(例如 llama.cpp 或 Ollama)

安装步骤:

- 如果尚未安装,请从官方网站安装 Python

- 如果系统中不存在 Git,请从 git-scm.com 安装

- 选择并安装推理引擎(详见下一节)

4、使用llama.cpp部署Phi-4 GGUF

llama.cpp 是一种流行的推理引擎,用于在本地运行大型语言模型。以下是如何将其设置为与 Phi-4 GGUF 一起使用:

设置 llama.cpp:

- 克隆 llama.cpp 存储库:

git clone https://github.com/ggerganov/llama.cpp.git\- 导航到克隆的目录:

cd llama.cpp- 构建项目:

make使用 llama.cpp 运行 Phi-4:

- 将下载的 Phi-4 GGUF 文件放在模型目录中

- 使用以下命令运行模型:

./main -m models/phi-4-q8_0.gguf -n 1024 --repeat_penalty 1.1 --temp 0.1 -p "Your prompt here"根据你的具体用例调整参数。

有关更多详细信息,可以阅读 llama.cpp repo 上的这个PR 。

5、使用 Ollama部署Phi-4 GGUF

Ollama 是另一个在本地运行语言模型的出色工具,提供更用户友好的界面。

安装 Ollama:

- 访问ollama网站并下载适合您操作系统的版本

- 按照网站上提供的安装说明进行操作

在 Ollama 中运行 Phi-4 模型:

- 创建一个名为 Modelfile 的模型文件,内容如下:

运行以下命令测试模型:

ollama run vanilj/Phi-4更多详细信息请参阅这个链接。

6、结束语

Phi-4 GGUF 代表了在使高级语言模型可用于本地部署方面迈出的重要一步。按照本指南,你现在应该能够下载、设置和使用 Phi-4 GGUF 执行各种自然语言处理任务。在探索其功能时,请记住随时了解快速发展的人工智能和语言模型领域的最新发展和最佳实践。

原文链接:How to Use Phi-4 GGUF: A Quick Guide

汇智网翻译整理,转载请标明出处