QwQ-32B本地运行指南

在这个指南中,我们将一步步带你完成本地运行QwQ-32B的整个过程。我们将使用工具如Ollama和LM Studio来使设置尽可能简单。

是否曾经想过在本地机器上运行一个强大的语言模型?介绍QwQ-32B,这是阿里巴巴最新且最强大的LLM。无论你是开发者、研究人员还是仅仅对技术感兴趣的爱好者,运行QwQ-32B可以打开一扇新世界的大门——从构建自定义AI应用程序到实验高级自然语言处理任务。

在这个指南中,我们将一步步带你完成整个过程。我们将使用工具如Ollama和LM Studio来使设置尽可能简单。

准备好深入了吗?让我们开始吧!

1、理解QwQ-32B?

在我们跳入技术细节之前,让我们花点时间了解一下QwQ-32B是什么。QwQ-32B是一个具有320亿参数的最先进的语言模型,旨在处理复杂的自然语言任务,如文本生成、翻译和摘要。它是一个为开发者和研究人员设计的强大工具,用于推动人工智能的边界。

在本地运行QwQ-32B可以让你完全控制模型,允许你根据特定用例进行定制,而无需依赖云服务。隐私、定制化、成本效益和离线访问是你在本地运行该模型时可以利用的一些特性。

前提条件

在你可以在本地运行QwQ-32B之前,你的本地机器需要满足以下要求:

- 硬件:一台至少有16GB内存和一块最低24GB显存的高端GPU(例如NVIDIA RTX 3090或更好)的强力机器,以获得最佳性能。

- 软件:Python 3.8或更高版本,Git以及像pip或conda这样的包管理器。

- 工具:Ollama和LM Studio(我们将在后面详细介绍)。

2、使用Ollama在本地运行QwQ-32B

Ollama是一个轻量级框架,简化了在本地运行大型语言模型的过程。以下是安装步骤:

2.1 下载并安装Ollama

- 对于Windows和macOS,从官方Ollama网站下载可执行文件并运行它以完成安装。然后按照安装设置中的简单安装说明操作。

- 对于Linux用户,你可以使用以下命令:

curl -fsSL https://ollama.ai/install.sh | sh

- 验证安装:安装完成后,如果你想验证Ollama是否正确安装,打开终端并运行:

ollama --version

- 如果安装成功,你会看到版本号。

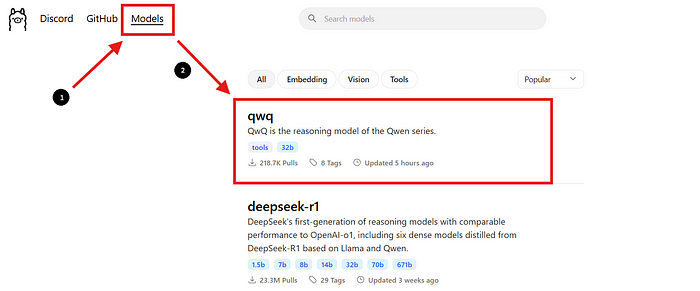

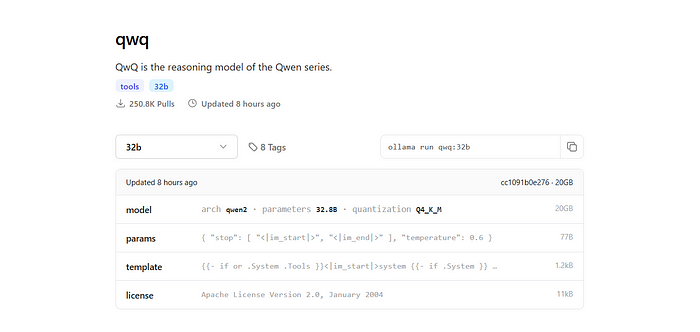

2.2 查找QwQ-32B模型

- 返回Ollama网站并导航到“Models”部分。

- 使用搜索栏找到“QwQ-32B”。

- 找到QwQ-32B模型后,页面上会提供安装命令。

2.3 下载QwQ-32B模型

- 打开一个新的终端窗口以下载模型并运行以下命令:

ollama pull qwq:32b

- 下载完成后,你可以通过运行以下命令来验证模型是否已安装:

ollama list

- 该命令将列出你使用Ollama下载的所有模型,确认QwQ-32B可用

2.4 运行QwQ-32B模型

在终端中运行模型:

- 要直接在终端中与QwQ-32B模型交互,请使用以下命令:

ollama run qwq:32b

- 你可以在终端中输入问题或提示,模型将相应地作出回应。

使用交互式聊天界面:

- 另外,你可以使用诸如Chatbox或OpenWebUI之类的工具创建一个交互式GUI来与QwQ-32B模型聊天。

- 这些界面提供了一种更友好的方式与模型交互,特别是如果你更喜欢图形界面而不是命令行界面。

3、使用LM Studio在本地运行QwQ-32B

LM Studio是一个用户友好的界面,用于在本地运行和管理语言模型。以下是设置步骤:

3.1 下载LM Studio

- 首先,访问LM Studio的官方网站lmstudio.ai。在这里你可以下载适用于你的操作系统的LM Studio应用程序。

- 在他们的页面上,导航到下载部分并选择与你的操作系统(Windows、macOS或Linux)匹配的版本。

3.2 安装LM Studio

- 按照你操作系统的简单安装说明进行操作。

3.3 查找并下载QwQ-32B模型:

- 打开LM Studio并导航到“我的模型”部分。

- 点击搜索图标并在搜索栏中输入“QwQ-32B”。

- 从搜索结果中选择QwQ-32B模型的所需版本。你可能会发现不同的量化版本,例如4位量化模型,这可以帮助减少内存使用同时保持性能。

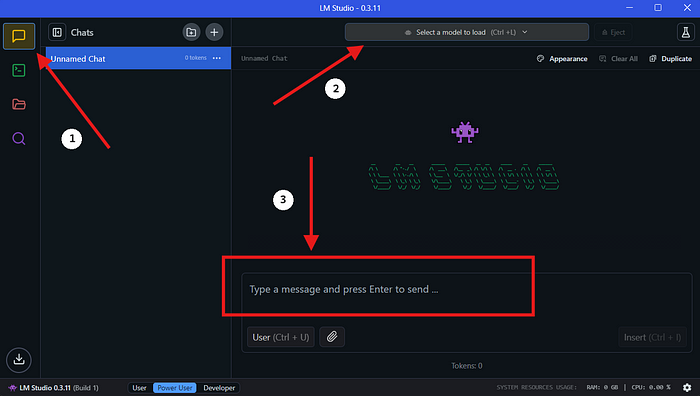

3.4 在LM Studio中本地运行QwQ-32B

- 选择模型:下载完成后,进入LM Studio的“聊天”部分。在聊天界面中,从下拉菜单中选择QwQ-32B模型。

- 与QwQ-32B交互:开始在聊天窗口中提问或提供提示。模型将处理你的输入并生成响应。

- 配置设置:你可以在“高级配置选项卡”中根据你的偏好调整模型的设置。

4、结束语

在本地运行QwQ-32B是一种强大方法,可以利用先进的AI模型的能力而不依赖云服务。借助工具如Ollama和LM Studio,这一过程比以往任何时候都更容易。

汇智网翻译整理,转载请标明出处