用LM Studio本地运行大模型

LM Studio 是一款流行的 GUI 应用程序,它允许具有基本计算机知识的用户在其 Linux 机器上轻松下载、安装和运行大型语言模型 (LLM)。

LM Studio 是一款流行的 GUI 应用程序,它允许具有基本计算机知识的用户在其 Linux 机器上轻松下载、安装和运行大型语言模型 (LLM)。

可以使用 LM Studio 聊天界面轻松安装、设置和访问流行的 LLM 模型,例如 Llama 3、Phi3、Falcon、Mistral、StarCoder、Gemma 等。

这样,你就不会被 OpenAI 的 ChatGPT 等专有的基于云的 AI 所困扰,并且可以轻松地在离线状态下私下运行自己的 LLM,而无需为完整功能支付任何额外费用。

在本文中,我将向你展示如何在 Linux 上安装 LM Studio、下载并使用 GPT-3 模型。

系统要求

在 PC 上本地运行 LLM 模型需要满足某些最低要求才能确保获得良好的体验。确保你至少拥有...

- 具有至少 8 GB VRAM 的 NVIDIA 或 AMD 显卡。

- 20 GB 的免费存储空间(SSD 是更好的选择)。

- 6 GB DDR4 RAM。

1、在 Linux 上安装 LM Studio

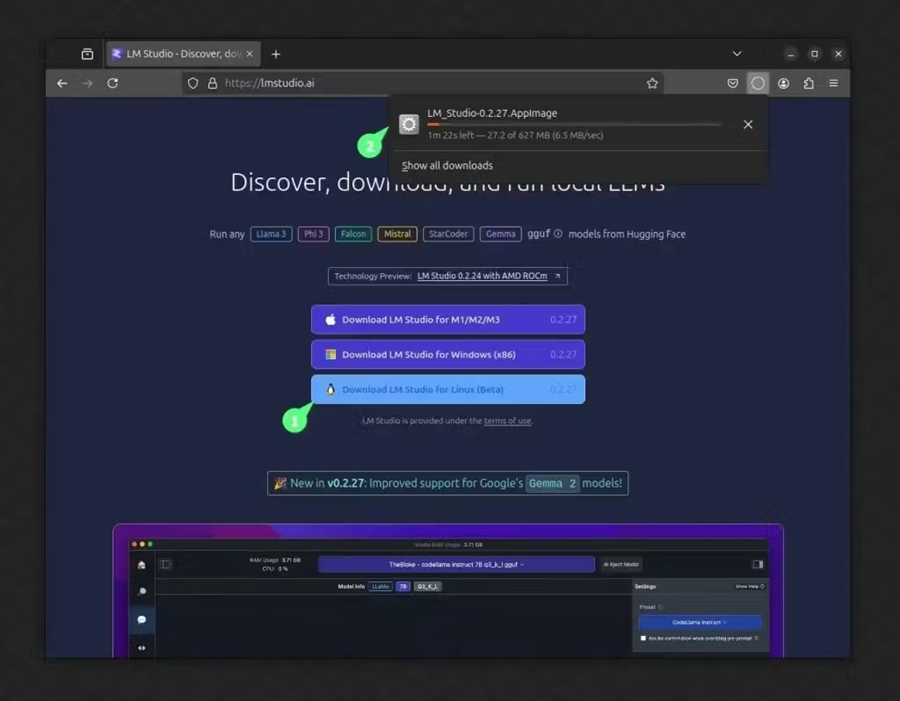

首先,访问 LM Studio 官方网站,点击“下载适用于 Linux 的 LM Studio”下载 LM Studio AppImage。

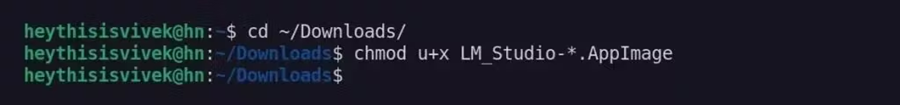

下载完成后,打开终端,导航到下载目录,并为 LM Studio AppImage 分配可执行权限。

$ cd ~/Downloads/

$ chmod u+x LM_Studio-*.AppImage

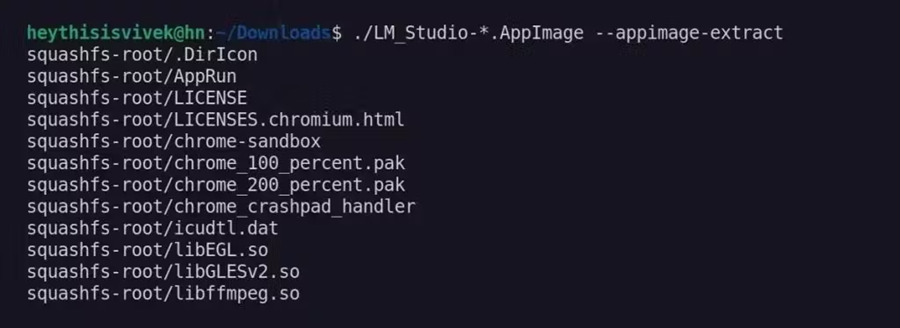

接下来,使用以下命令解压 AppImage 的内容,这将创建一个名为“squashfs-root”的新目录。

$ ./LM_Studio-*.AppImage --appimage-extract

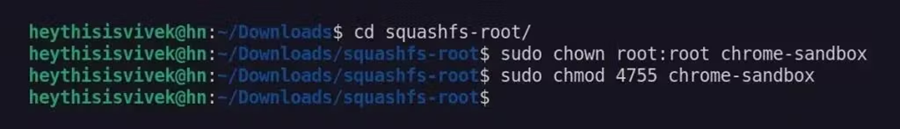

现在,导航到提取的“squashfs-root”目录并为“chrome-sandbox”文件分配适当的权限和所有权。

$ cd squashfs-root/

$ sudo chown root:root chrome-sandbox

$ sudo chmod 4755 chrome-sandbox

最后,使用以下命令在同一目录中运行 LM Studio 应用程序:

$ ./lm-studio

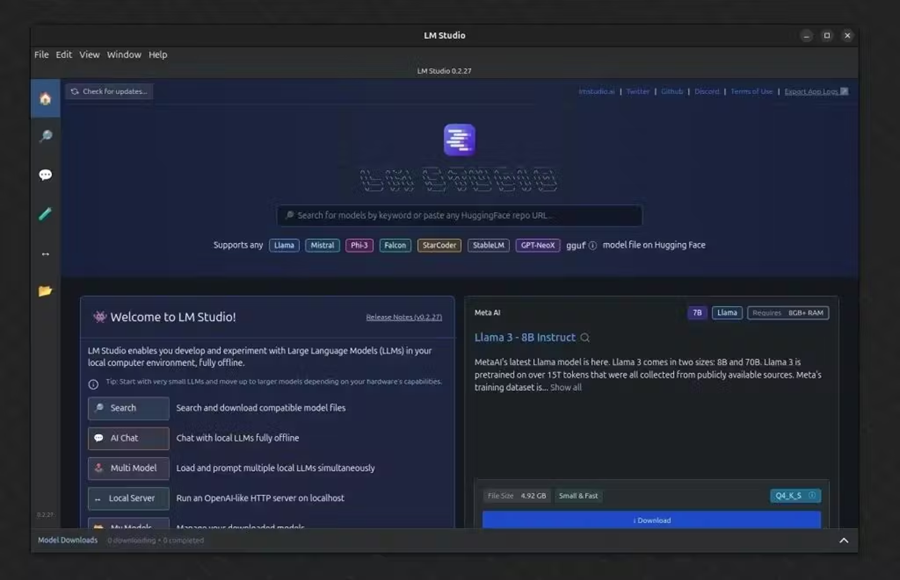

就是这样!现在,你可以使用 LM Studio 搜索、下载和访问你喜欢的开源 LLM。有关设置和访问 GPT-3 的说明,请参阅下一部分。

2、在 LM Studio 中访问 GPT-3 模型

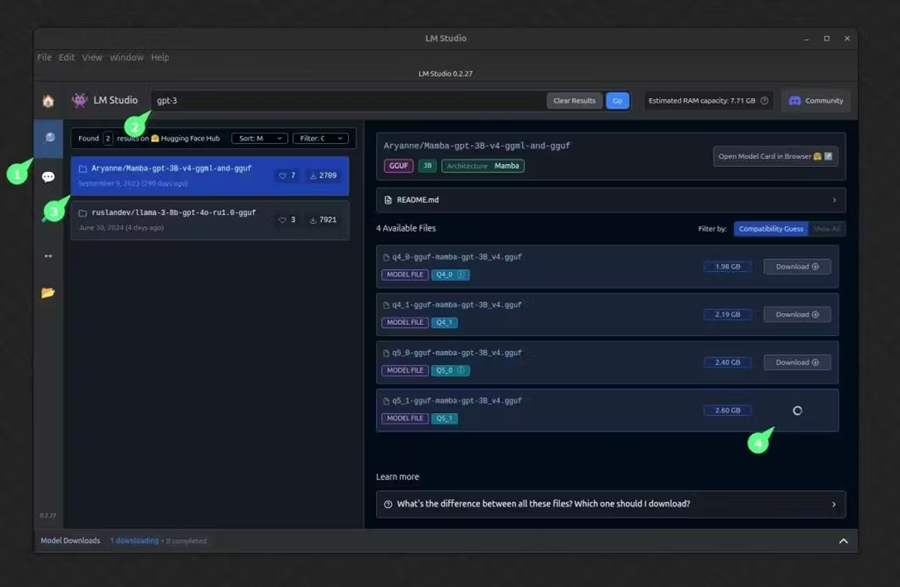

要访问 GPT-3 模型,你需要先下载它。为此,请单击左侧面板中的搜索图标,键入“GPT-3”作为模型名称,然后根据你的系统规格选择适当的模型大小。

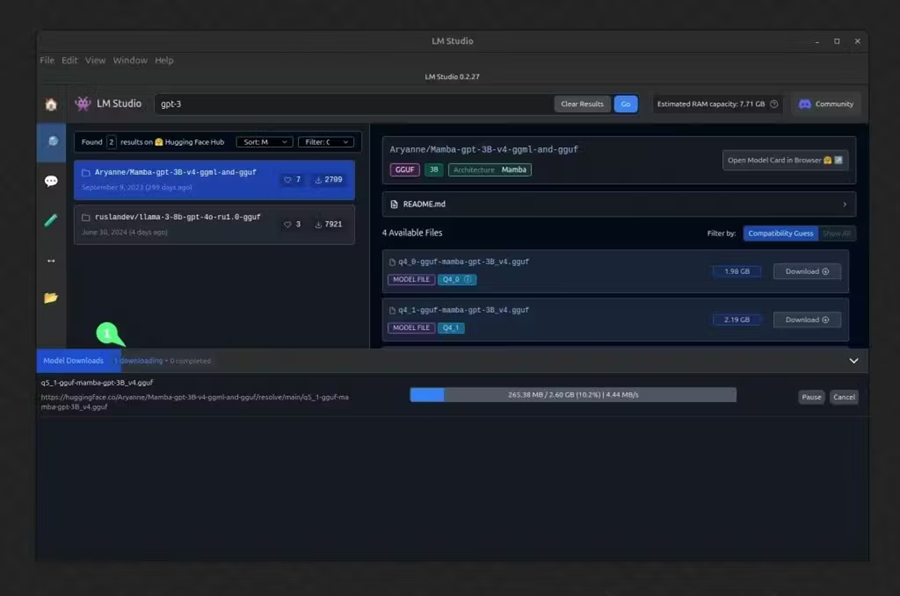

下载过程将开始,你可以通过单击底部面板来跟踪进度。

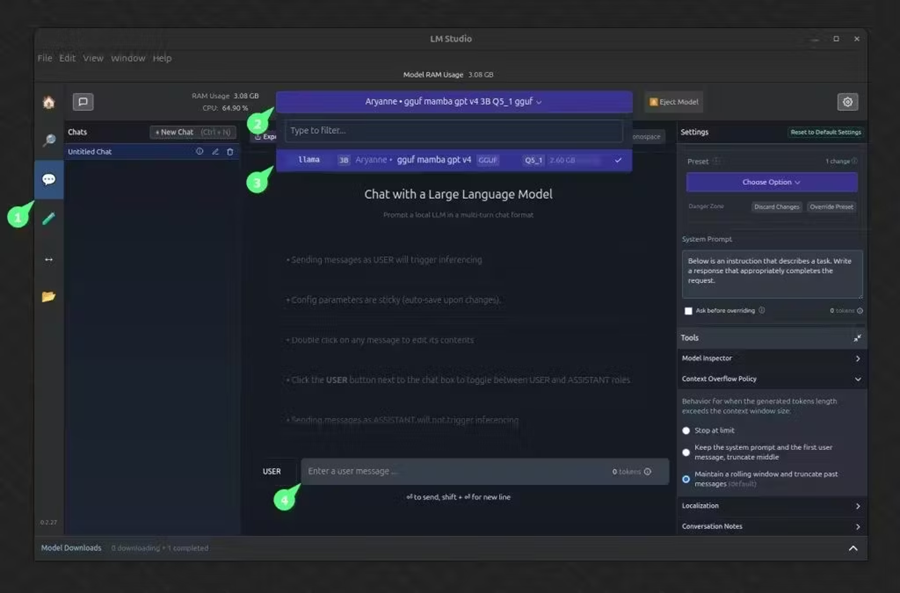

下载完成后,单击左侧面板上的聊天图标,从顶部下拉菜单中选择 GPT-3 模型,然后在底部输入字段中输入消息,开始与 GPT-3 模型聊天。

就是这样!你现在可以在 GPT-3 模型上本地询问任何问题。响应时间可能因系统规格而异。例如,我有一个不错的 GPU,具有 8 GB 的 VRAM 和 16 GB 的 DDR4 RAM,大约需要 45 秒才能生成 150-200 个单词。

如果你的情况响应太差,可以尝试使用不同的 LLM 模型。我建议使用 Meta Llama 3,并确保选择最小的模型尺寸。

3、结束语

在本文中,我们学习了如何使用 LM Studio 在本地 PC 上下载和访问开源 LLM 模型,如 GPT-3 和 Llama 3。现在,在你从云服务过渡到使用 PC 攻读 LLM 之前,请记住它使用 GPU,这会消耗电力并影响 GPU 寿命。

因此,如果你是 AI 爱好者和隐私倡导者,它不会困扰你,但如果你担心电费或 PC 性能较差,那么不幸的是,基于云的 AI 可能是你唯一的选择。

原文链接:How to Run LLMs Using LM Studio in Linux (for Beginners)

汇智网翻译整理,转载请标明出处