ComfyUI使用FLUX.1量化模型

大部分人的硬件无法提供16-24GB显存来运行FLUX.1模型,本文介绍如何在ComfyUI中使用量化的FLUX.1模型在消费级硬件上生成图像。

FLUX.1 dev 和 schnell 开源文本到图像生成模型提供无与伦比的质量,性能可与专有模型媲美。但是,运行这些新模型(尤其是 FLUX.1 dev)需要 16-24GB 的 VRAM 来运行完整的未压缩模型——许多人手头都没有。

这就是量化模型的价值。

1、量化模型

借鉴开源 LLM 对应模型,量化模型本质上是经过压缩的全尺寸模型。压缩程度越高,所需 VRAM 的减少量越大,但最终输出的准确性/质量会降低。

但是,这种质量成本允许模型在低端硬件上运行。

有许多不同的量化策略。如果你想了解更多信息,请阅读 Maarten Grootendorst 的这篇精彩文章。

那么,为什么现在需要量化模型,而稳定扩散却不需要?

Stability 之前的文本转图像生成模型(如 Stable Diffusion 1.5、SD2 和 SDXL)不够复杂,因此不需要使用量化模型。

除了 FLUX.1 的较大模型外,你还需要使用 CLIP 和 T5-XXL 编码器模型 - 后者还提供量化模型以减少 VRAM 占用空间。

2、环境搭建

对于环境设置,我们将介绍在哪里下载和放置模型文件以及在 ComfyUI 中安装自定义节点。你也可以在此简短视频中观看分步过程:

2.1 下载和放置模型

开发人员 city96 慷慨地在 HuggingFace 上提供了 FLUX.1 dev 和 schnell 模型量化模型,范围从 2 位到 16 位(原始 FLUX 模型为 32 位)。

决定正确的位量化并不简单,因为它会因你的特定机器而异。但是,对于大多数人来说,4 位或 6 位模型(Q4 或 Q6)将是一个很好的起点。

下载 .gguf 文件时,你需要将其放在 ComfyUI/models/unet 目录中。

对于你可以在此处找到的 T5-XXL 编码器模型,作者指出“因此建议使用 Q5_K_M 或更大的编码器以获得最佳效果”。

将量化的 T5-XXL 模型放在 ComfyUI/models/clip 目录中。

2.2 安装 ComfyUI-GGUF 自定义节点

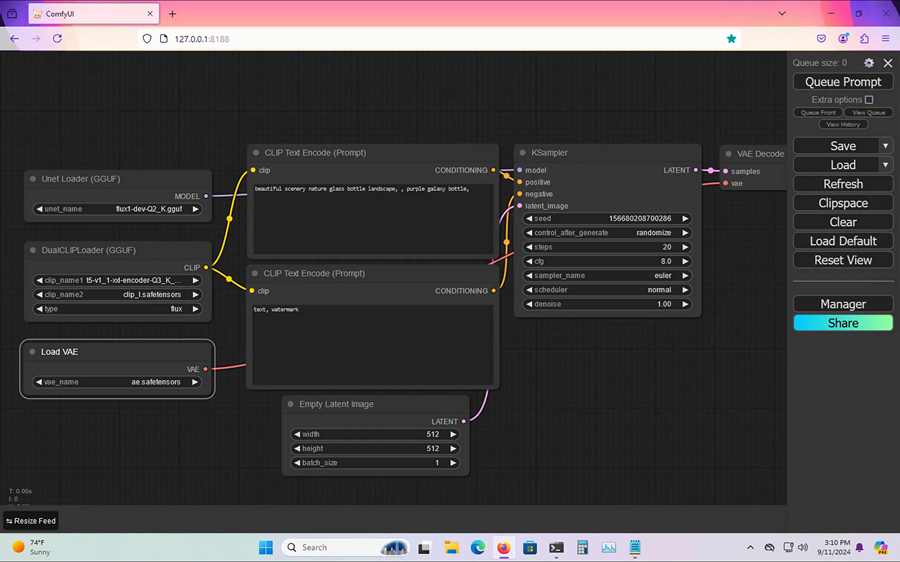

在 ComfyUI 管理器中,你需要安装 ComfyUI-GGUF 自定义节点。这会将 UNet Loader GGUF 和 DualClip Loader GGUF 节点添加到你的 ComfyUI 实例中。

3、在 ComfyUI 中运行FLUX.1 GGUF模型

在 ComfyUI 中运行 FLUX.1 GGUF 文件非常简单。只需执行以下操作:

3.1 设置自定义节点

要使用 GGUF 文件,我们将在工作流程的开始处添加 UNet Loader GGUF 和 DualClip Loader GGUF 节点:

确保将 DualClip Loader GGUF 设置为同时包含 CLIP 和 T5-XXL (GGUF) 模型以及类型的 flux 选项。虽然 FLUX 不支持负提示,但你仍需要将 CLIP 输出连接到 CLIP Text Encode (Prompt) 节点的 CLIP 输入;否则,ComfyUI 将抛出错误。

UNet Loader GGUF 节点将支持 ComfyUI/models/unet 目录中提供的任何 GGUF 文件。

注意: ae.safetensors 文件是 Black Forest Labs 团队提供的 VAE。如果还没有,可以从 HuggingFace 下载。3.2 提示、KSampler 和潜在空间

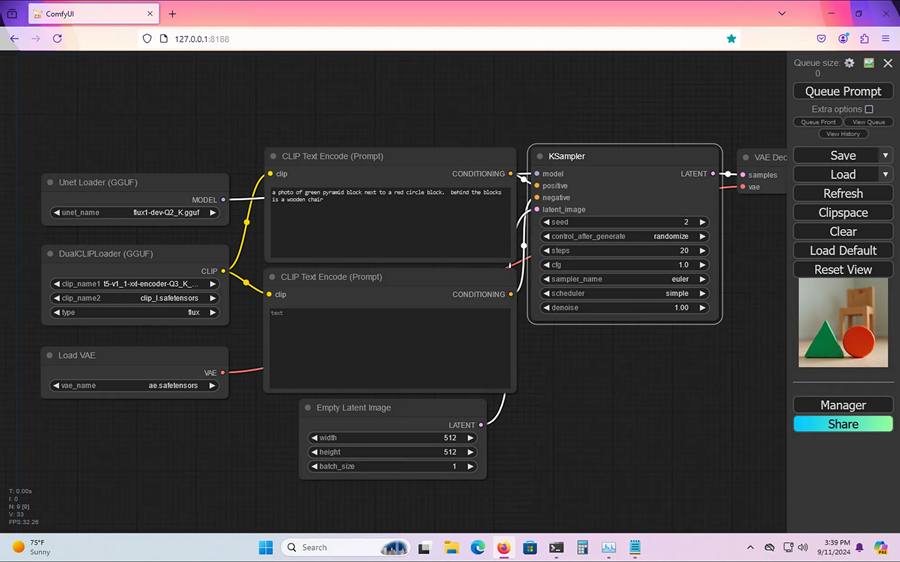

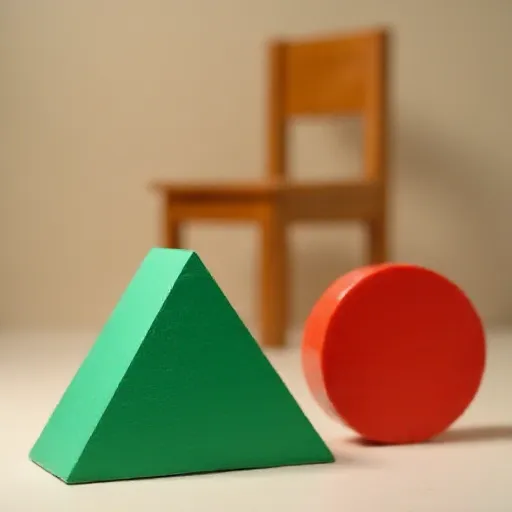

FLUX 相对于以前的模型的优势在于它可以非常好地遵循提示。

因此,你不必说 1 个块、绿色、自然光,而是可以更加详细地描述,并且模型将产生与你的提示一致的更好结果。使用 FLUX 模型时,请务必采用这种方法。

如前所述,负提示将留空。对于 KSampler 节点,你需要设置以下内容:

- CFG:1.0

- 采样器名称:Euler

- 调度程序:简单

最后,潜在空间大小可以有很大差异,支持的分辨率在 0.1 到 2 兆像素之间。

最终的工作流程将如下所示:

你还可以在 Prompting Pixels 网站找到下载此工作流程的链接。

3.3 队列提示和查看结果

最后,点击 Queue Prompt并在 ComfyUI 中查看结果。对于一张 512x512 的图像,提示是 a photo of green pyramid block next to a red circle block. behind the blocks is a wooden chair,FLUX 生成了这张图片:

仅举一些一般细节,上面的图像渲染需要 34 秒,总 VRAM 使用量为 7.6 GB,使用 FLUX Q2 和 T5-XXL Q3。

原文链接:How to Run FLUX GGUF Files with ComfyUI

汇智网翻译整理,转载请标明出处