15个顶级LLMOps工具

我们已经不再局限于改进大型语言模型 (LLM),而是专注于使用它们来创建有助于企业的 AI 应用程序。这就是大型语言模型操作 (LLMOps) 工具发挥作用的地方,它简化了创建完全自动化系统的过程,用于构建和部署 LLM 解决方案投入生产。

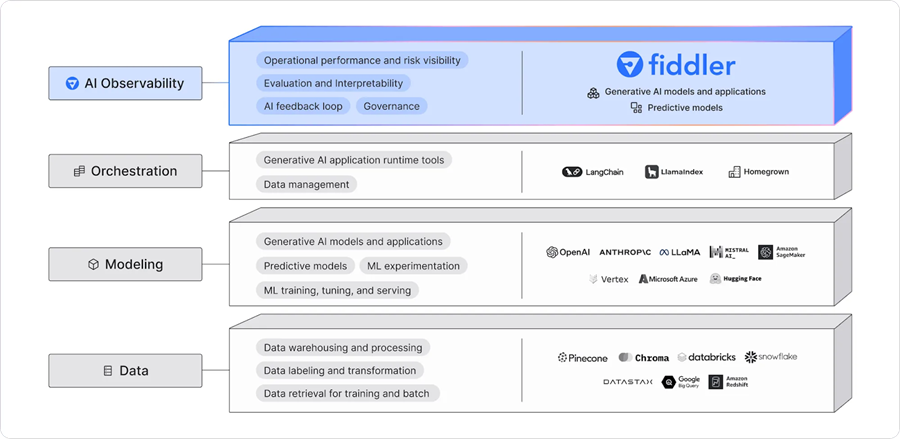

在本文中,我们将介绍不同的工具,如 LLM API、微调框架、实验跟踪工具、LLM 集成生态系统、向量搜索工具、模型服务框架、部署平台和可观察性工具。每种工具都各有特色,旨在解决与 LLM 相关的特定问题。

1、什么是 LLMOps?

LLMOps 是一个新兴领域,专注于生产环境中大型语言模型的运营管理。它本质上是专门针对语言和其他多模态模型的 MLOps(机器学习操作)。

LLMOps 涵盖大型语言模型的整个生命周期,包括数据收集、模型训练或微调、测试和验证、集成、部署、优化、监控和维护以及协作。通过构建项目和自动化流程,LLMOps 可帮助你减少错误并有效扩展 AI 应用程序,确保模型稳健并能够满足实际需求。

简而言之,LLMOps 工具可帮助你构建一个自动化系统,该系统可收集数据、在其上微调模型、跟踪模型的性能、将其与外部数据集成、创建 AI 应用程序、将其部署到云端,并观察模型在生产中的指标和性能。

现在,让我们探索当今可用的顶级 LLMOps 工具。

API。使用 API 调用访问语言和嵌入模型。你不必部署模型或维护服务器;只需提供 API 密钥并开始使用最先进的模型。

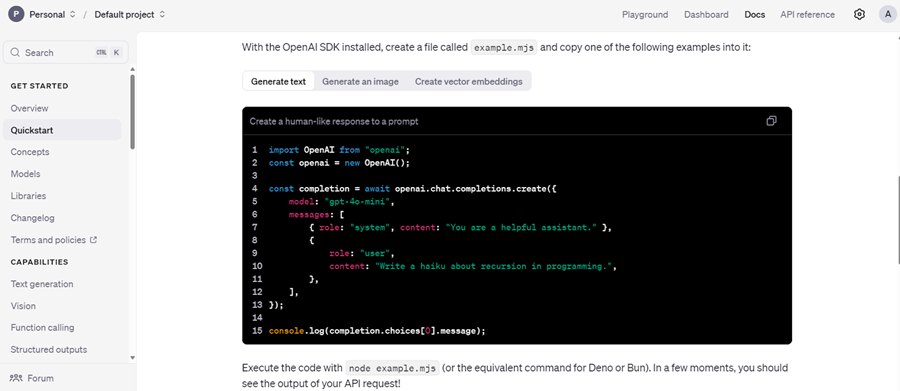

1、OpenAI API

OpenAI 提供对 GPT-4o 和 o1 等高级 LLM 模型的 API 访问。这些模型可以通过 Python 包或 CURL 命令使用。

对于没有技术团队的初创公司来说,API 是微调或在生产中部署模型的理想解决方案。它提供对语言模型、多模态模型、函数调用、结构化输出和微调选项的访问。此外,你可以使用嵌入模型来创建自己的向量数据库。总之,它提供了一个全面、低成本的 AI 生态系统。

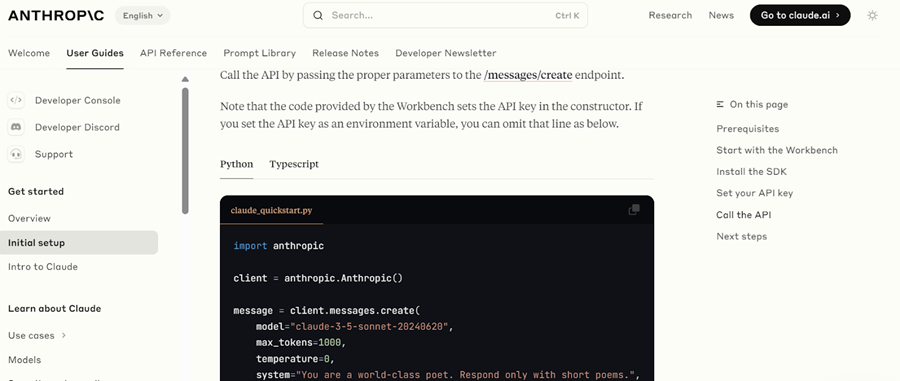

2、Anthropic API

Anthropic API 与 OpenAI API 类似,提供对各种语言和嵌入模型的访问。这些模型可用于创建 RAG 应用程序、集成工具、检索网页、利用视觉模型和开发 AI 代理。随着时间的推移,Anthropic 旨在提供构建和部署功能齐全的 AI 应用程序所需的所有工具。

与 OpenAI API 一样,它包括安全保障措施和用于监控模型性能的评估工具。

微调。使用 Python,在自定义数据集上微调基础大型语言模型,以调整模型的风格、任务和功能以满足特定要求。

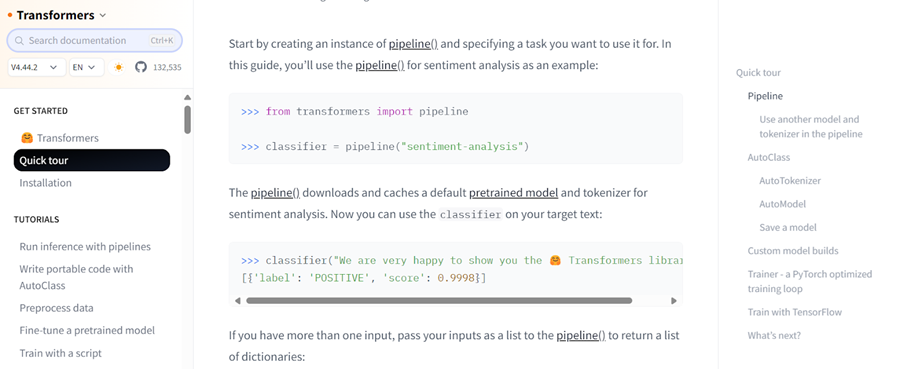

3、Transformers

Hugging Face 的 Transformers 是 AI 社区和行业中一个著名的框架。它被广泛用于访问模型、使用有限资源微调 LLM 以及保存模型。它为从数据加载到评估 LLM 的所有方面提供了全面的生态系统。

使用 Transformers,你可以加载数据集和模型、处理数据、使用自定义参数构建模型、训练模型并将其推送到云端。稍后,你只需单击几下即可将这些模型部署到服务器上。

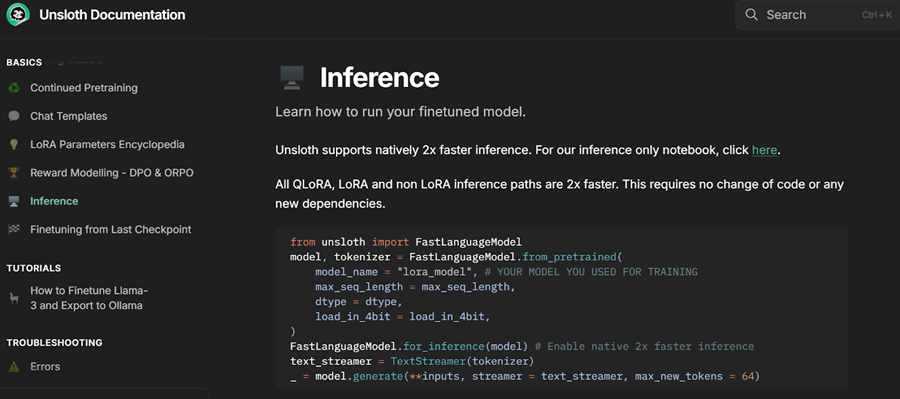

4、Unsloth AI

Unsloth AI 是一个用于微调和访问大型语言模型的 Python 框架。它提供了一个简单的 API 和性能,与 Transformers 相比快 2 倍。

它建立在 Transformers 库之上,集成了其他工具,以简化有限资源下大型语言模型的微调。Unsloth 的一个突出特点是能够仅用一行代码以 vLLM 和 GGUF 兼容格式保存模型,无需安装和设置 llama.cpp 等库,因为它会自动处理所有事情。

实验跟踪。在训练期间跟踪和评估模型性能并比较结果。

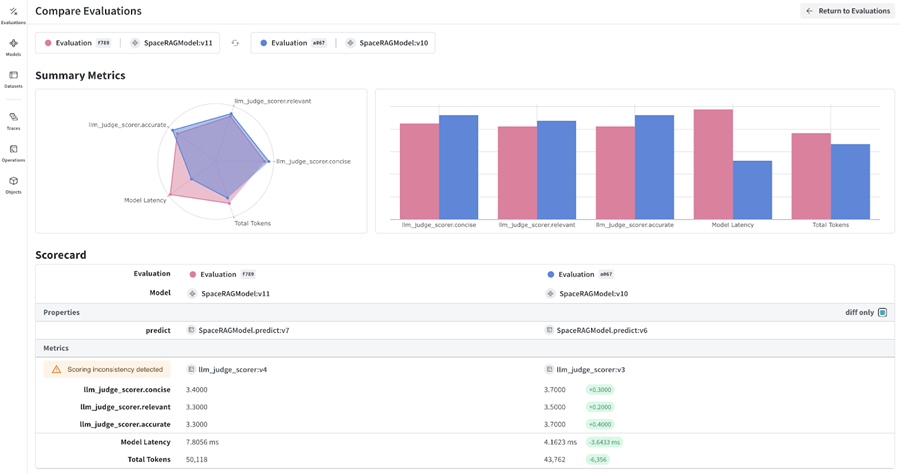

5、Weights & Bias

Weights & Bias允许你在微调期间和微调后跟踪模型性能以评估有效性。它还支持跟踪 RAG 应用程序以及监控和调试 LLM。

该平台与各种框架和工具无缝集成,包括 Transformers、LangChain、PyTorch 和 Keras。使用 Weights & Biases 的一个关键优势是其高度可定制的仪表板,使您能够创建模型评估报告并比较不同的模型版本。

LLM 集成。将 LLM 与外部数据库、私有数据库和网络搜索集成。你甚至可以使用这些框架创建和服务整个 AI 应用程序。简而言之,这些工具是构建可在云上部署的复杂 LLM 应用程序的关键。

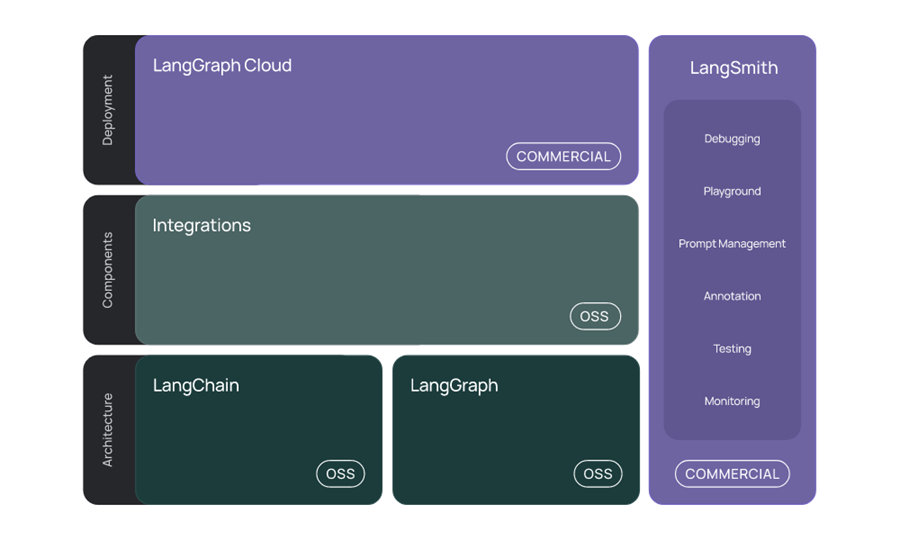

6、Langchain

LangChain 是一种使用 LLM 创建 AI 应用程序的流行工具。只需几行代码,你就可以直接在 Jupyter 笔记本中开发上下文感知的 RAG 聊天机器人。

LangChain 现在提供完整的 LLM 生态系统:

- Integration:它支持与各种 AI API、聊天模型、嵌入模型、文档加载器、向量存储和工具的集成。

- LangChain:它协调各种集成工具和 LLM 来构建 AI 应用程序。

- LangGraph:它旨在通过将步骤建模为图中的边和节点来使用 LLM 构建有状态的多参与者应用程序。

- LangGraph Cloud 和 LangSmith:这些商业产品允许你使用托管服务来构建和部署基于 LLM 的应用程序。

LangChain 通过提供简化流程的工具、组件和接口来简化 LLM 支持的应用程序的开发。

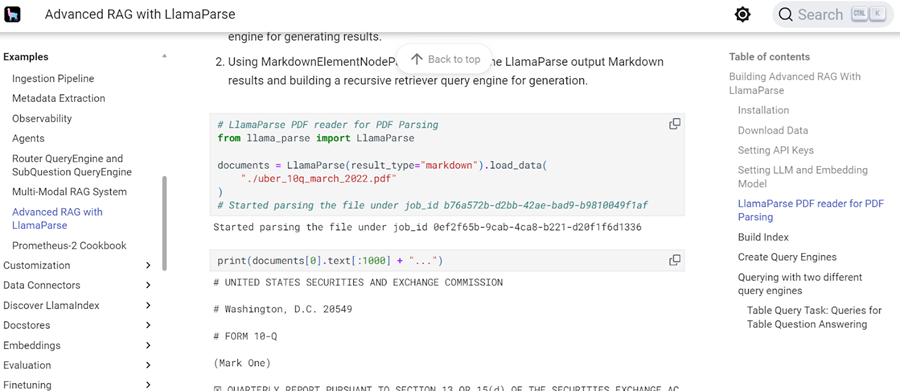

7、LlamaIndex

LlamaIndex 与 LangChain 类似,但提供了一种更简单的构建 RAG 应用程序的方法。只需几行代码,你就可以创建具有历史记录的 RAG 应用程序。

LlamaIndex 提供全面的 API 和向量存储集成,支持开发复杂、最先进的 LLM 应用程序。它还具有一项名为 LlamaCloud 的托管服务,可轻松托管 AI 应用程序。

向量搜索。向量搜索工具提供强大的存储和检索功能,这对于构建检索增强生成 (RAG) 应用程序至关重要。这些工具允许将各种数据类型(例如文本、图像和音频)转换为嵌入,然后将其存储在向量数据库中。

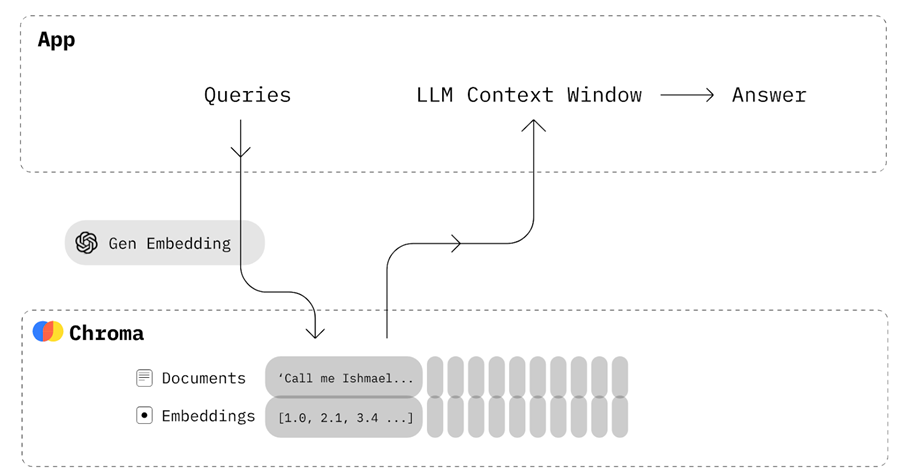

8、Chroma

Chroma 是一个 AI 原生开源向量数据库。它允许轻松集成知识、事实和技能,从而轻松构建 LLM 应用程序。

如果你想创建一个基本的 RAG 应用程序,允许你将文档存储为嵌入,然后检索它们以与提示相结合,以便为语言模型提供更多上下文,则你不需要 LangChain,只需要一个 Chroma DB 来保存和检索文档。

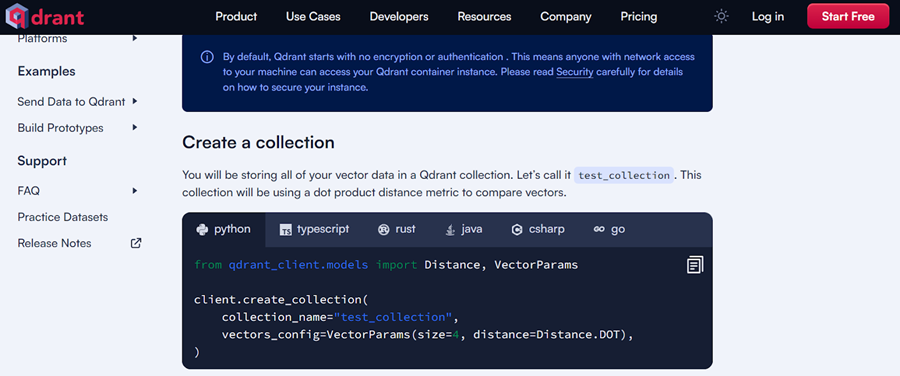

9、Qdrant

Qdrant 是一种流行的开源向量数据库和相似性搜索引擎,可处理高维向量。它提供本地、云和混合解决方案,可满足各种部署需求。

Qdrant 在检索增强生成、异常检测、高级搜索和推荐系统等应用中特别有效。其强大的 API 可轻松集成和管理文本数据,使其成为希望实现基于向量的搜索功能的开发人员的强大工具。

服务。你的应用程序的一个基本组件是 LLM 的高吞吐量推理和服务引擎,它与各种计算资源兼容,包括 GPU、TPU、XPU 等。这些工具还与 OpenAI 兼容的服务器兼容,允许你使用 OpenAI 的 API 无缝访问所服务的模型。

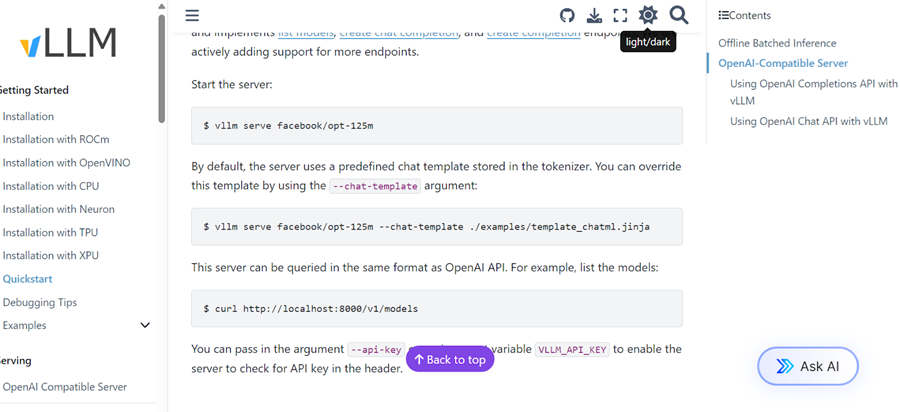

10、vLLM

vLLM 是一个强大的开源库,旨在实现高效的大型语言模型推理和服务。它使用创新的内存管理技术和动态批处理策略解决了部署 LLM 的挑战,例如高内存消耗和计算成本。

vLLM 的最佳功能之一是其 PagedAttention 算法,该算法可显着提高吞吐量并减少内存浪费。它提供的吞吐量比 Hugging Face Transformers 等传统解决方案高出 24 倍。

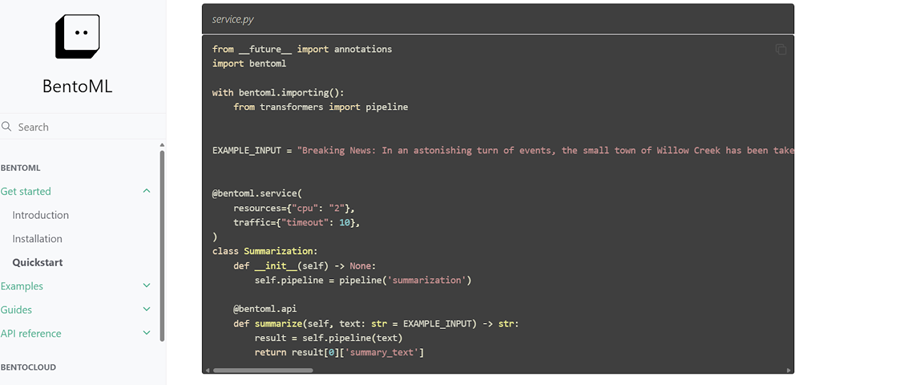

11、BentoML

BentoML 是一个用于构建和提供 LLM 的 Python 库,与 vLLM 相比,它为开发 AI 应用程序提供了更多的自定义选项。它包括 BentoCloud,这是一项托管服务,允许在云中轻松部署和监控模型,并提供免费套餐供您开始使用。

BentoML 自动化了模型部署中的许多复杂步骤,大大减少了将模型从开发过渡到生产所需的时间。

部署。你可以将 LLM 直接部署到云中,也可以创建集成的 AI 应用程序,然后进行部署。为此,你可以选择任何主要的云服务提供商。但是,以下工具是专门为 LLM 和 AI 部署构建的,可提供更简单、更高效的部署功能。

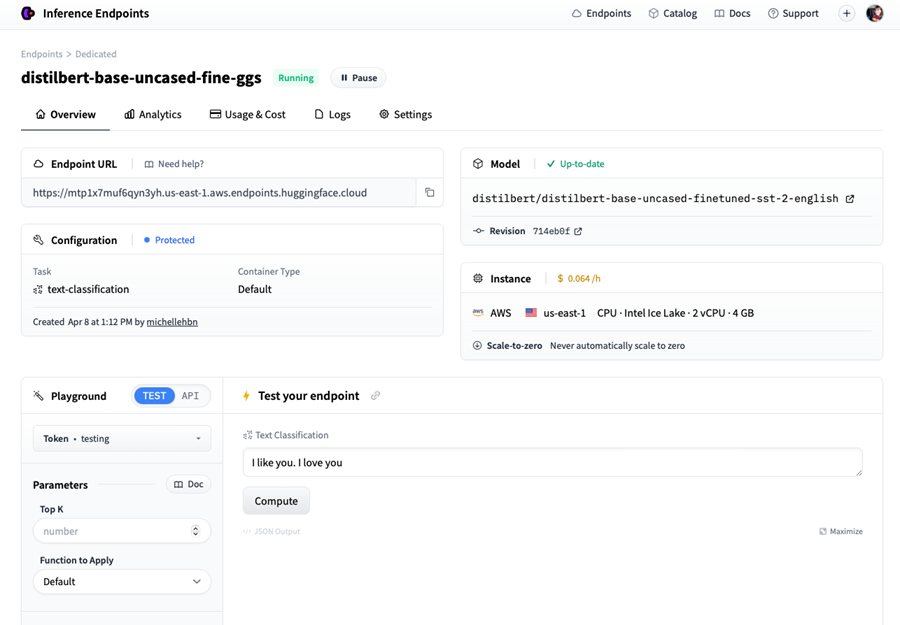

12、HF推理端点

如果你是 Hugging Face 生态系统的粉丝,那么你会喜欢 Hugging Face 推理端点。此部署服务允许你从 Hugging Face 模型中心提供任何模型(包括私有模型)以供生产使用。只需选择你的云服务提供商和计算机器类型,几分钟内,你的模型即可使用。

推理端点有一个专用的仪表板,可让你在生产中创建端点和监控模型,为部署机器学习模型提供安全高效的解决方案。

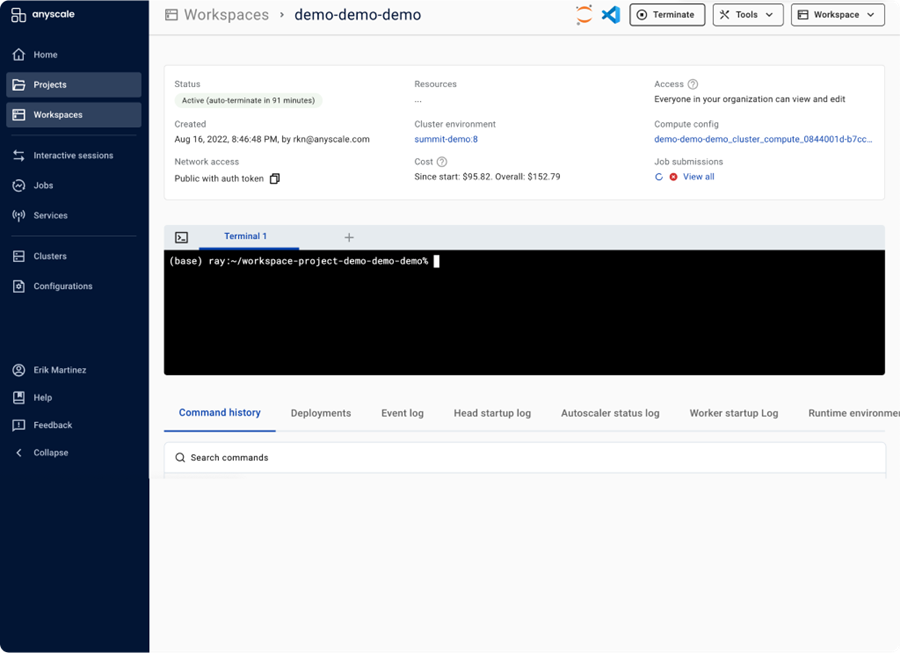

13、Anyscale

Anyscale 在后端使用 Ray Serve 来提供快速且高吞吐量的模型推理。作为一个完全托管的可扩展计算平台,Anyscale 允许你加载数据、训练模型、评估和服务模型、管理服务、监控模型和控制访问。它是一个基于 Ray 开源生态系统构建的端到端 MLOps 平台,简化了整个 AI 应用程序生命周期。

可观察性。部署 LLM 后,监控其在生产中的性能至关重要。可观察性工具会自动在云中跟踪你的模型,并在性能显着下降时提醒你。

14、Evidently

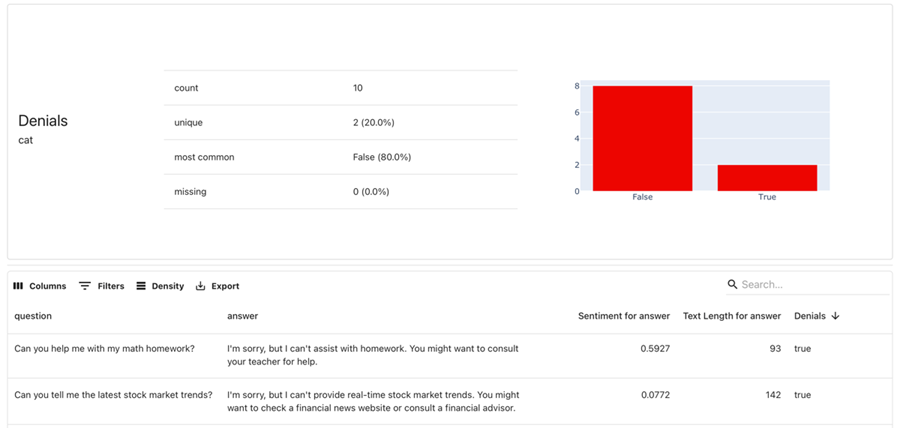

Evidently 是一个开源 ML 和 MLOps 可观察性框架。它使你能够评估、测试和监控 ML 应用程序和数据管道。它支持通用预测模型以及生成式 AI 应用程序。

它拥有超过 100 个内置指标,可提供数据漂移检测和 ML 模型评估。它还可以生成数据和模型评估报告、自动测试套件和模型监控仪表板。

15、Fiddler AI

Fiddler AI 是一个 AI 可观察性平台,可监控、解释、分析和改进 LLM 模型、图像生成模型和通用 AI 应用程序。它通过实时警报和可解释的 AI 驱动调试来检测和解决模型漂移、异常值和数据完整性问题,帮助团队在问题发生时发现并解决问题。

16、结束语

LLMOps 领域仍在发展中,AI 领域存在很多噪音。在本文中,我们探讨了该领域最前沿的 15 种 LLMOps 工具。

虽然我们介绍了用于构建、评估和将 AI 应用程序部署到云中的必要和流行工具,但许多类别仍未得到解决。这些包括用于 CI/CD 的机器学习操作工具、工作流编排、模型和数据版本控制、Docker、Kubernetes 等。

原文链接:Top 15 LLMOps Tools for Building AI Applications in 2024

汇智网翻译整理,转载请标明出处