21个值得关注的小型语言模型

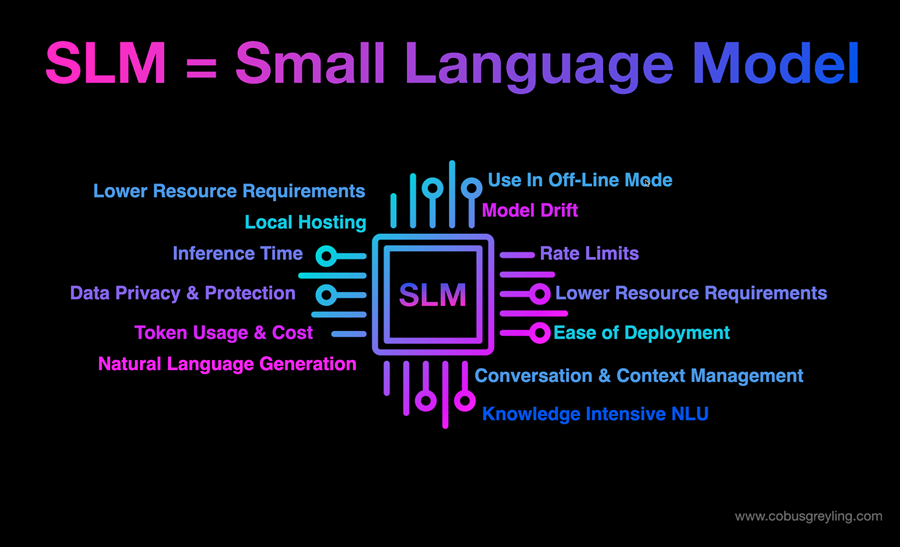

小型语言模型 (SLM)更紧凑高效,提供了重要的功能,越来越多地被各个行业采用。

近年来,人工智能取得了显著的进步,GPT-4 等大型语言模型成为头条新闻。然而,一种新的趋势正在出现:小型语言模型 (SLM)。这些模型虽然更紧凑、更高效,但提供了重要的功能,并越来越多地被各个行业采用。下面介绍 21 种正在塑造人工智能未来的小型语言模型。

1、DistilBERT

DistilBERT 是 BERT 的更小、更快、更便宜的版本。它保留了 BERT 97% 的语言理解能力,同时速度提高了 60%,参数减少了 40%。

DistilBERT 模型是在博客文章《更小、更快、更便宜、更轻:介绍 BERT 的精简版 DistilBERT》和论文《DistilBERT, 更小、更快、更便宜、更轻》中提出的,它是一种小型、快速、便宜且轻量的 Transformer 模型,通过精简 BERT 基础进行训练。与 google-bert/bert-base-uncased 相比,它的参数减少了 40%,运行速度提高了 60%,同时在 GLUE 语言理解基准上保持了 BERT 95% 以上的性能。

DistilBERT的主要特点:

- 6 层,而 BERT 有 12 层

- 6600 万个参数

- 在自然语言理解任务上表现出色

2、ALBERT

ALBERT (A Lite BERT) 通过使用分解嵌入参数化和跨层参数共享来减少内存消耗并提高训练速度。

ALBERT 模型由 Zhenzhong Lan、Mingda Chen、Sebastian Goodman、Kevin Gimpel、Piyush Sharma 和 Radu Soricut 在 ALBERT:用于语言表征自监督学习的精简版 BERT 中提出。它提出了两种参数减少技术来降低内存消耗并提高 BERT 的训练速度:

- 将嵌入矩阵拆分为两个较小的矩阵。

- 使用重复层在组间拆分。

ALBERT的主要特点:

- 显著减少参数

- 在基准测试中保持高性能

- 训练和推理效率高

3、TinyBERT

TinyBERT 专为资源受限的环境而设计,通过知识提炼技术提供较小版本的 BERT。

TinyBERT的主要特点:

- 4 或 6 个转换器层

- 在各种 NLP 任务上保持高精度

- 推理时间更快

4、MobileBERT

MobileBERT 专门针对移动设备进行了优化,平衡了效率和性能。

MobileBERT的主要特点:

- 2500 万个参数

- 专为设备上的 AI 应用而设计

- 在标准基准测试中具有竞争力

5、MiniLM

MiniLM 提供超紧凑模型,在许多 NLP 任务上具有最先进的性能。

MiniLM的主要特点:

- 6 个转换器层

- 2200 万个参数

- 高效的提炼方法

6、ELECTRA-Small

ELECTRA-Small 使用生成器-鉴别器设置进行预训练,使其高效而强大。

ELECTRA-Small的主要特点:

- 在多个基准测试中优于 BERT

- 1400 万个参数

- 训练时间更快

7、BERT-PKD

BERT-PKD 应用耐心的知识提炼将知识从较大的 BERT 模型转移到较小的模型。

BERT-PKD的主要特点:

- 渐进式提炼技术

- 以更少的参数保持高性能

- 适合在低资源环境中部署

8、SqueezeBERT

SqueezeBERT 针对移动和边缘设备进行了优化,将效率与性能相结合。

SqueezeBERT的主要特点:

- 轻量级模型架构

- 在 NLP 任务上具有竞争力的准确性

- 专为快速推理而设计

9、TinyGPT

作为 GPT 的较小版本,TinyGPT 为对话式 AI 提供了强大的性能。

TinyGPT的主要特点:

- 减少参数数量

- 适用于对话系统

- 保持一致性和上下文理解

10、AdaNet

AdaNet 利用自适应提炼来动态调整模型复杂性。

AdaNet的主要特点:

- 自适应扩展模型复杂性

- 高效且性能卓越

- 适用于各种 NLP 应用

11、Funnel Transformer

Funnel Transformer 将长序列压缩为较短的表示,使其能够高效地完成需要较长上下文的任务。

Funnel Transformer的主要特点:

- 减少序列长度

- 在长上下文任务上保持性能

- 适用于文档级理解

12、Q8BERT

Q8BERT (量化 8 位 BERT) 专注于通过量化技术减小模型大小。

Q8BERT的主要特点:

- 8 位精度

- 显著减小模型大小

- 在各种 NLP 任务上保持性能

13、Lite Transformer

Lite Transformer 模型在保持高精度的同时减少了计算负荷。

Lite Transformer的主要特点:

- 轻量级架构

- 适用于实时应用

- 适用于移动和边缘部署

14、FastBERT

FastBERT 引入动态推理来平衡精度和速度。

FastBERT的主要特点:

- 可调节推理速度

- 保持竞争性准确性

- 适用于时间敏感型应用

15、TernaryBERT

TernaryBERT 使用三元量化来最小化模型的占用空间。

TernaryBERT的主要特点:

- 三元精度(三个值)

- 显著减小尺寸

- 适用于资源极其受限的环境

16、LightBERT

LightBERT 旨在在模型大小和性能之间取得平衡。

LightBERT的主要特点:

- 紧凑架构

- 标准基准测试中的高精度

- 部署效率高

17、NanoBERT

NanoBERT 提供纳米级版本的 BERT,非常适合 tinyML 应用。

NanoBERT的主要特点:

- 超紧凑尺寸

- 在低功耗设备上高效推理

- 适用于物联网应用

18、Distilled GPT-2

Distilled GPT-2是GPT-2 的精简版本,提供更小但功能强大的对话模型。

Distilled GPT-2的主要特点:

- 参数比 GPT-2 少

- 保持对话的连贯性

- 适用于对话系统

19、PruneBERT

PruneBERT 利用修剪技术来减小模型大小,同时保持性能。

PruneBERT的主要特点:

- 修剪后的架构

- 保持高精度

- 适用于资源有限的场景

21、BERT-Small

BERT-Small 提供原始 BERT 的较小版本,以实现高效部署。

BERT-Small的主要特点:

- 紧凑高效

- 在 NLU 任务上具有高性能

- 适用于实时应用

21、Reformer

Reformer 使用局部敏感哈希和可逆层可有效处理长序列。

Reformer的主要特点:

- 高效内存使用

- 可扩展到长序列

- 保持高性能

22、结束语

小型语言模型正在通过为广泛的应用提供高效、可扩展和高性能的解决方案来改变人工智能的格局。 它们体积小巧,资源需求低,非常适合在计算能力和内存有限的环境中部署。 随着技术的不断发展,这些模型将在让所有人都能使用高级人工智能方面发挥越来越重要的作用。

原文链接:21 Small Language Models That Are Revolutionizing AI

汇智网翻译整理,转载请标明出处