8个领先的大模型API提供商

API使大型语言模型 (LLM) 能够无缝集成到不同的软件生态系统中。本文将探讨用于访问不同 LLM 的8个最领先的 API提供平台。

在当今的商业应用中,API(应用程序编程接口)正在改变我们集成和利用 AI 功能的方式。它们充当着重要的桥梁,使大型语言模型 (LLM) 能够无缝集成到不同的软件生态系统中。

通过促进高效的数据交换和功能共享,开源和闭源 LLM 的 API 允许应用程序利用 LLM 的强大功能,本文将探讨用于访问不同 LLM 的8个最领先的 API提供平台。

什么是 API?

API 是数字连接器,使不同的软件应用程序能够通信和共享数据。它们充当中介,促进各种程序和系统之间的无缝交互。

API 在我们的日常生活中随处可见——无论是使用拼车应用程序、进行移动支付还是远程调整智能家居设备。当你与这些应用程序交互时,它们使用 API 与服务器交换信息、处理请求并在你的设备上以用户友好的格式提供结果。

为什么我们需要 LLM API?

API 为开发人员提供了一个标准化的界面,通过该界面,他们可以将大型语言模型合并到他们的程序中。除了简化开发程序外,这种标准化还保证了对最新模型增强功能的访问。它还允许有效地扩展工作并为各种任务选择合适的 LLM。此外,由于 API 提供的灵活性,LLM 的响应可以根据特定需求进行定制,从而提高其适应性和对各种场景的适用性。

API 提供商是经济高效的云平台,旨在高效部署机器学习模型。他们专注于通过用户友好的 API、强大的扩展能力和有竞争力的价格实现无需基础设施即可访问高级 AI,使各种规模的企业都可以使用 AI。在本节中,我们将探讨一些最突出的 API 提供商。

1、OpenAI

OpenAI 是一家 AI 研究和部署公司,于 2022 年首次推出 chatGPT。OpenAI API 定价基于所使用的模型和处理的 token 数量。对于 GPT-4,根据处理需求(8k 或 32k 上下文窗口)存在不同的层级,而 GPT-3.5 和嵌入的成本较低。定价随使用量而变化,确保不同应用程序的灵活性。

2、Anthropic

Anthropic 的 API 提供对 Claude 模型系列的访问。它提供针对速度、吞吐量和性能优化的各种层级,涵盖编码、生产力和客户支持等任务。其灵活的基于使用量的定价适合各种工作负载,而自定义支持选项使其适用于企业使用。

3、Google

Google Cloud Console 上的 API 库提供了将 Firebase 服务集成到应用程序中的工具。它涵盖身份验证、数据库、机器学习和分析。其模块化 API 设置允许开发人员选择适合特定应用程序需求的服务,使其可扩展且高效地进行应用程序开发。

4、DeepInfra

DeepInfra 提供了一个经济高效的云平台,用于运行各种管理通过一个简单的 API,DeepInfra 即可支持多种学习模型,包括各种 LLM。它处理基础设施、扩展和监控,让用户专注于他们的应用程序。DeepInfra 采用即用即付定价并支持多种接口,为其他 API 提供商提供了经济实惠的替代方案。

5、Deepseek

DeepSeek 为机器学习提供经济高效的云平台,广泛支持 LLM。它具有 128K 上下文限制,可通过简单的 API 访问。它以每百万输入令牌 0.14 美元和每百万输出令牌 0.28 美元的价格提供有竞争力的价格,专注于高效的扩展和监控。凭借其强大的架构,DeepSeek 使企业能够利用高性能模型,包括编码和推理功能,而无需管理内部基础设施。

6、Groq

AI 推理技术,包括其语言处理单元 (LPU),专为高速、节能的 AI 工作负载而设计。 Groq 为 AI 模型提供分级定价,包括高速令牌处理和语言生成、语音识别等任务的有竞争力的价格。选项范围从适用于一般应用的多功能模型到适用于企业客户的定制模型,确保为各种需求提供可扩展的解决方案。

7、Together AI

Together AI 提供了一个全面的平台,用于开发、微调和部署大规模生成式 AI 模型。它具有经济高效的 GPU 集群、自定义模型微调以及无服务器或专用推理选项。Together AI 专为高速、生产规模的模型训练而设计,具有灵活的部署,可根据特定业务需求量身定制。

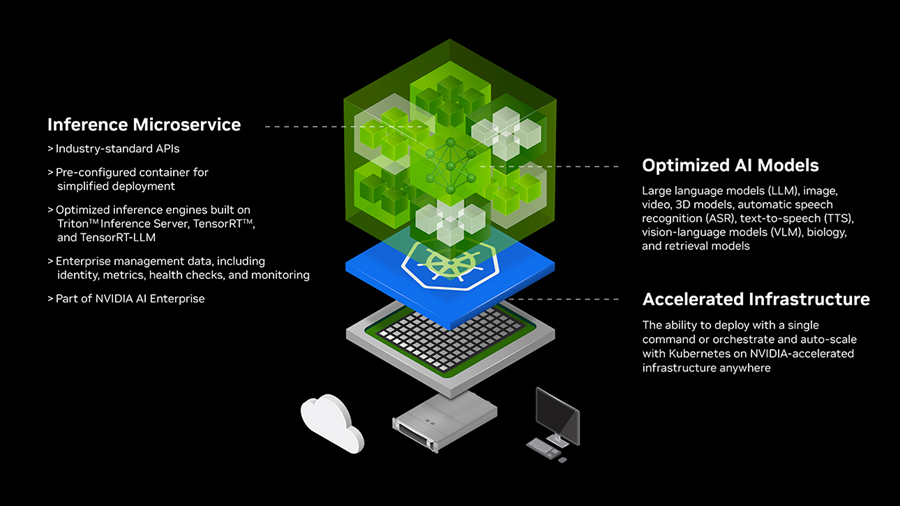

8、Nvidia

NVIDIA 是加速计算领域的领导者,专注于 AI、元宇宙技术和高性能图形。NVIDIA NIM(NVIDIA AI 微服务)是一套强大的容器化微服务,旨在实现跨不同环境的无缝 AI 模型部署。NIM 支持开源、NVIDIA 和自定义模型,同时优化每个设置的 GPU 性能和可观察性。

9、结束语

API 简化了将复杂功能集成到 LLM 应用程序中的过程,使开发人员能够轻松利用最先进的模型功能。这使他们能够标准化任务并有效扩展,无论是使用专有还是开源 LLM。

此处讨论的 API 提供了广泛的限制和用例生成,每个都有自己的定价和性能特征。这些信息将有助于在为你的项目选择 API 时做出明智的决策。

原文链接:8 Free and Paid APIs for Your LLM Applications

汇智网翻译整理,转载请标明出处