8个DeepSeek-R1私有化部署方案

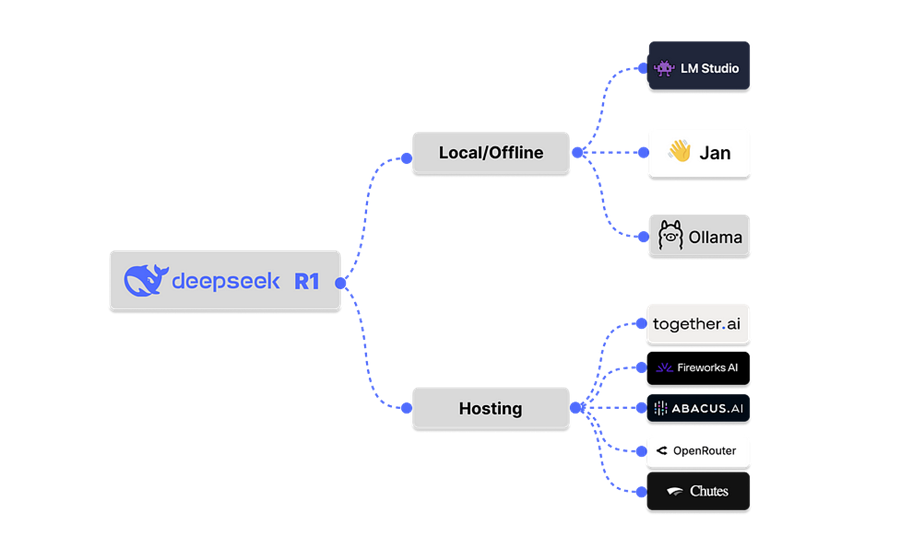

本文了解如何在本地和没有互联网的情况下运行DeepSeek R1推理模型,或者通过可信赖的托管服务来运行它。

许多人(尤其是开发人员)想要使用新的DeepSeek R1推理模型,但担心将数据发送给DeepSeek。阅读本文了解如何在本地和没有互联网的情况下运行DeepSeek R1推理模型,或者通过可信赖的托管服务来运行它。

Part 1

你可以在本地运行模型,因此你的私人数据会保留在您的机器上,不会传输到任何LLM托管提供商(如DeepSeek)。同样地,通过可信赖的托管服务,您的数据会被传输到第三方托管提供商而不是DeepSeek。

在本地/离线使用LMStudio、Ollama和Jan,或者通过Groq、Fireworks AI和Together AI等LLM服务端平台运行DeepSeek R1,有助于消除数据共享和隐私问题。

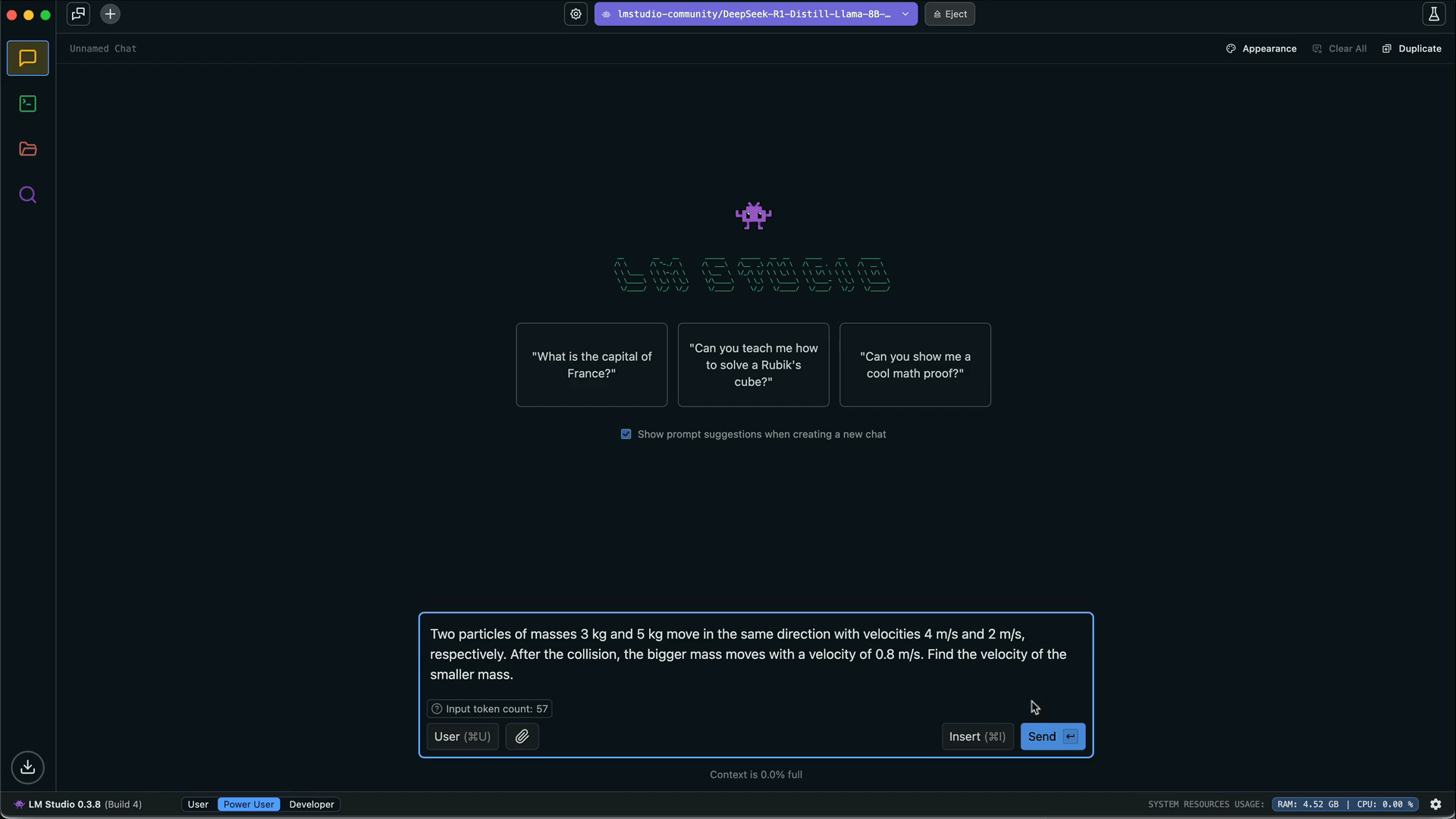

1、LMStudio

LMStudio提供可以离线运行的DeepSeek R1的蒸馏版本。首先,下载 LMStudio,启动它,然后点击左侧面板上的发现选项卡,下载、安装和运行任何蒸馏版本的R1。观看使用LMStudio在本地运行DeepSeek R1的YouTube视频以获取分步快速指南。

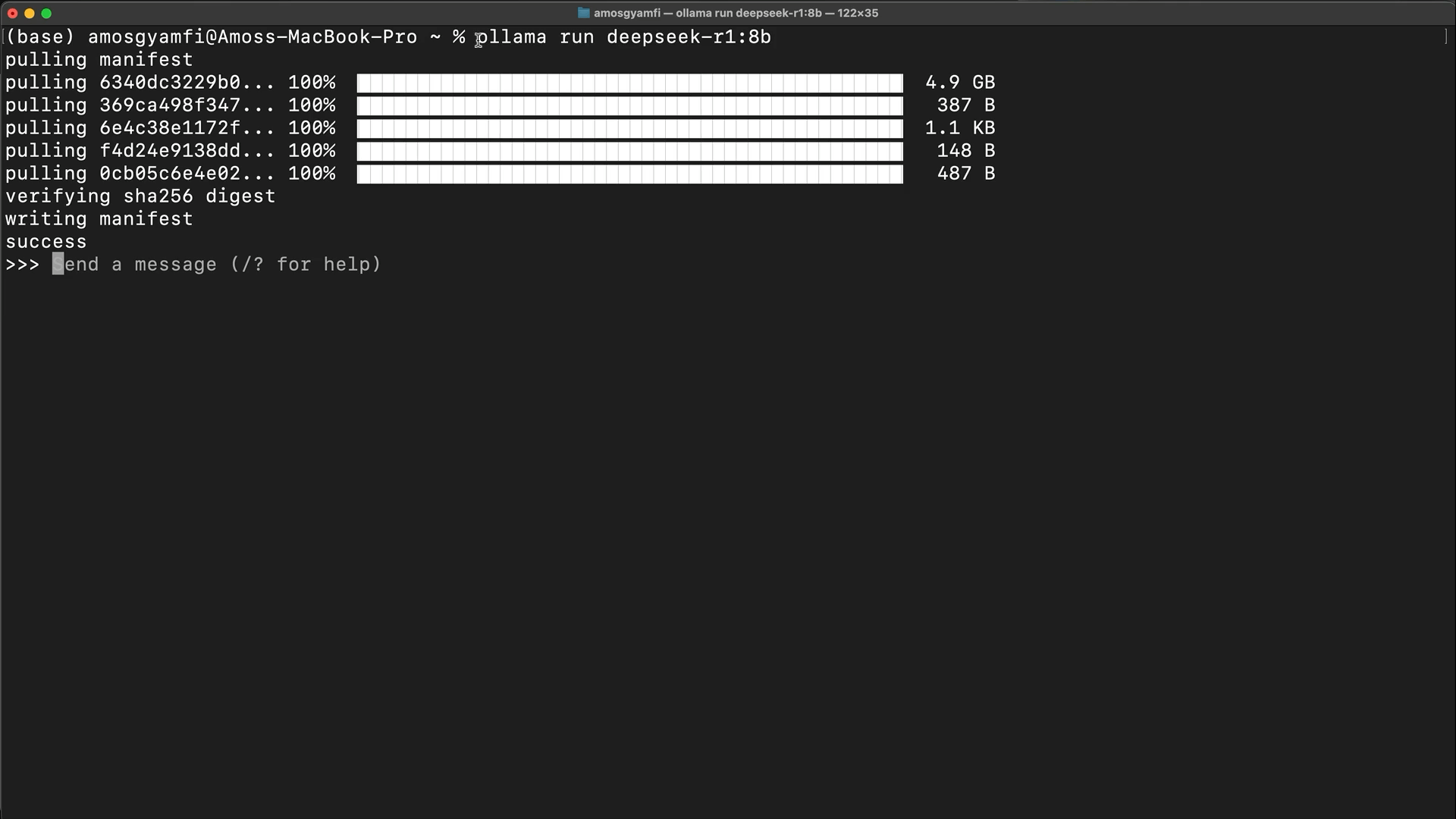

2、Ollama

使用Ollama,您可以使用单个命令在没有任何网络的情况下100%运行DeepSeek R1模型。首先,安装Ollama,然后运行以下命令以拉取并运行DeepSeek R1模型:

ollama run deepseek-r1

您还可以拉取并运行以下DeepSeek R1模型的蒸馏Qwen和Llama版本。

Qwen蒸馏DeepSeekR1模型

- DeepSeek-R1-Distill-Qwen-1.5B:

ollama run deepseek-r1:1.5b - DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1:7b - DeepSeek-R1-Distill-Qwen-14B:

ollama run deepseek-r1:14b - DeepSeek-R1-Distill-Qwen-32B:

ollama run deepseek-r1:32b

Llama蒸馏DeepSeekR1模型

- DeepSeek-R1-Distill-Llama-8B:

ollama run deepseek-r1:8b - DeepSeek-R1-Distill-Llama-70B:

ollama run deepseek-r1:70b

下面的预览展示了如何使用Ollama运行DeepSeek-R1-Distill-Llama-8B。

观看使用Ollama本地LLM工具运行DeepSeek R1的YouTube视频以获取快速演示。

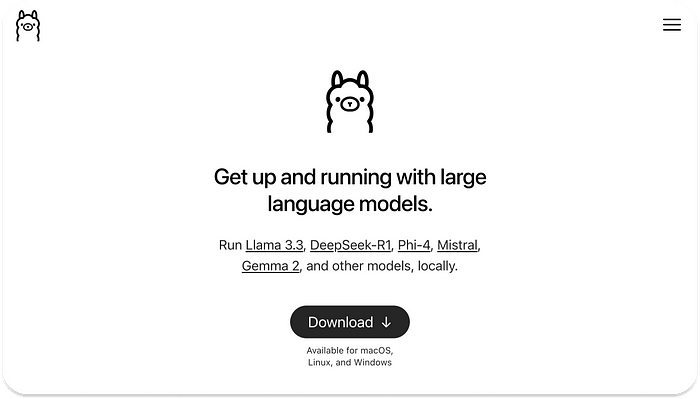

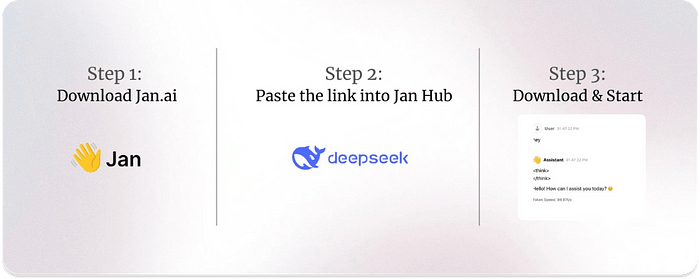

3、Jan:离线与DeepSeek R1聊天

Jan将其描述为一个开源的ChatGPT替代品。它是一个本地优先的LLM工具,可以100%离线运行DeepSeek R1模型。使用Jan运行DeepSeek R1仅需按照下图所示的三个步骤操作。

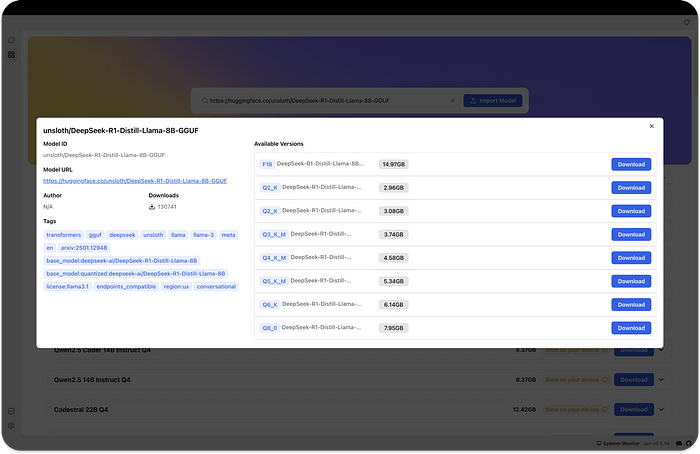

下载Jan并前往左侧面板上的Hub选项卡,搜索并下载来自Hugging Face的任何蒸馏R1 GGUF模型。

DeepSeek R1 Qwen蒸馏模型

- 1.5B: https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-1.5B-GGUF

- 7B: https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-7B-GGUF

- 14B: https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-14B-GGUF

- 32B: https://huggingface.co/bartowski/DeepSeek-R1-Distill-Qwen-32B-GGUF

DeepSeek R1 Llama蒸馏模型

- 8B: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Llama-8B-GGUF

- 70B: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Llama-70B-GGUF

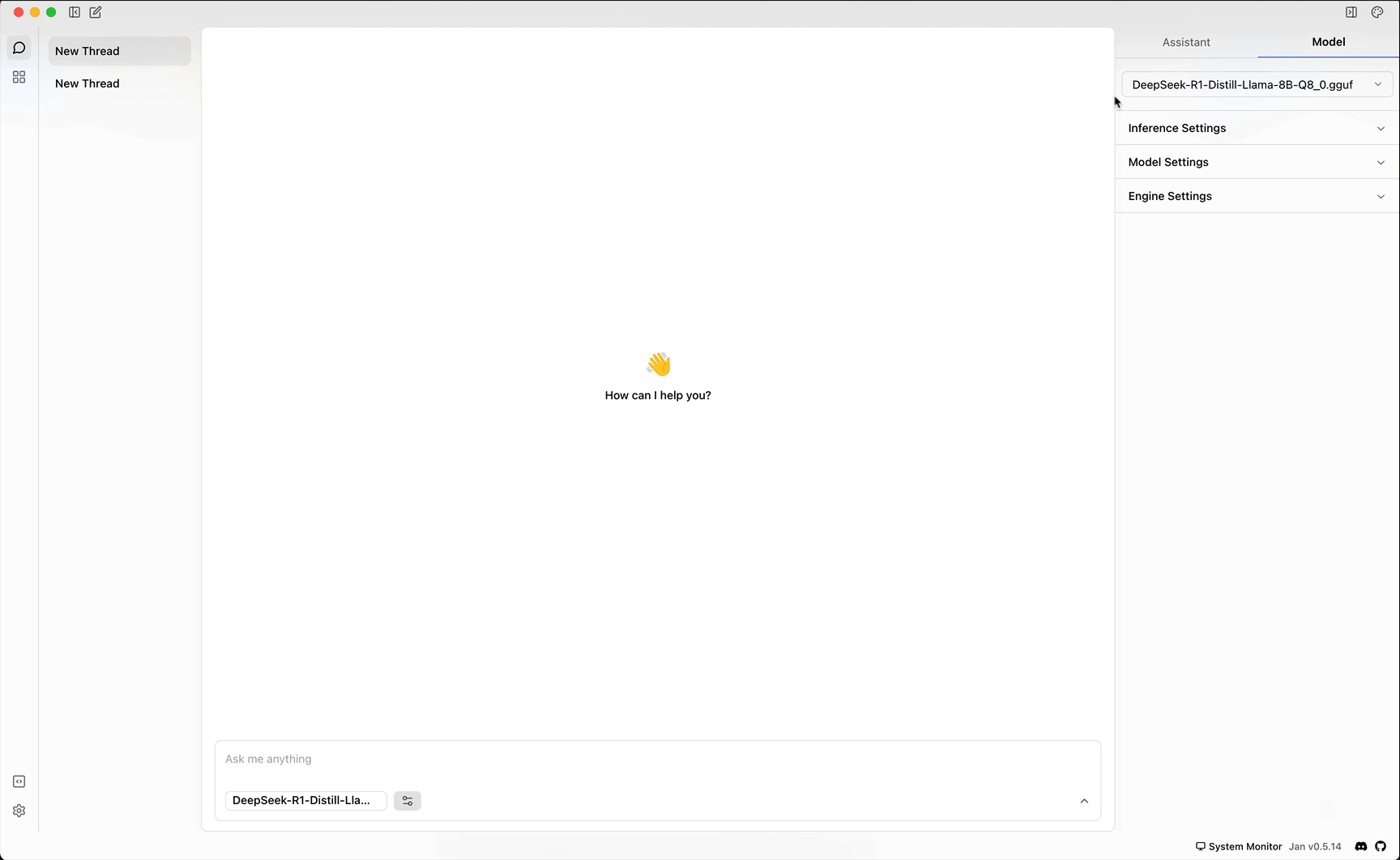

一旦您使用Jan下载了任何蒸馏的R1模型,您可以按如下所示运行它。

Part 2

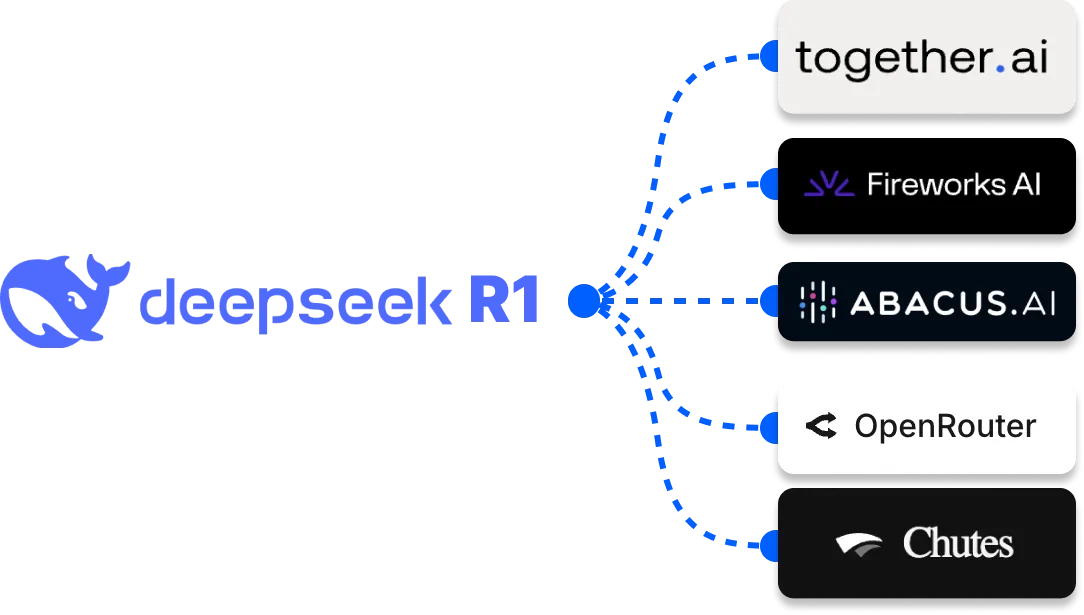

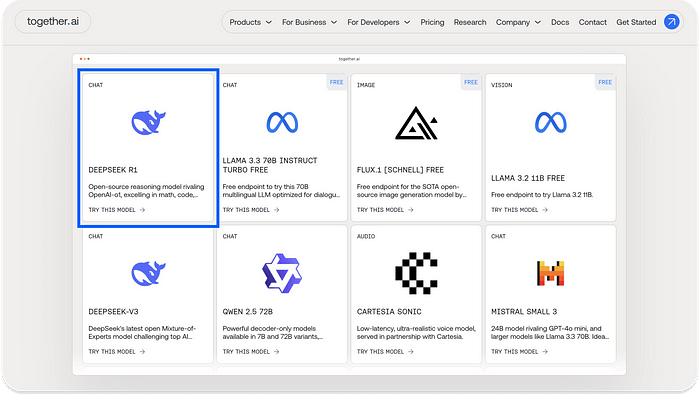

虽然DeepSeek R1模型最近才发布,但一些可信的LLM托管平台已经支持它。如果您不想使用上述列出的离线方法,可以从以下提供者之一访问该模型。这里可能缺少一些LLM托管平台。但是,以下是您可以访问DeepSeek R1模型及其蒸馏版本的主要平台。

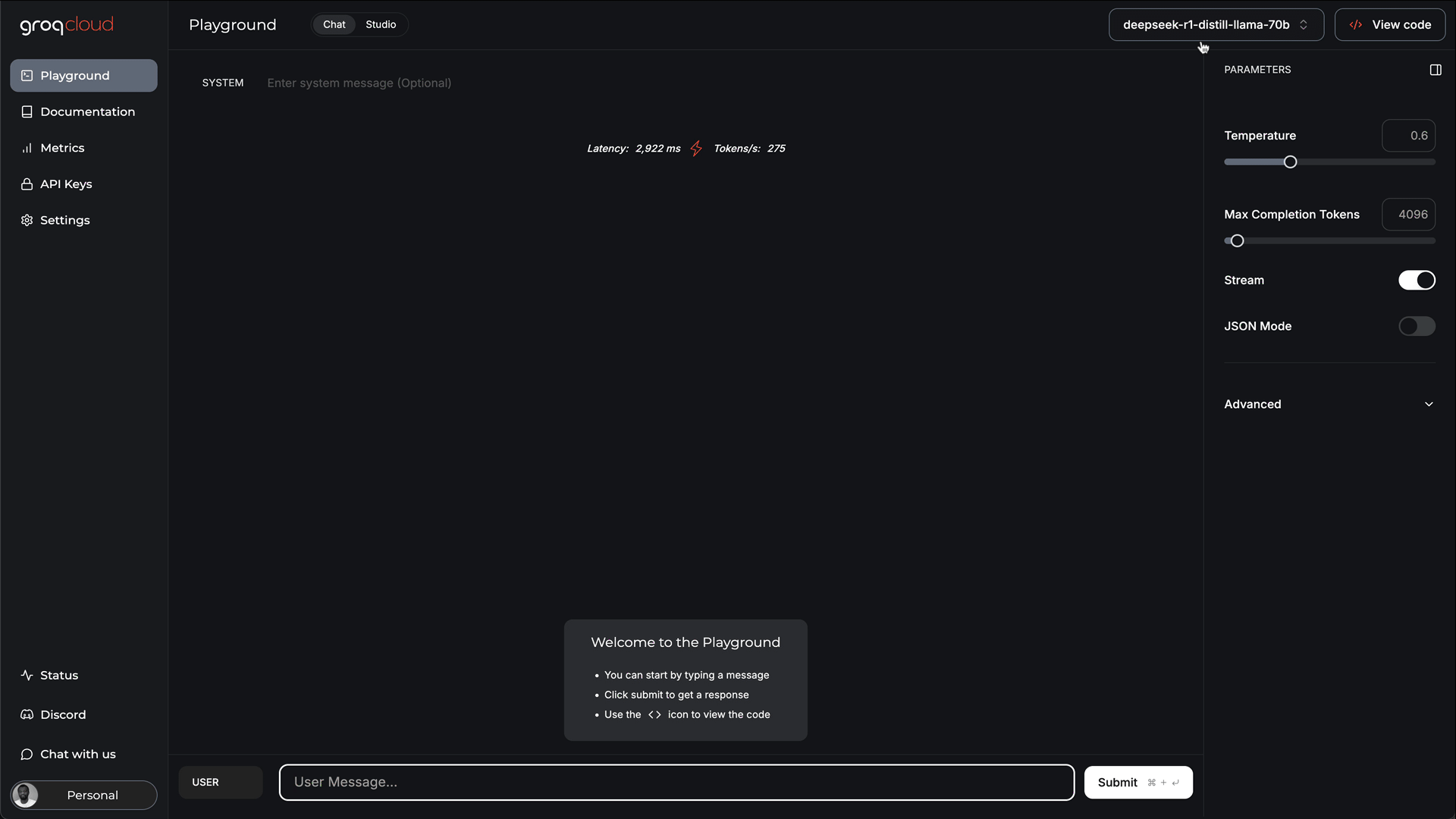

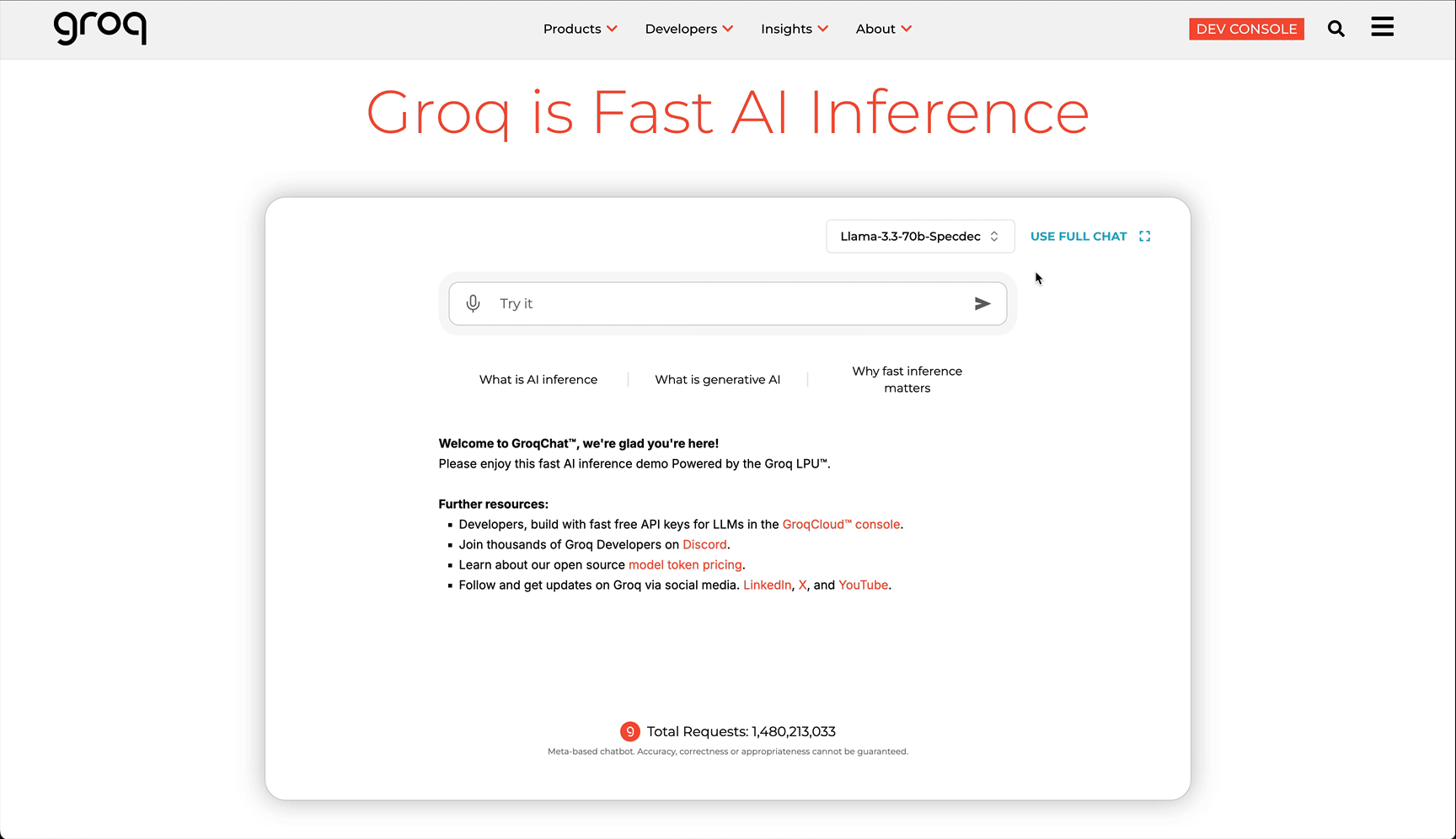

4、Groq

Groq支持DeepSeek-R1-Distill-Llama-70B版本。要使用它,请访问https://groq.com/并在首页直接运行模型。

或者,您可以通过点击主页右上角的Dev Console按钮来在Groq上运行R1模型,如下面的预览所示。

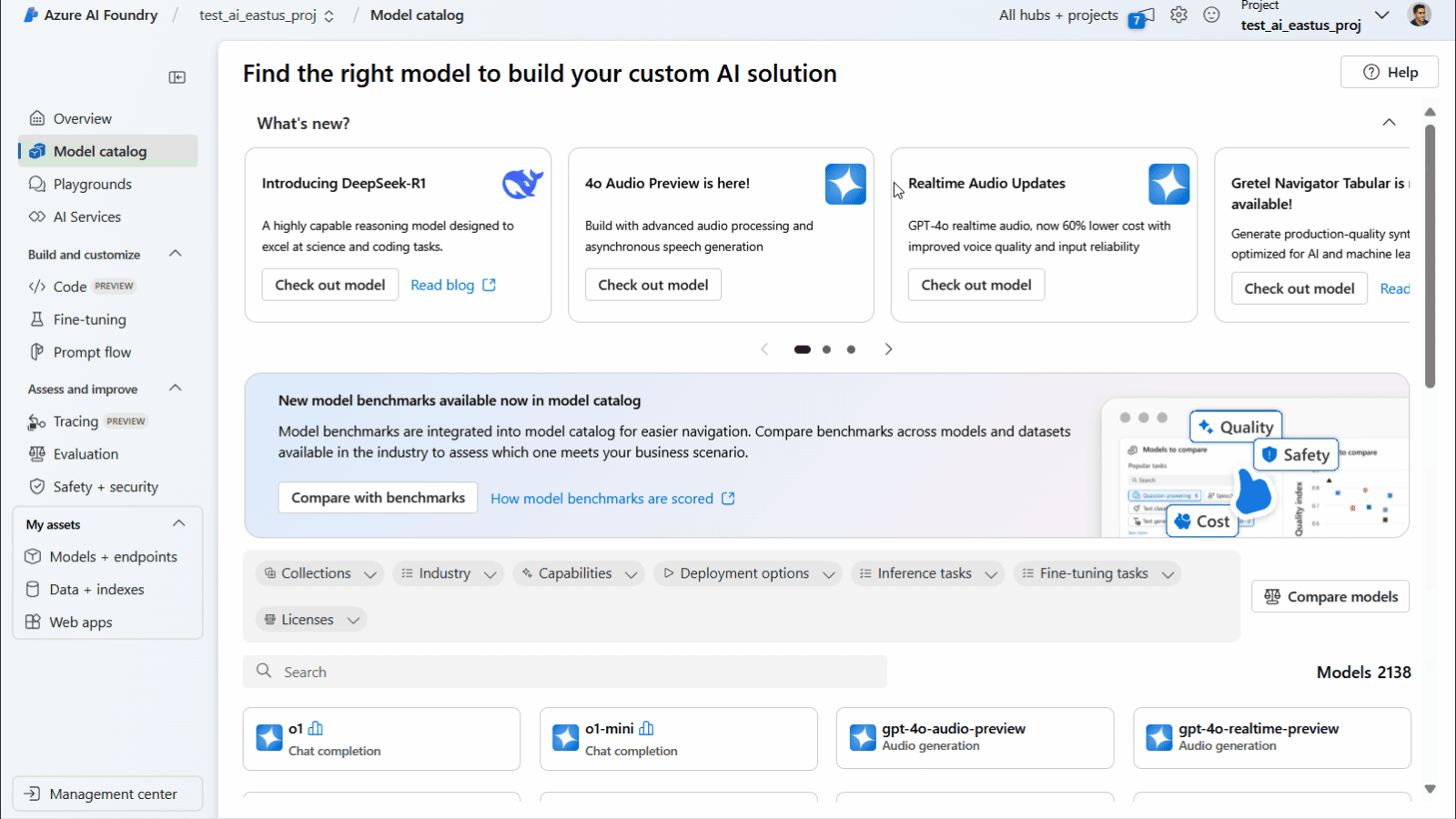

5、Azure AI Foundry

如上面的预览所示,您可以在Microsoft的Aure AI Foundry上访问DeepSeek R1的蒸馏版本。访问Azure AI Foundry网站以开始使用。

其他可以运行DeepSeek R1蒸馏模型的流行LLM托管平台包括以下链接。

- https://fireworks.ai/

- https://www.together.ai/

- https://openrouter.ai/

- https://chatllm.abacus.ai/

- https://chutes.ai/

6、DeepSeek R1和开源模型的未来

在本文中,你了解了如何使用本地优先的LLM工具(如LMStudio、Ollama和Jan)离线运行DeepSeek R1模型。你还了解了如何使用可扩展且企业级的LLM托管平台来运行该模型。DeepSeek R1模型是OpenAI o1模型的一个极好的替代品,能够推理完成高度需求和逻辑任务。

在撰写本文时,DeepSeek R1模型可在可靠的LLM托管平台如Azure AI Foundry和Groq上访问。这些平台确保其托管的语言模型的可靠性和安全性。在未来,我们预计会有更多公司和开源开发者复制DeepSeek R1模型并使其适用于不同的用例。此外,许多本地优先的LLM工具和托管服务可能会支持DeepSeek R1模型及其蒸馏版本。

原文链接:DeepSeek R1 — The Best Local LLM Tools To Run Offline

汇智网翻译整理,转载请标明出处