基于多模态嵌入的视觉搜索引擎

我编写了一个视觉搜索算法,它与段落中的上下文相匹配,从 100 个候选图像中选择正确的图像。

你可能曾经疯狂地在 Google 中输入关键词,比如“我在 Instagram 上看到的夹克,黑色皮革,也许是铆钉?”,并祈祷得到正确的结果,对吧?

甚至输入“古色古香的木雕古董椅”,希望找到与你脑海中的形象完全匹配的产品。

现在,有更好的方法:由多模态嵌入驱动的视觉搜索已经改变了我们与技术的互动方式。

它不只是查看图像或解析关键词——它还能理解上下文。这就像给互联网一双眼睛和一个大脑。

不相信我?你知道这篇文章中引用的每一张图片都是由视觉搜索算法选择的吗——不是我手动选择的。

没错—我编写了一个视觉搜索算法,它与段落中的上下文相匹配,从 100 个候选图像中选择正确的图像。

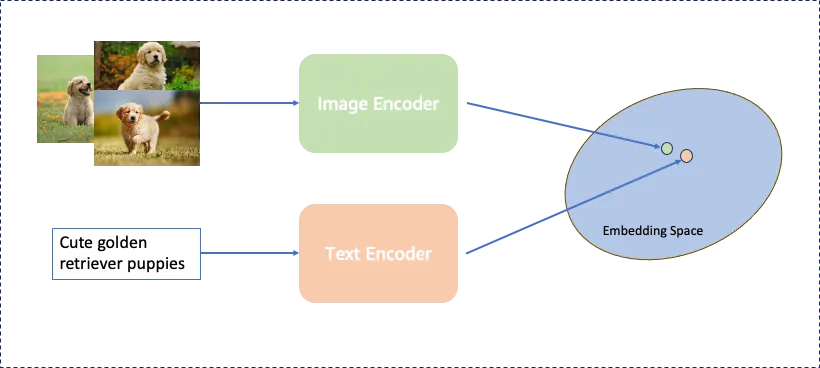

简单来说:多模态嵌入技术将视觉和文本数据融合在一起,将它们映射到统一的数字空间中。它创建了像人类一样“思考”的高级搜索引擎。

现在,无论你是在网上购物、探索创意设计、识别稀有植物还是为 Medium 文章选择相关图片,这项技术都可以将模糊猜测之类的东西抛到九霄云外。

好奇吗?让我们来揭秘多模态嵌入如何实现这一切,以及它们如何颠覆全球各行各业。

但首先 —

1、我的图像之旅

3 年来,我一直在努力解决为我的 AI 生成文章选择好图片的问题。

PS:别担心——这篇文章不是 AI 生成的——至少不是 100% AI 生成的——哈哈!

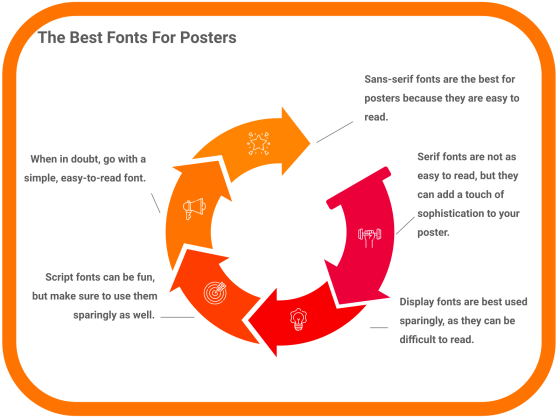

1.1 自动化生成的图像

在我的第一个方法中,我使用 Google 脚本自动化生成了类似信息图的图像。

好消息:它能够创建一些漂亮的图像,见下图:

坏消息:这是一种静态方法,一段时间后就变得无用了。每篇文章都有完全相同的外观和感觉。您可以在此处查看示例。

1.2 AI 生成的图像

在我的下一个迭代中,我使用了 SDXL 和 Dall-E 等 AI 图像生成器来生成图像。大多数人都熟悉这种方法。

这是一个使用提示的 AI 生成图像的示例:

好消息:它能够创建一些漂亮的图像,并且方法动态 - 因此您实际上可以根据提示和周围环境获得不同的图像。而且这些生成器正在变得更好。

坏消息:一段时间后,AI 生成的图像看起来很蹩脚。到目前为止,每次我看到 AI 机器人生成的 AI 图像时,我都想吐。你可以在此处查看包含 AI 生成图像的示例文章。

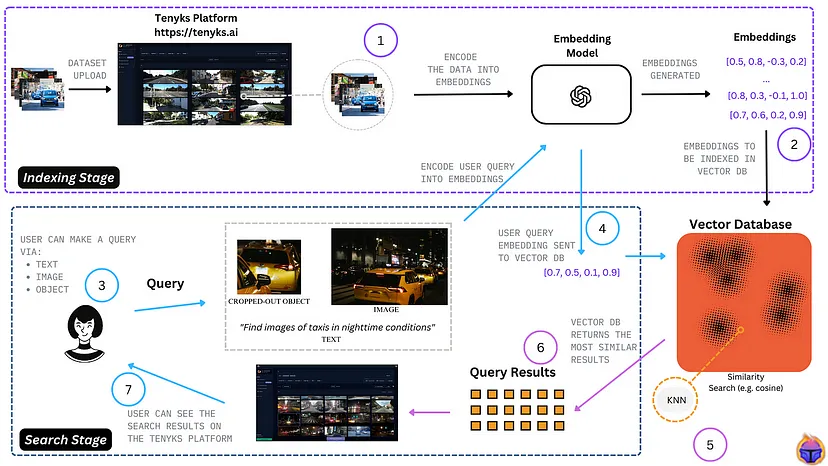

1.3 使用多模态嵌入进行视觉搜索

在我的当前迭代中,我使用 Cohere 的多模态嵌入从 100 张可能的图像集合中选择最佳图像。

流程如下:

- 构建集合:从 Google 图片搜索中获取 100 张图片,这些图片基于起始主题的 10 个不同查询视角。因此,在此示例中,我从查询“视觉搜索引擎:使用多模态嵌入来‘查看’图像”开始 - 从中生成 10 个衍生查询(使用 OpenAI o1),然后为每个查询获取 10 张图片 - 总共约 100 张图片。

- 嵌入图像:使用 Cohere 的多模态嵌入嵌入每个图像,并将每个向量存储在 Pinecone 中。

- 选择最佳图像:最后,为了找到给定段落的正确图像,我创建了该段落内容的提示,并从 Pinecone 中找到最佳向量。

因此,本文中带有可爱小狗的图像以及本文中引用的每张图片都是由算法选择的。

好消息:这创建了非常相关的来源/引用图像,并真正为文章提供了视觉效果。每幅图像通常都会为上下文提供大量附加信息,而不是提供乏味的图像,而这正是您希望图像实现的功能。

坏消息:目前,唯一的坏消息是您依赖引用/来源图像来增加视觉效果……这可能并不适合所有人。

2、视觉搜索的演变

让我们快速回顾一下。当视觉搜索工具首次出现时(我的意思是真正首次出现),它们仅限于表面级别的识别。

你向系统输入一张图片,然后砰的一声,系统就会吐出一些看起来有点相似的东西。但问题是,这些系统对“含义”或上下文一无所知。

例如,一张“蓝色花茶杯”的照片——即使嵌入了一些文本元标签——也会提供像普通的蓝色杯子一样的搜索结果。结果无法超越视觉共性或元数据。如果你想要具体性,那可就糟了。

随后出现了突破:研究人员不再单独处理图像和文本,而是开始将这两种数据类型输入共享的机器学习空间。

这种技术被称为多模态嵌入,它使搜索引擎能够理解事物的外观和描述方式。

突然间,游戏发生了变化。电子系统不再只是“猜测”。它们智能地匹配视觉图像和语言,以返回有意义的结果。

如今,谷歌、Pinterest、Cohere 和亚马逊等公司走在了前列,使用多模态嵌入重新定义我们如何驾驭数字世界。但这只是一个开始,因为这种能力还在不断扩展和改进。

3、我们为什么需要多模态嵌入?

如果你曾经在网上努力寻找精确匹配——无论是产品、服装还是鼓舞人心的装饰理念——就会明白为什么多模态嵌入在现代搜索中是不可协商的。

事情是这样的:传统搜索引擎严重依赖文本。当你输入“设计简约的灯”时,引擎会根据产品名称或描述中的索引关键字来解释这些词。但是,如果元数据中没有“正确”的描述怎么办?更糟糕的是,如果两盏不同的灯在技术上包含该文本,但在视觉上却完全不同,该怎么办?

多模态嵌入通过将视觉提示与文本元素相结合来填补这一空白。结果是搜索引擎不仅理解单词,还理解其上下文。

例如:

- 纯文本搜索:输入“现代橙色沙发”,并希望产品描述包含这三个词。

- 视觉+文本嵌入搜索:上传一张客厅氛围的照片,并将其与“寻找匹配的复古家具”配对,然后看看奇迹发生。

应用程序似乎无限。无论你是收集情绪板的艺术家,寻找那件复古皮夹克的沮丧购物者,还是浏览历史档案以查找书籍和图像的学者——多模态搜索让每个人都能发挥作用。

4、分解:什么是多模态嵌入?

我们不要把事情复杂化。从本质上讲,多模态嵌入系统集成了来自两个(或更多)来源的数据,例如图片和句子,并将它们映射到共享的“空间”中。

在这个数字空间中,相似性不仅仅是视觉上的——它们是语义上的。这意味着像“金毛猎犬小狗在草地上奔跑”这样的描述比单独的草地图像更接近真实的小狗图像。这些嵌入以传统系统永远无法做到的方式“组合”了概念。

以下是多模态嵌入与基本模型的不同之处:

- 传统嵌入处理一种类型的数据(基于文本的引擎将单词与单词进行匹配;仅视觉引擎将像素与像素进行匹配)。

- 多模态嵌入将多种数据类型对齐(例如“绿色山脉”的概念及其照片等价物)。

这种能力使新时代的搜索引擎在返回结果的方式上更智能、更快速、更人性化。

5、多模态与传统嵌入

让我们描绘一幅画面(字面意思):想象一下,您正在为您的家寻找哥特式吊灯。

传统搜索引擎依赖于文本元数据(某人在数据库中标记产品的程度)。如果库存中不存在这些关键词,您要么无法滚动,要么最终得到不相关的产品——游戏结束。

多模式嵌入将这一情况反转过来。它分析哥特式吊灯应该是什么样子(鲜明的对比、深沉的色调、华丽的细节),同时结合任何重叠的文本特征(如“金属”或“古董照明”)来提供精确匹配的列表。

6、这场革命为何重要

多模式嵌入不仅限于购物。它们已经将其实用性扩展到以下行业:

- 社交媒体:Instagram、Snapchat 或 Pinterest 等平台正在通过嵌入搜索个性化体验——照片与主题标签或描述相匹配。

- 医疗保健:医生将临床笔记与患者 X 光片混合以优化诊断。

- 图书馆和档案馆:结合手稿扫描 + 文本摘要,供寻求专业资源的研究人员使用。

- SEO:最后,是的,为 SEO 选择好的图片(如我上面的旅程所述)

令人着迷的是,这项技术会随着领域的发展而适应。“通用”搜索?那是昨天的新闻。多模态引擎是塑造未来行业的智能工具。

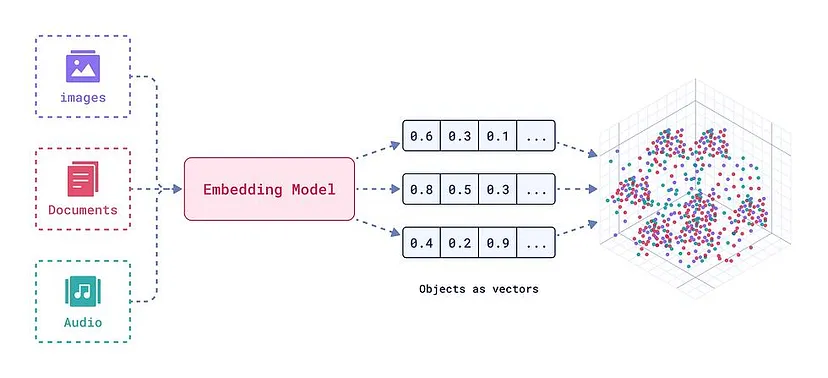

7、多模态嵌入的工作原理

好吧,对于任何问“但它是如何工作的?”的人,这是 TL;DR 版本:

- 深度学习基础:多模态嵌入使用高级神经网络(如 Transformer 模型和 CNN)。这些系统从单词和图像中“学习”模式。它们不是将输出分开,而是将数据合并为一个有凝聚力的“概念图”。

- 向量空间:将所有数据(图像、音频、GIF 等)视为 3D 散点图中的坐标,将类似的东西更紧密地分组在一起。

- 语境理解:得益于嵌入模型的对齐,系统可以更好地理解细微的变化 - 换句话说,输入和语境都更重要。

例如,“猫躺在阳光沙发上”这样的短语与一张照片有意义地联系在一起,而不是随机地与“猫”或“沙发”等关键词弱关联。

8、未来的实际应用

从 AR(增强现实)家庭助理到通过面部识别文本搜索预防犯罪,多模式技术似乎势不可挡。让我们来详细了解一下:

- 电子商务:虚拟购物变得更加直观——在咖啡馆拍一张鞋子的照片,然后立即购买!

- 健康诊断:实时将医学成像数据库(如 MRI)与症状记录相结合。

- 教育和大学:上传视觉效果以及书面查询,以查找适合研究的图表/视频 + 文本。

简而言之,任何与混合媒体相关的东西都是这项技术的游乐场。

9、未来道路上的挑战

但并非一切都是阳光明媚的。对于多模式系统,困难包括:

- 偏见风险:如果训练数据在地理或社会上存在偏差,未来的输出也会存在偏差。

- 权力斗争:较小的平台需要巨大的计算能力,但可能缺乏资源。

道德准则至关重要。平衡创新与包容性是该行业面临的下一个重大责任考验。

从本质上讲,多模式嵌入不仅仅是一种技术,而是一种思维方式。它是关于重新思考机器如何看待人类查询。随着每次更新,搜索引擎都在努力弥合人们的需求与数据库“思考”方式之间的差距。

我们正快速接近一个未来,在这个未来中,视觉输入不仅仅是搜索的补充,它们还驱动着搜索。多模式系统将不仅限于商店目录,它们将无处不在,从根本上重新构想工作、娱乐、研究和教育领域的工作流程。

保持兴奋。不久的将来,你可能不仅会“谷歌一下”,还可以多模式搜索。

原文链接:Visual Search Engines : Using Multi-Modal Embeddings to ‘Look’ at the Image

汇智网翻译整理,转载请标明出处